NVIDIAs neuestes offenes visuelles Sprachmodell, NVILA, hat bedeutende Durchbrüche in Bezug auf Genauigkeit und Effizienz erzielt und ist ein weiterer Meilenstein auf dem Gebiet der visuellen KI. Im Vergleich zu anderen großformatigen Vision-Modellen konnte NVILA erhebliche Einsparungen bei den Schulungskosten, der Speichernutzung und der Latenz erzielen. Darüber hinaus hat es in mehreren Benchmark-Tests eine hervorragende Leistung gezeigt und sogar einige Konkurrenten übertroffen. Der Artikel stellt die technischen Details von NVILA im Detail vor, einschließlich der „Erweiterung zuerst und später Komprimierung“-Technologie sowie dynamischer S2-Erweiterung, DeltaLoss-basierter Datensatzbereinigung und anderen Optimierungsstrategien, mit dem Ziel, die Genauigkeit und Effizienz des Modells in Einklang zu bringen. Dies markiert die Entwicklung der visuellen Sprachmodelltechnologie in eine wirtschaftlichere und effizientere Richtung.

Vor Kurzem hat NVIDIA eine neue Generation eines offenen visuellen Sprachmodells auf den Markt gebracht – NVILA. Entwickelt, um Genauigkeit und Effizienz zu optimieren, hat es sich mit seiner herausragenden Leistung zu einem führenden Unternehmen im Bereich der visuellen KI entwickelt.

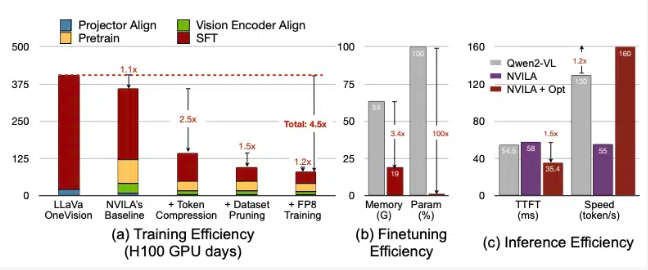

Laut NVIDIA reduziert NVILA die Trainingskosten um das 4,5-fache, den für die Feinabstimmung erforderlichen Speicher um das 3,4-fache und reduziert die Latenzen beim Vorfüllen und Dekodieren um fast das Zweifache. Diese Daten werden mit einem anderen großen Sehmodell, LLaVa OneVision, verglichen.

Bei Video-Benchmarks übertraf NVILA GPT4o Mini und schnitt auch im Vergleich mit GPT4o, Sonnet3.5 und Gemini1.5Pro gut ab. Darüber hinaus konnte NVILA auch im Vergleich mit Llama3.2 einen leichten Sieg erringen. Trotzdem gab NVIDIA an, dass das Modell noch nicht auf der Hugging Face-Plattform veröffentlicht wurde, und versprach, den Code und das Modell bald zu veröffentlichen, um die Reproduzierbarkeit des Modells zu fördern.

NVIDIA wies darauf hin, dass die Kosten für das Training visueller Sprachmodelle sehr hoch sind. Das Training eines visuellen Sprachmodells mit 7B-Parametern dauert etwa 400 GPU-Tage. Gleichzeitig ist die Feinabstimmung eines solchen Modells auch sehr speicherintensiv, da ein 7B-Parametermodell mehr als 64 GB GPU-Speicher erfordert.

Daher verwendet NVIDIA eine Technik namens „Erweitern und dann komprimieren“, um Modellgenauigkeit und Effizienz in Einklang zu bringen. Anstatt die Größe von Fotos und Videos zu reduzieren, verwendet das Modell mehrere Frames aus hochauflösenden Bildern und Videos, um sicherzustellen, dass keine Details verloren gehen.

Während des Komprimierungsprozesses reduziert das Modell die Größe der Eingabedaten, indem es visuelle Informationen in weniger Token komprimiert und Pixel gruppiert, um wichtige Informationen zu behalten. NVIDIA erwähnte in dem Papier, dass eine Verdoppelung der Auflösung die Anzahl der visuellen Token verdoppeln wird, was die Trainings- und Inferenzkosten um mehr als das Doppelte erhöhen wird. Daher reduzieren sie diese Kosten durch die Komprimierung von Raum-/Zeit-Tokens.

NVIDIA zeigte auch Demonstrationen einiger Modelle und NVILA kann mehrere Anfragen basierend auf einem Bild oder einem Video beantworten. Die Ausgabeergebnisse werden auch mit dem zuvor von NVIDIA veröffentlichten VILA1.5-Modell verglichen. Darüber hinaus stellte NVIDIA auch einige andere Technologien im Detail vor, wie z. B. dynamische S2-Erweiterung, DeltaLoss-basierte Datensatzbereinigung, Quantisierung mit FP8-Präzision usw.

Diese Techniken werden auf ein 8B-Parametermodell angewendet und die spezifischen Details können auf Arxiv angezeigt werden.

Papiereingang: https://arxiv.org/pdf/2412.04468

Highlight:

? Das NVILA-Modell reduziert die Schulungskosten um das 4,5-fache und verbessert so die Effizienz der visuellen KI.

?Mit hochauflösenden Bildern und Videobildern stellt NVILA die Integrität der Eingabeinformationen sicher.

? NVIDIA verspricht, bald Code und Modelle zu veröffentlichen, um die Reproduzierbarkeit der Forschung zu fördern.

Alles in allem hat das Aufkommen von NVILA neue Möglichkeiten für die Entwicklung visueller Sprachmodelle eröffnet. Sein effizienter Trainings- und Inferenzprozess wird die Schwelle für visuelle KI-Anwendungen senken und die weitere Entwicklung in diesem Bereich fördern. Wir freuen uns auf die baldige Offenlegung von Code und Modellen durch NVIDIA, damit mehr Forscher teilnehmen und gemeinsam den Fortschritt der visuellen KI-Technologie vorantreiben können.