Das Architekturdesign großer Sprachmodelle (LLM) unterliegt tiefgreifenden Veränderungen, und die Dominanz der Transformer-Architektur steht vor Herausforderungen. Um dieser Herausforderung zu begegnen, hat Liquid AI, ein am MIT gegründetes Startup, ein innovatives Framework namens STAR (Synthesis of Tailored Architectures) auf den Markt gebracht, das darauf abzielt, KI-Modellarchitekturen automatisch zu generieren und zu optimieren. Das STAR-Framework nutzt evolutionäre Algorithmen und hierarchische Codierungstechnologie, um Modellarchitekturen basierend auf spezifischen Leistungs- und Hardwareanforderungen zu synthetisieren und zu optimieren, was erhebliche Vorteile sowohl bei der Effizienz als auch bei der Leistung zeigt.

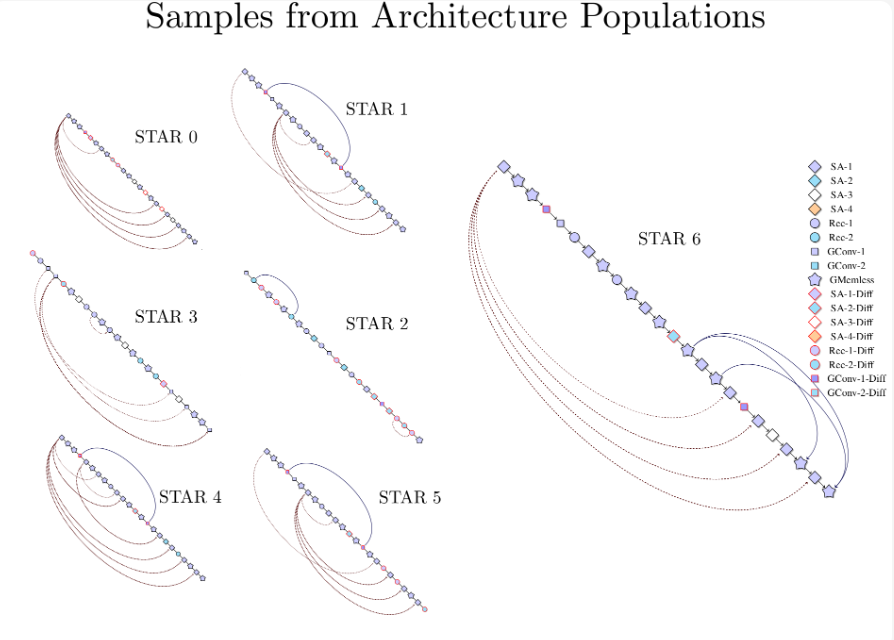

Das STAR-Framework nutzt evolutionäre Algorithmen und numerische Codierungssysteme, um die Generierung und Optimierung von Modellarchitekturen für künstliche Intelligenz zu automatisieren. Das Forschungsteam von Liquid AI stellte fest, dass sich der Designansatz von STAR vom traditionellen Architekturdesign dadurch unterscheidet, dass er eine hierarchische Codierungstechnik namens „STAR Genome“ verwendet, um einen breiten Designraum potenzieller Architekturen zu erkunden. Durch Genomkombination und Mutation ist STAR in der Lage, Architekturen zu synthetisieren und zu optimieren, die spezifische Leistungs- und Hardwareanforderungen erfüllen.

In Tests zur autoregressiven Sprachmodellierung zeigte STAR eine bessere Leistung als herkömmliche optimierte Transformer++- und Hybridmodelle. In Bezug auf Optimierungsqualität und Cache-Größe reduziert die weiterentwickelte Architektur von STAR die Cache-Größe um bis zu 37 % im Vergleich zum Hybridmodell und erreicht eine Reduzierung um 90 % im Vergleich zum herkömmlichen Transformer. Diese Effizienz beeinträchtigt nicht die Vorhersageleistung des Modells, übertrifft jedoch in einigen Fällen die Konkurrenz.

Untersuchungen zeigen außerdem, dass die Architektur von STAR hochgradig skalierbar ist, wobei ein STAR-Evolutionsmodell von 125 Millionen Parametern auf 1 Milliarde Parameter skaliert und bei Standard-Benchmarks genauso gut oder sogar besser als bestehende Transformer++- und Hybridmodelle abschneidet und gleichzeitig die Caching-Anforderungen deutlich reduziert.

Liquid AI sagte, dass das Designkonzept von STAR die Prinzipien dynamischer Systeme, Signalverarbeitung und numerischer linearer Algebra einbezieht, um einen flexiblen Suchraum für Recheneinheiten zu schaffen. Ein einzigartiges Merkmal von STAR ist sein modularer Aufbau, der es ermöglicht, Architekturen auf mehreren Ebenen zu kodieren und zu optimieren, was Forschern die Möglichkeit gibt, Einblicke in effektive Kombinationen von Architekturkomponenten zu gewinnen.

Liquid AI geht davon aus, dass die effizienten Architektursynthesefunktionen von STAR in verschiedenen Bereichen eingesetzt werden, insbesondere in Szenarien, in denen Qualität und Recheneffizienz in Einklang gebracht werden müssen. Obwohl Liquid AI keine spezifischen kommerziellen Einsatz- oder Preispläne angekündigt hat, stellen seine Forschungsergebnisse einen großen Fortschritt im Bereich des automatisierten Architekturdesigns dar. Während sich der Bereich der KI weiterentwickelt, könnten Frameworks wie STAR eine wichtige Rolle bei der Gestaltung der nächsten Generation intelligenter Systeme spielen.

Offizieller Blog: https://www.liquid.ai/research/automated-architecture-synthesize-via-targeted-evolution

Alles in allem bietet das STAR-Framework von Liquid AI eine neue automatisierte Methode für den Entwurf von KI-Modellarchitekturen. Seine Durchbrüche in Bezug auf Effizienz und Leistung sind von großer Bedeutung und bieten neue Möglichkeiten für die Entwicklung zukünftiger KI-Systeme. Der modulare Aufbau und die Skalierbarkeit des Frameworks eröffnen ihm zudem breite Einsatzmöglichkeiten in verschiedenen Bereichen.