Epoch AI hat kürzlich einen groß angelegten Rechenleistungssimulator für das Sprachmodelltraining veröffentlicht. Der Simulator bietet Forschern wertvolle Referenzen, indem er die Kosten und Effizienz des GPT-4-Trainings unter verschiedenen Hardwarebedingungen simuliert. Simulationsergebnisse zeigen, dass selbst mit einer alten Grafikkarte GTX580 aus dem Jahr 2012 GPT-4 trainiert werden kann, die Kosten jedoch zehnmal so hoch sein werden wie bei moderner Hardware, was die Bedeutung der Hardware-Leistungsverbesserung für das KI-Modelltraining unterstreicht. Der Simulator unterstützt auch die Trainingssimulation mit mehreren Rechenzentren, sodass Benutzer Parameter anpassen und die Leistungsunterschiede verschiedener Hardware- und Trainingsstrategien analysieren können. Dies bietet eine wichtige Entscheidungsgrundlage für das Training zukünftiger groß angelegter KI-Modelle.

Kürzlich hat das Forschungsunternehmen für künstliche Intelligenz, Epoch AI, einen interaktiven Simulator veröffentlicht, der speziell dafür entwickelt wurde, die Rechenleistung zu simulieren, die zum Trainieren großer Sprachmodelle erforderlich ist. Mithilfe dieses Simulators stellten die Forscher fest, dass es zwar möglich war, GPT-4 mit älteren Grafikkarten aus dem Jahr 2012, beispielsweise einer GTX580, zu trainieren, die Kosten jedoch zehnmal so hoch wären wie bei heutiger moderner Hardware.

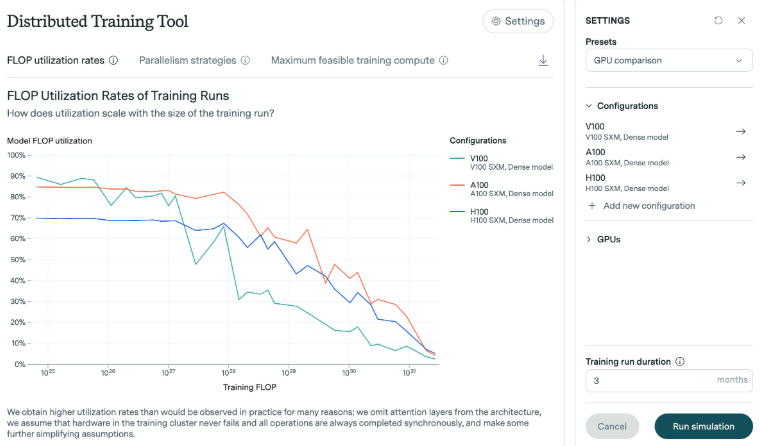

Untersuchungen von Epoch AI zeigen, dass die Anzahl der zum Trainieren von GPT-4 erforderlichen Gleitkommaoperationen (FLOPs) zwischen 1e25 und 1e26 liegt. Für diese Studie analysierte der Simulator die Effizienz verschiedener Grafikkarten, insbesondere bei der Skalierung des Modells. Die Ergebnisse zeigen, dass mit zunehmendem Modellwachstum die Effizienz im Allgemeinen abnimmt. Nehmen Sie als Beispiel die in den letzten Jahren eingeführte H100-Grafikkarte. Sie kann über einen langen Zeitraum eine hohe Effizienz aufrechterhalten, während die Effizienz der V100-Grafikkarte bei größeren Trainingsskalen deutlicher abnimmt.

In den Experimenten von Epoch AI betrug der Speicher der GTX580-Grafikkarte nur 3 GB. Diese Grafikkarte war die Mainstream-Wahl beim Training des AlexNet-Modells im Jahr 2012. Obwohl die Technologie fortgeschritten ist, glauben die Forscher, dass Schulungen in so großem Umfang mit älterer Hardware möglich sind, die dafür erforderlichen Ressourcen und Kosten jedoch unerschwinglich wären.

Darüber hinaus unterstützt der Simulator komplexe Trainingssimulationen über mehrere Rechenzentren hinweg. Benutzer können Parameter wie Rechenzentrumsgröße, Latenz und Verbindungsbandbreite anpassen, um Trainingsläufe über mehrere Standorte hinweg zu simulieren. Mit diesem Tool können außerdem Leistungsunterschiede zwischen modernen Grafikkarten (z. B. H100 und A100) analysiert, die Auswirkungen verschiedener Stapelgrößen und Multi-GPU-Trainings untersucht und detaillierte Protokolldateien erstellt werden, die die Ausgabe des Modells dokumentieren.

Epoch AI sagte, es habe den Simulator entwickelt, um sein Verständnis von Hardware-Effizienzverbesserungen zu vertiefen und die Auswirkungen von Chip-Exportkontrollen zu bewerten. Angesichts der erwarteten Zunahme groß angelegter Trainingsmissionen in diesem Jahrhundert ist es besonders wichtig, die in der Zukunft erforderlichen Hardwareanforderungen zu verstehen.

Alles in allem liefert diese Forschung und dieser Simulator von Epoch AI einen wichtigen Referenzwert für das Training großer Sprachmodelle und hilft Forschern, die Hardwareeffizienz besser zu verstehen, Trainingsstrategien zu optimieren und zuverlässigeres Training für zukünftige KI-Modelle bereitzustellen.