Große Sprachmodelle (LLMs) haben im Bereich der Verarbeitung natürlicher Sprache große Erfolge erzielt, ihre tokenbasierte Verarbeitung schränkt jedoch ihre Leistung beim Verständnis langer Texte sowie bei mehrsprachigen und multimodalen Anwendungen ein. Das von Meta AI vorgeschlagene Large Concept Model (LCM) bietet eine brandneue Lösung, die abstrakte semantische Einheiten – Konzepte – in einem hochdimensionalen Einbettungsraum betreibt und so die Einschränkungen von LLM überwindet. Die Innovation von LCM liegt in seinem sprach- und modalitätsunabhängigen Modellierungsansatz sowie seiner hierarchischen Architektur und seinem diffusionsbasierten Generierungsmechanismus. Dies ermöglicht LCM eine effiziente, skalierbare Sprachmodellierung mit starken Zero-Shot-Generalisierungsfähigkeiten.

Große Sprachmodelle (LLMs) haben im Bereich der Verarbeitung natürlicher Sprache (NLP) erhebliche Fortschritte gemacht und sind daher in Anwendungen wie der Textgenerierung, -zusammenfassung und der Beantwortung von Fragen beliebt. Allerdings bringt die Abhängigkeit von LLM von der Verarbeitung auf Token-Ebene (Vorhersage jeweils eines Wortes) auch einige Herausforderungen mit sich. Dieser Ansatz steht im Gegensatz zur Art und Weise, wie Menschen kommunizieren, die typischerweise auf einer höheren Abstraktionsebene, etwa in Form von Sätzen oder Ideen, ablaufen.

Die Modellierung auf Token-Ebene ist auch bei Aufgaben unzureichend, die ein umfassendes Verständnis des Kontexts erfordern und zu inkonsistenten Ergebnissen führen können. Darüber hinaus ist die Ausweitung dieser Modelle auf mehrsprachige und multimodale Anwendungen rechenintensiv und datenintensiv. Um diese Probleme zu lösen, schlugen Forscher von Meta AI eine neue Methode vor: Large Conceptual Model (LCM).

Große konzeptionelle Modelle: Ein neues Paradigma für semantisches Verständnis

Das große konzeptionelle Modell (LCM) von Meta AI stellt eine Abkehr von der traditionellen LLM-Architektur dar. LCM führt zwei wichtige Neuerungen ein:

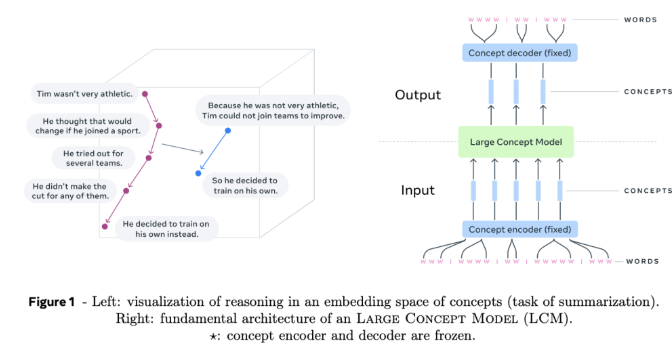

Hochdimensionale Einbettungsraummodellierung: LCM arbeitet nicht mehr mit diskreten Token, sondern führt Berechnungen in einem hochdimensionalen Einbettungsraum durch. Dieser Raum repräsentiert abstrakte Bedeutungseinheiten, sogenannte Konzepte, die Sätzen oder Äußerungen entsprechen. Dieser Einbettungsraum namens SONAR ist sprach- und modalitätsunabhängig und unterstützt mehr als 200 Sprachen und mehrere Modalitäten, einschließlich Text und Sprache.

Sprach- und modalitätsunabhängige Modellierung: Im Gegensatz zu Modellen, die an eine bestimmte Sprache oder Modalität gebunden sind, verarbeitet und generiert LCM Inhalte auf rein semantischer Ebene. Dieses Design ermöglicht einen nahtlosen Wechsel zwischen Sprachen und Modalitäten, was zu einer starken Zero-Shot-Generalisierung führt.

Das Herzstück von LCM sind Konzept-Encoder und -Decoder, die Eingabesätze dem Einbettungsraum von SONAR zuordnen und die Einbettungen zurück in natürliche Sprache oder andere Modalitäten dekodieren. Diese Komponenten sind eingefroren, was Modularität und eine einfache Erweiterung auf neue Sprachen oder Modalitäten gewährleistet, ohne das gesamte Modell neu zu trainieren.

Technische Details und Vorteile von LCM

LCM führt mehrere Innovationen ein, um die Sprachmodellierung voranzutreiben:

Schichtarchitektur: LCM verwendet eine Schichtstruktur, die den menschlichen Denkprozess widerspiegelt. Dieses Design verbessert die Kohärenz für lange Inhalte und ermöglicht eine lokale Bearbeitung, ohne den größeren Kontext zu zerstören.

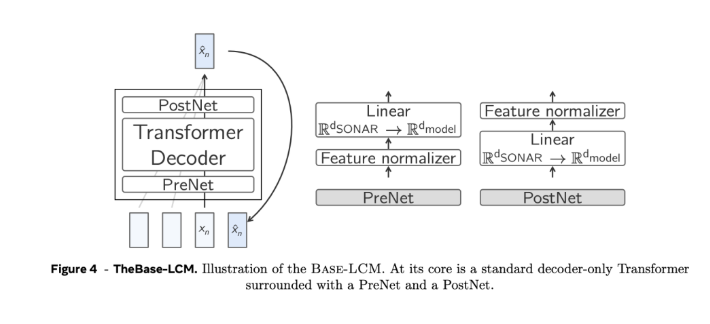

Diffusionsbasierte Erzeugung: Das Diffusionsmodell gilt als das effizienteste Design von LCM. Diese Modelle sagen die nächste SONAR-Einbettung basierend auf der vorherigen Einbettung voraus. Es wurden zwei Architekturen untersucht:

Single Tower: Ein einzelner Transformer-Decoder übernimmt die Kontextkodierung und Rauschunterdrückung.

Twin Towers: Getrennte Kontextkodierung und Rauschunterdrückung, Bereitstellung dedizierter Komponenten für jede Aufgabe.

Skalierbarkeit und Effizienz: Im Vergleich zur Verarbeitung auf Token-Ebene reduziert die Modellierung auf Konzeptebene die Sequenzlängen, löst die quadratische Komplexität von Standard-Transformern auf und kann lange Kontexte effizienter verarbeiten.

Zero-Shot-Generalisierung: LCM weist starke Zero-Shot-Generalisierungsfähigkeiten über unbekannte Sprachen und Modalitäten hinweg auf, indem es die umfassende mehrsprachige und multimodale Unterstützung von SONAR nutzt.

Such- und Stoppkriterien: Suchalgorithmus mit Stoppkriterien, die auf der Distanz zum Konzept „Ende des Dokuments“ basieren und eine kohärente und vollständige Generierung ohne die Notwendigkeit einer Feinabstimmung gewährleisten.

Alles in allem bringt das große konzeptionelle Modell (LCM) von Meta AI neue Ideen in den Bereich der Verarbeitung natürlicher Sprache. Seine Vorteile bei der Verarbeitung von Langtext-, mehrsprachigen und multimodalen Daten weisen auf eine wichtige Richtung für die zukünftige Entwicklung von Sprachmodellen hin. . Das Aufkommen von LCM wird die Fähigkeiten der künstlichen Intelligenz bei der sprach- und modalübergreifenden Informationsverarbeitung erheblich verbessern und ihre Anwendungen auf weitere Bereiche erweitern.