Das Sprachteam von Alibaba Tongyi Lab hat CosyVoice 2.0 auf den Markt gebracht. Dieses große Open-Source-Sprachgenerierungsmodell hat einen bedeutenden Durchbruch in der Sprachsynthesetechnologie erzielt. Im Vergleich zur Vorgängerversion hat CosyVoice 2.0 die Genauigkeit, Stabilität und Natürlichkeit erheblich verbessert, eine Zwei-Wege-Streaming-Sprachsynthese realisiert und die Syntheseverzögerung deutlich reduziert. Dieses Upgrade spiegelt sich nicht nur im technischen Niveau wider, sondern bringt auch einen qualitativen Sprung in der Benutzererfahrung mit sich und bietet Benutzern umfangreichere und komfortablere Sprachsynthesedienste.

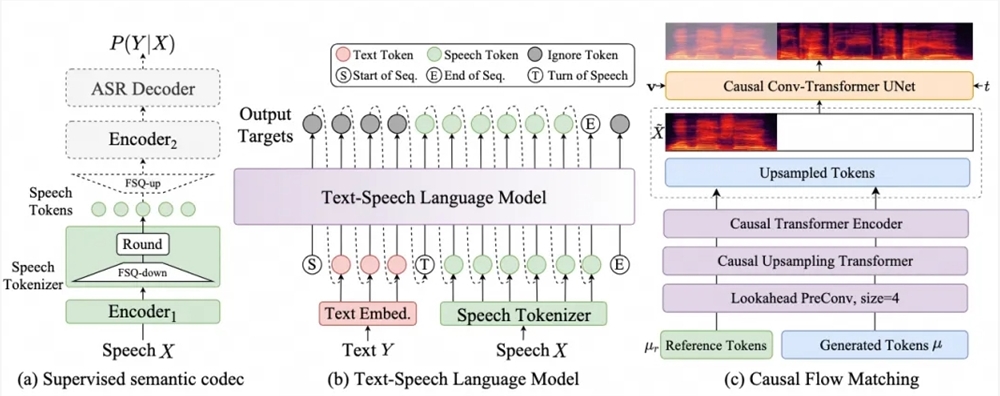

Das Sprachteam von Alibaba Tongyi Lab gab bekannt, dass sein großes Open-Source-Sprachgenerierungsmodell CosyVoice auf Version 2.0 aktualisiert wurde. Dieses Upgrade stellt eine deutliche Verbesserung der Genauigkeit, Stabilität und des natürlichen Erlebnisses der Sprachgenerierungstechnologie dar. CosyVoice2.0 nutzt die Sprachgenerierungs-Großmodelltechnologie, die Offline- und Streaming-Modellierung integriert, um eine bidirektionale Streaming-Sprachsynthese zu erreichen. Die Verzögerung der ersten Paketsynthese kann 150 ms erreichen, was die Reaktionsgeschwindigkeit der Sprachsynthese erheblich verbessert.

In Bezug auf die Aussprachegenauigkeit weist CosyVoice2.0 im Vergleich zur Vorgängerversion eine Reduzierung der Fehlerrate um 30 % bis 50 % auf. Es hat die niedrigste Wortfehlerrate im harten Testsatz des Seed-TTS-Testsatzes erreicht, insbesondere in der synthetischen Sprache Twisters, Hervorragende Leistung bei polyphonen Charakteren und seltenen Charakteren. Darüber hinaus behält Version 2.0 die Klangkonsistenz bei der Null-Sample-Spracherzeugung und der sprachübergreifenden Sprachsynthese bei. Insbesondere wurde die Fähigkeit zur sprachübergreifenden Sprachsynthese im Vergleich zu Version 1.0 erheblich verbessert.

CosyVoice2.0 hat auch den Rhythmus, die Klangqualität und die emotionale Anpassung von synthetisiertem Audio verbessert. Der MOS-Bewertungswert stieg von 5,4 auf 5,53, was nahe am Wert eines großen kommerziellen Sprachsynthesemodells liegt. Gleichzeitig unterstützt Version 2.0 eine feinkörnigere Emotionskontrolle und Dialektakzentkontrolle und bietet Benutzern eine umfassendere Sprachauswahl, einschließlich wichtiger Dialekte wie Kantonesisch, Sichuan-Dialekt, Zhengzhou-Dialekt, Tianjin-Dialekt und Changsha-Dialekt sowie Rollen- Spielfunktionen wie Roboter imitieren, Sprache im Peppa-Wutz-Stil usw.

Das Upgrade von CosyVoice2.0 verbessert nicht nur die Sprachsynthesetechnologie und -erfahrung, sondern fördert auch die Entwicklung der Open-Source-Community weiter und ermutigt mehr Entwickler, sich an der Innovation und Anwendung der Sprachverarbeitungstechnologie zu beteiligen.

GitHub-Repository: CosyVoice (https://github.com/FunAudioLLM/CosyVoice) Schauen Sie sich das neueste aktualisierte CosyVoice2 an

Erleben Sie die DEMO online: https://www.modelscope.cn/studios/iic/CosyVoice2-0.5B

Open-Source-Code: https://github.com/FunAudioLLM/CosyVoice

Open-Source-Modell: https://www.modelscope.cn/models/iic/CosyVoice2-0.5B

Die offene Quelle von CosyVoice 2.0 wird die Popularisierung und Entwicklung der Sprachsynthesetechnologie weiter vorantreiben, Entwicklern und Forschern leistungsstarke Werkzeuge und Ressourcen zur Verfügung stellen und sich auf die Entstehung innovativerer Anwendungen freuen. Willkommen zum Besuch des bereitgestellten Links zum Erleben und Herunterladen.