Ein reibungsloser Mensch-Maschine-Dialog ist ein wichtiges Ziel im Bereich der künstlichen Intelligenz. Allerdings hat die KI oft Probleme, das „Ende der Runde“ einzuschätzen, was zu einem schlechten Gesprächserlebnis führt. Benutzer stoßen häufig auf KI-Unterbrechungen oder Reaktionsverzögerungen, was die Effizienz und Natürlichkeit der Mensch-Computer-Interaktion erheblich beeinträchtigt. Herkömmliche Methoden zur Sprachaktivitätserkennung (VAD) sind zu einfach, werden leicht durch Umgebungsgeräusche und Benutzerpausen beeinträchtigt und können das Ende eines Gesprächs nicht genau bestimmen.

In der Welt des Mensch-Maschine-Dialogs ist das Schwierigste: „Haben Sie zu Ende gesprochen?“ Dieser Satz mag einfach erscheinen, ist aber zu einer Hürde geworden, die unzählige Sprachassistenten und Kundendienstroboter nicht überwinden können. Begegnen Sie oft dieser Situation: Sie haben gerade einen Moment innegehalten, um darüber nachzudenken, was Sie als nächstes sagen sollen, aber die KI kann es kaum erwarten, zu antworten, oder Sie haben offensichtlich mit dem Sprechen fertig, aber die KI wartet noch dumm, bis man nicht anders kann, als zu sagen „Ich bin fertig“ und es nicht reagiert. Dieses Erlebnis ist einfach verrückt.

Das liegt nicht daran, dass die KI absichtlich Ärger macht, sondern daran, dass sie bei der Beurteilung des „End of Turn“ (EOT) wie ein „Blinder“ ist, der nur hören kann, ob ein Geräusch zu hören ist, es aber nicht herausfinden kann ob du einen Ton hast oder nicht. Noch nicht fertig. Die traditionelle Methode basiert hauptsächlich auf der Sprachaktivitätserkennung (VAD), die wie ein „sprachaktivierter Schalter“ ist und nur darauf achtet, ob ein Sprachsignal vorhanden ist Kann das durch Pausen und Hintergrundgeräusche verwechselt werden? Es ist einfach zu „einfach“!

Doch vor kurzem konnte ein Unternehmen namens Livekit es nicht mehr ertragen und beschloss, ein intelligenteres „Gehirn“ auf KI zu installieren. Sie haben ein Open-Source-Modell zur präzisen Erkennung von Sprachwendungen entwickelt. Dieses Modell ist wie ein echter Meister des „Gedankenlesens“ und kann genau feststellen, ob Sie mit dem Sprechen fertig sind. Dabei handelt es sich nicht um einen einfachen „sprachaktivierten Schalter“, sondern um einen „intelligenten Assistenten“, der die Absicht Ihrer Worte verstehen kann!

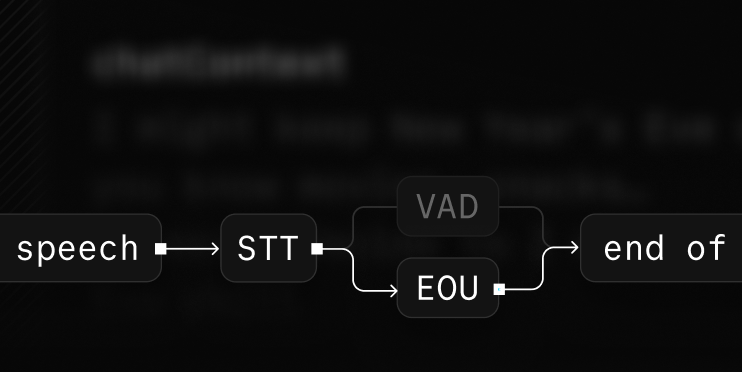

Das Tolle am Livekit-Modell ist, dass es sich nicht einfach darauf verlässt, „ob Ton vorhanden ist“, sondern das Transformer-Modell mit der traditionellen Sprachaktivitätserkennung (VAD) kombiniert. Das ist so, als würde man die KI mit einem „Superhirn“ und einem „Ohr“ ausstatten. Das „Shunfeng-Ohr“ ist dafür verantwortlich, zu überwachen, ob Geräusche vorhanden sind, während das „Superhirn“ für die Analyse der Semantik dieser Geräusche verantwortlich ist, um zu verstehen, ob Ihre Wörter vollständig sind und ob es eine unvollständige Bedeutung gibt. Die leistungsstarke Kombination dieser beiden kann wirklich eine genaue „End-of-Round-Erkennung“ erreichen.

Was kann dieses Modell? Es ermöglicht KI-Partnern wie Sprachassistenten und Kundendienstrobotern, genauer zu bestimmen, ob Sie mit dem Sprechen fertig sind, bevor sie beginnen, Ihnen zu antworten. Dies wird zweifellos den reibungslosen und natürlichen Dialog zwischen Mensch und Maschine verbessern. Wenn Sie in Zukunft mit KI chatten, müssen Sie keine Angst mehr haben, von ihr „gestohlen“ oder „dumm gestellt“ zu werden!

Um ihre Stärke unter Beweis zu stellen, zeigte Livekit auch ihre Testergebnisse: Ihr neues Modell kann die „falschen Unterbrechungen“ der KI um 85 % reduzieren. Dies bedeutet, dass die KI natürlicher und weniger anfällig für Fehleinschätzungen wird und auch die Gespräche am Telefon mit Menschen verbunden sind! glatter und angenehmer. Denken Sie darüber nach: Wenn Sie in Zukunft den Kundendienst anrufen, werden Sie sich nicht mehr über die mechanischen Antworten der KI aufregen, sondern können sich genauso wohl fühlen wie beim Chatten mit einer echten Person. Diese Erfahrung ist einfach erstaunlich!

Darüber hinaus eignet sich dieses Modell besonders für Szenarien, die einen Mensch-Maschine-Dialog erfordern, wie z. B. Sprachkundendienst, intelligente Frage- und Antwortroboter usw. Livekit zeigte auch sorgfältig ein Demonstrationsvideo. Der KI-Agent im Video wartet nach Erhalt der Frage des Benutzers geduldig, bis der Benutzer alle Informationen vervollständigt hat, bevor er die entsprechende Antwort gibt. Dies ist wie eine „intime Person“, die Ihre Bedürfnisse wirklich versteht. Er wird sich nicht „einmischen“, bevor Sie mit dem Sprechen fertig sind, und er wird auch nicht „fassungslos“ bleiben, wenn Sie mit dem Sprechen fertig sind.

Natürlich befindet sich dieses Modell noch im Open-Source-Stadium und es gibt noch viel Raum für Verbesserungen. Wir haben jedoch Grund zu der Annahme, dass die Kommunikation zwischen Mensch und Maschine mit der kontinuierlichen Weiterentwicklung der Technologie in Zukunft natürlicher, reibungsloser und intelligenter werden wird. Vielleicht werden wir eines Tages wirklich vergessen, dass wir mit einer kalten Maschine sprechen, sondern mit einem „KI-Partner“, der Sie wirklich versteht.

Projektadresse: https://github.com/livekit/agents/tree/main/livekit-plugins/livekit-plugins-turn-detector

Das Open-Source-Modell von Livekit liefert neue Ideen zur Lösung des „End-of-Turn“-Problems im Mensch-Computer-Dialog und markiert einen Schritt in Richtung einer natürlicheren und reibungsloseren Mensch-Computer-Interaktionserfahrung. Wir freuen uns auf die weitere Verbesserung und Anwendung dieses Modells in der Zukunft, um Benutzern ein komfortableres und intelligenteres Gesprächserlebnis zwischen Mensch und Maschine zu bieten.