OpenAI hat eine neue Generation des Inferenzmodells o3 und seine optimierte Version o3-mini veröffentlicht, die die Nachfolger der o1-Serie sind und darauf ausgelegt sind, die Genauigkeit der Beantwortung von Fragen durch tieferes Denken zu verbessern. o3 hat im ARC-AGI-Benchmark bahnbrechende Fortschritte erzielt und seine Fähigkeiten zur Problemlösung nahezu auf menschlichem Niveau demonstriert. o3-mini setzt auf Schnelligkeit und Wirtschaftlichkeit und eignet sich besonders für Programmieraufgaben. Während die Modelle der o3-Serie nicht direkt für die Öffentlichkeit freigegeben werden, hat OpenAI sie Sicherheitsforschern zur Vorschau zugänglich gemacht.

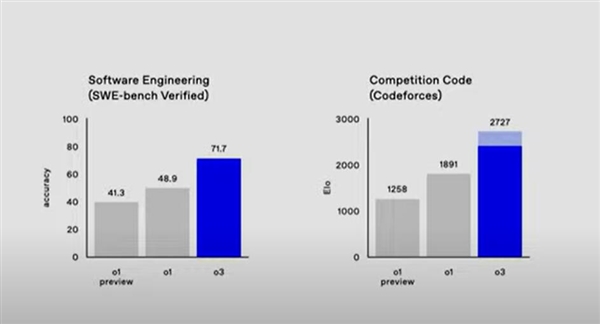

Das o3-Modell schneidet in mehreren Benchmarks gut ab. Beispielsweise ist die Genauigkeit beim SWE-Bench-Verified-Benchmark um mehr als 20 % höher als bei o1, und auch die Genauigkeit bei Wettbewerbsmathematik und GPQA Diamond ist deutlich verbessert. OpenAI hat außerdem eine neue Sicherheitsbewertungsmethode namens „Deliberative Alignment“ eingeführt, um die Modellsicherheit und die Einhaltung von Sicherheitsspezifikationen sicherzustellen. Derzeit wird OpenAI externen Sicherheitstests unterzogen und hat Early-Access-Anwendungen geöffnet.

In Bezug auf Programmierung und mathematische Problemlösung hat das o3-Modell bemerkenswerte Fähigkeiten bewiesen. Im SWE-Bench-Verified-Benchmark beträgt die Genauigkeit von o3 etwa 71,7 % und ist damit mehr als 20 % höher als beim o1-Modell. In der Wettbewerbsordnung erhielt o3 einen Elo-Wert von 2727, während o1 nur 1891 erhielt. Darüber hinaus erreichte die Genauigkeit von o3 in der Wettbewerbsmathematik 96,7 % und die Genauigkeit in GPQA Diamond erreichte 87,7 %, was fast 10 % höher als bei o1 ist.

OpenAI hat außerdem eine neue Sicherheitsbewertungsmethode eingeführt – die deliberative Ausrichtung. Dabei handelt es sich um ein neues Paradigma, das die Sicherheitsspezifikationen des Modells direkt lehrt und das Modell trainieren kann, die Spezifikationen explizit abzurufen und vor der Antwort eine genaue Argumentation durchzuführen. Dieser Ansatz wird verwendet, um die O-Serien-Modelle von OpenAI auszurichten und eine hochpräzise Einhaltung der Sicherheitsrichtlinien von OpenAI zu erreichen.

Derzeit fördert OpenAI externe Sicherheitstests und hat auf der Website Early-Access-Anträge gestellt. Bewerber müssen ein Online-Formular ausfüllen und relevante Informationen angeben. Ausgewählte Forscher erhalten Zugang zu o3 und o3-mini, um ihre Fähigkeiten zu erkunden und zu Sicherheitsbewertungen beizutragen.

Die Veröffentlichung der Modelle der OpenAI o3-Serie stellt eine deutliche Verbesserung der Denkfähigkeiten der künstlichen Intelligenz dar und ihre herausragende Leistung in mehreren Bereichen läutet eine neue Richtung für die zukünftige Entwicklung der KI-Technologie ein. Wir werden auch in Zukunft auf den Fortschritt und die Anwendung der Modelle der o3-Serie achten.