Das Zhiyuan Research Institute und Tencent haben gemeinsam LongBench v2 veröffentlicht, eine Benchmark-Testplattform zur Bewertung des Langtextverständnisses und der Argumentationsfähigkeiten großer Sprachmodelle (LLMs). LongBench v2 verbessert die Textlänge und den Schwierigkeitsgrad der Bewertung erheblich, einschließlich 503 anspruchsvoller Multiple-Choice-Fragen mit vier Auswahlmöglichkeiten, was es selbst menschlichen Experten schwierig macht, in kurzer Zeit eine hohe Genauigkeit zu erreichen. Der Benchmark deckt sechs Hauptaufgabenkategorien ab und umfasst Verbesserungen der Bewertungsmethodik, um die Zuverlässigkeit und Genauigkeit der Ergebnisse zu erhöhen. Dieser Schritt zielt darauf ab, den Fortschritt großer Sprachmodelle in der Langtextverarbeitung zu fördern und ein effektiveres Bewertungstool für die damit verbundene Forschung bereitzustellen.

Auf einer Pressekonferenz am 19. Dezember 2024 gaben das Zhiyuan Research Institute und Tencent die Einführung von LongBench v2 bekannt, das darauf ausgelegt ist, das tiefe Verständnis und die Argumentationsfähigkeiten großer Sprachmodelle (LLMs) in realen Langtext-Multitaskings zu bewerten. Entwickelte Benchmarks. Die Plattform zielt darauf ab, den Fortschritt von Langtextmodellen beim Verstehen und Denken zu fördern und reagiert auf die aktuellen Herausforderungen bei der Anwendung von Langtext- und großen Sprachmodellen.

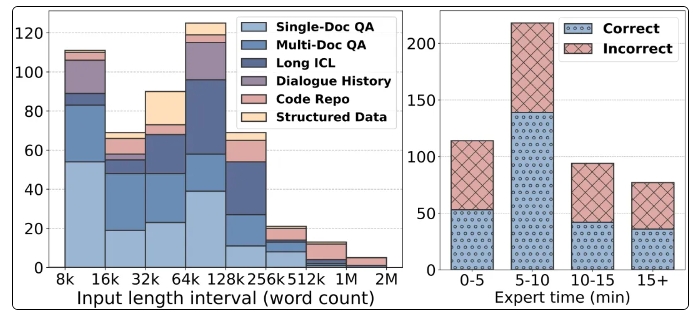

Zu den bemerkenswerten Funktionen von LongBench v2 gehört die Unterstützung längerer Textlängen von 8.000 bis 2 Millionen Wörtern und enthält 503 anspruchsvolle Multiple-Choice-Fragen mit vier Auswahlmöglichkeiten und höherem Schwierigkeitsgrad, selbst die durchschnittliche Genauigkeit menschlicher Experten in 15 Minuten. Die Quote beträgt nur 53,7 %. . Darüber hinaus deckt der Benchmark sechs Hauptaufgabenkategorien ab, darunter Fragen und Antworten für einzelne Dokumente, Fragen und Antworten für mehrere Dokumente, Kontextlernen mit langen Texten usw., wodurch ein breites Spektrum an Anwendungsszenarien gewährleistet wird.

Um die Zuverlässigkeit der Bewertung sicherzustellen, liegen alle Fragen in LongBench v2 in Form von Multiple-Choice-Fragen vor und durchlaufen einen strengen manuellen Bewertungs- und Überprüfungsprozess. Während des Datenerhebungsprozesses wurden Kommentatoren von Spitzenuniversitäten rekrutiert, um die Qualität und den Schwierigkeitsgrad der Fragen sicherzustellen. Durch die Einführung von Kontrollvariablen verbessert LongBench v2 den ursprünglichen statistischen Bradley-Terry-Algorithmus, reduziert die Auswirkungen von Störfaktoren und macht das Modellranking wissenschaftlicher und genauer.

Was die Bewertungsergebnisse betrifft, testete das Forschungsteam 10 Open-Source-LLMs und 6 Closed-Source-LLMs und stellte fest, dass die Leistung des Modells nach Einführung von Kontrollvariablen deutlich verbessert wurde. Insbesondere schneidet das GPT-4o-Modell gut bei Aufgaben wie der Beantwortung von Fragen in mehreren Dokumenten und dem Lernen von Langtextkontexten ab, nachdem mehr Argumentationsschritte eingeführt wurden, was die Bedeutung von Argumentationsfähigkeiten zeigt.

Die Einführung von LongBench v2 bietet nicht nur ein neues Tool für die Bewertung großer Sprachmodelle, sondern weist auch die Richtung für zukünftige Forschungen vor und betont die Bedeutung der Verbesserung des eigenen Verständnisses und der Argumentationsfähigkeiten des Modells. Die Zusammenarbeit zwischen dem Zhiyuan Research Institute und Tencent stellt eine weitere Entwicklung im Bereich der KI-Technologie dar. Es wird erwartet, dass dieser Benchmark-Test die Weiterentwicklung der Langtextverständnis- und Argumentationstechnologie vorantreiben kann.

Startseite: https://longbench2.github.io

Papier: https://arxiv.org/abs/2412.15204

Daten und Code: https://github.com/THUDM/LongBench

Die Veröffentlichung von LongBench v2 markiert eine neue Stufe in der Evaluierung großer Sprachmodelle. Die strengeren Evaluierungsstandards und umfassenderen Testinhalte werden dazu beitragen, die kontinuierliche Verbesserung der Fähigkeiten zum Verstehen und Denken langer Texte bei großen Sprachmodellen voranzutreiben. Wir freuen uns darauf, dass in Zukunft weitere Forschungsergebnisse auf Basis von LongBench v2 erscheinen, um die Entwicklung der KI-Technologie weiter voranzutreiben.