Apple hat kürzlich einen großen Durchbruch bei der Geschwindigkeit der Generierung großer Sprachmodelle (LLM) erzielt und mit NVIDIA zusammengearbeitet, um die Generierungsgeschwindigkeit mithilfe der Open-Source-Technologie Recurrent Drafter (ReDrafter) nahezu zu verdreifachen. ReDrafter verwendet eine spekulative Dekodierungsmethode, um die Effizienz des Modelltrainings deutlich zu verbessern, und ist in NVIDIAs TensorRT-LLM-Inferenzbeschleunigungs-Framework integriert, um Nutzungskosten und Latenz weiter zu reduzieren. Diese Zusammenarbeit verbessert nicht nur die Entwicklungseffizienz, sondern bietet den Benutzern auch ein schnelleres Serviceerlebnis, was Apples Entschlossenheit und Stärke unterstreicht, weiterhin Innovationen im Bereich KI voranzutreiben. In diesem Artikel werden die Einzelheiten der Zusammenarbeit zwischen Apple und NVIDIA sowie die Vorteile der ReDrafter-Technologie detailliert beschrieben.

Aktuelle Untersuchungen von Apple im Bereich maschinelles Lernen zeigen, dass Apple durch die Zusammenarbeit mit NVIDIA die Generierungsgeschwindigkeit großer Sprachmodelle (LLM) erfolgreich um fast das Dreifache erhöht hat. Der Schlüssel zu diesem Fortschritt liegt in Apples Open-Source-Technologie „Recurrent Drafter“ (ReDrafter), die eine spekulative Dekodierungsmethode verwendet, die die Effizienz des Modelltrainings deutlich verbessern kann.

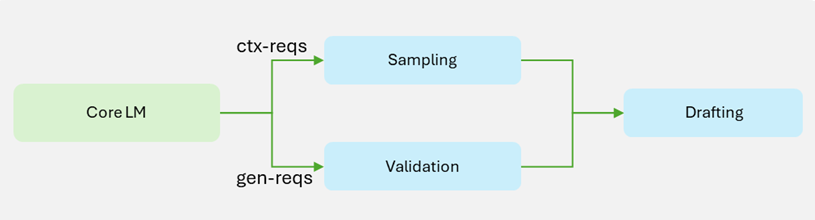

In der Vergangenheit war die Erstellung großer Sprachmodelle in der Regel sehr zeitaufwändig und ressourcenintensiv, und Unternehmen mussten oft eine große Anzahl von Hardwaregeräten anschaffen, was die Betriebskosten erhöhte. Anfang 2024 veröffentlichte Apple ReDrafter, eine Technologie, die rekursive neuronale Netze und dynamische Baum-Aufmerksamkeitsmethoden kombiniert, um Tags schnell zu generieren und zu überprüfen und die Geschwindigkeit der Tag-Generierung im Vergleich zu herkömmlichen automatischen Regressionsmethoden um das 3,5-fache zu erhöhen.

Diese Woche gab Apple außerdem bekannt, dass die Zusammenarbeit mit NVIDIA ReDrafter in NVIDIAs TensorRT-LLM-Inferenzbeschleunigungs-Framework integrieren wird. Dieser Schritt wird es Entwicklern maschinellen Lernens, die NVIDIA-GPUs verwenden, ermöglichen, die Beschleunigungsfunktionen von ReDrafter in Produktionsumgebungen zu nutzen. Erwähnenswert ist, dass leistungsstarke Multi-GPU-Server zwar in der Regel teuer sind, diese Zusammenarbeit jedoch die Latenz reduzieren und gleichzeitig die Menge an erforderlicher Hardware reduzieren kann, was zu einer wirtschaftlicheren Lösung führt.

In Benchmark-Tests mit NVIDIA wurde die Generierungseffizienz mit ReDrafter deutlich verbessert, mit einer 2,7-fachen Steigerung der Token-Generierung pro Sekunde im Greedy-Codierungsmodus. Dies bedeutet, dass Entwickler in kürzerer Zeit mehr Ergebnisse erzielen und Benutzern ein schnelleres Serviceerlebnis bieten können.

Nach der Bestätigung der Zusammenarbeit mit NVIDIA gab Apple außerdem an, dass man den Einsatz des Trainium2-Chips von Amazon erwäge, um die Effizienz des Modelltrainings zu verbessern. Es wird erwartet, dass die Effizienz des Pre-Trainings mit Trainium2 im Vergleich zu vorhandener Hardware um 50 % verbessert wird.

Offizieller Blog: https://developer.nvidia.com/blog/nvidia-tensorrt-llm-now-supports-recurrent-drafting-for-optimizing-llm-inference/

Höhepunkte:

Apple arbeitet mit NVIDIA zusammen, um die Geschwindigkeit der Generierung großer Sprachmodelle nahezu zu verdreifachen.

Die Open-Source-Technologie ReDrafter kombiniert mit rekurrenten neuronalen Netzen, um die Effizienz des Modelltrainings deutlich zu verbessern.

Diese Zusammenarbeit trägt dazu bei, Kosten zu senken und effizientere Lösungen für Entwickler von maschinellem Lernen bereitzustellen.

Insgesamt haben die Zusammenarbeit zwischen Apple und NVIDIA und der Einsatz der ReDrafter-Technologie zu erheblichen Effizienzsteigerungen und Kostensenkungen bei der Entwicklung und Anwendung großer Sprachmodelle geführt. Dies fördert nicht nur den technologischen Fortschritt im Bereich der künstlichen Intelligenz, sondern bietet auch komfortablere und wirtschaftlichere Lösungen für Entwickler und Benutzer, was auf eine starke Entwicklung von KI-Anwendungen in der Zukunft hinweist.