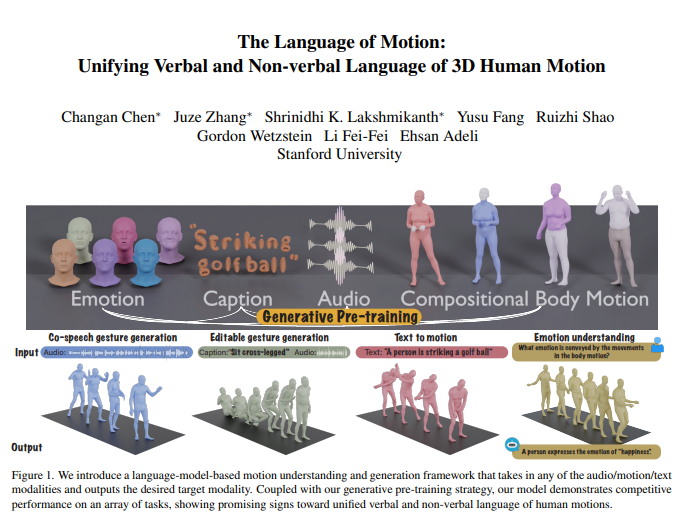

Das Team von Li Feifei hat kürzlich ein bahnbrechendes Forschungsergebnis veröffentlicht: ein neues multimodales Modell, das menschliche Handlungen verstehen und generieren kann und Sprachmodelle geschickt kombiniert, um eine einheitliche Verarbeitung verbaler und nonverbaler Sprache zu erreichen. Diese Innovation ermöglicht es Maschinen nicht nur, menschliche Anweisungen zu verstehen, sondern auch die Emotionen hinter Handlungen zu interpretieren und so eine natürlichere und reibungslosere Mensch-Computer-Interaktion zu erreichen. Der Kern des Modells liegt in seinem multimodalen Sprachmodell-Framework, das mehrere Eingaben wie Audio, Bewegung und Text integrieren und entsprechende modale Daten ausgeben kann. Es schneidet bei Aufgaben wie der kollaborativen Generierung von Sprachgesten gut ab, reduziert die für das Modelltraining erforderliche Datenmenge erheblich und erweitert neue Anwendungsszenarien wie die Generierung bearbeitbarer Gesten und die Vorhersage von Emotionen durch Aktionen.

Das Team von Li Feifei hat ein neues multimodales Modell auf den Markt gebracht, das menschliche Handlungen verstehen und generieren kann und durch die Kombination von Sprachmodellen eine einheitliche Verarbeitung verbaler und nonverbaler Sprache erreicht. Diese bahnbrechende Forschung ermöglicht es Maschinen, nicht nur menschliche Anweisungen zu verstehen, sondern auch die in Handlungen enthaltenen Emotionen zu lesen, was eine natürlichere Mensch-Computer-Interaktion ermöglicht.

Der Kern des Modells liegt in seinem multimodalen Sprachmodell-Framework, das mehrere Eingabeformen wie Audio, Bewegung und Text empfangen und die erforderlichen modalen Daten ausgeben kann. In Kombination mit einer generativen Pre-Training-Strategie zeigt das Modell eine hervorragende Leistung bei mehreren Aufgaben. Beispielsweise übertrifft das Modell bei der kollaborativen Sprachgestengenerierung nicht nur den Stand der Technik, sondern reduziert auch die für das Training erforderliche Datenmenge erheblich. Darüber hinaus erschließt das Modell auch neue Anwendungsszenarien, wie z. B. die Generierung bearbeitbarer Gesten und die Vorhersage von Emotionen durch Aktionen.

Die menschliche Kommunikation ist multimodaler Natur und umfasst verbale und nonverbale Hinweise wie Sprache, Mimik und Körperhaltung. Die Fähigkeit dieses Modells, diese multimodalen Verhaltensweisen zu verstehen, ist entscheidend für die Erstellung virtueller Charaktere, die in Anwendungen wie Spielen, Filmen und virtueller Realität auf natürliche Weise kommunizieren. Bestehende Aktionsgenerierungsmodelle sind jedoch häufig auf bestimmte Eingabemodalitäten (Sprache, Text oder Aktionsdaten) beschränkt und können die Vielfalt der verfügbaren Daten nicht vollständig nutzen.

Dieses Modell nutzt Sprachmodelle, um verbale und nonverbale Sprache aus drei Hauptgründen zu vereinheitlichen:

Sprachmodelle verbinden auf natürliche Weise verschiedene Modalitäten.

Sprache ist stark semantisch und Aufgaben wie das Modellieren von Reaktionen auf Witze erfordern ausgeprägte Fähigkeiten zum semantischen Denken.

Das Sprachmodell erwirbt durch umfangreiches Vortraining starke semantische Verständnisfähigkeiten.

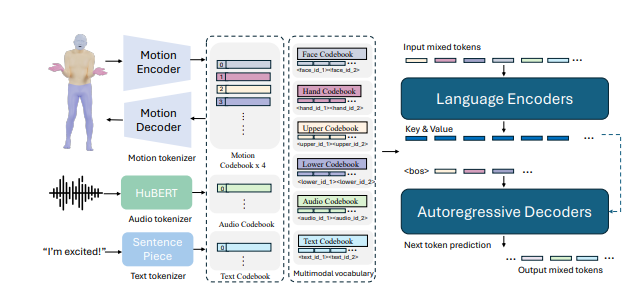

Um dies zu erreichen, teilte das Forschungsteam zunächst den Körper in verschiedene Teile (Gesicht, Hände, Oberkörper, Unterkörper) und beschriftete jeden Teil einzeln für seine Bewegung. Durch die Kombination von Text- und Sprach-Tokenisierern können Eingaben in jeder Modalität als eine Reihe von Token zur Verwendung durch Sprachmodelle dargestellt werden. Das Modell wendet einen zweistufigen Trainingsprozess an: erstes Vortraining, um die Ausrichtung verschiedener Modalitäten mit kombinierten Körperbewegungen zu erreichen, sowie die Ausrichtung von Audio und Text. Anschließend werden nachgelagerte Aufgaben in Anweisungen umgewandelt und das Modell anhand dieser Anweisungen trainiert, sodass es verschiedenen Aufgabenanweisungen folgen kann.

Das Modell schnitt beim BEATv2-Benchmark zur kollaborativen Sprachgestengenerierung gut ab und übertraf bestehende Modelle bei weitem. Die Wirkung der Pre-Training-Strategie wurde ebenfalls überprüft, insbesondere wenn die Daten knapp sind, und zeigt eine starke Generalisierungsfähigkeit. Durch Nachtraining zu Sprach-Aktions- und Text-Aktionsaufgaben kann das Modell nicht nur Audio- und Textaufforderungen folgen, sondern auch neue Funktionen wie die Vorhersage von Emotionen aus Aktionsdaten erreichen.

Im technischen Detail verwendet das Modell modalitätsspezifische Tokenizer, um verschiedene Eingabemodalitäten zu verarbeiten. Konkret trainiert das Modell eine kombinierte Körperbewegungs-VQ-VAE, die Gesichts-, Hand-, Oberkörper- und Unterkörperbewegungen in diskrete Marker umwandelt. Diese modalitätsspezifischen Vokabulare (Audio und Text) werden zu einem einheitlichen multimodalen Vokabular kombiniert. Während des Trainings werden gemischte Token unterschiedlicher Modalitäten als Eingabe verwendet und die Ausgabe wird durch ein Encoder-Decoder-Sprachmodell generiert.

Das Modell nutzt außerdem ein multimodales Vokabular, um verschiedene modale Daten zur Verarbeitung in ein einheitliches Format umzuwandeln. In der Vortrainingsphase lernt das Modell die Korrespondenz zwischen verschiedenen Modalitäten, indem es Konvertierungsaufgaben zwischen Modalitäten durchführt. Beispielsweise kann ein Modell lernen, Bewegungen des Oberkörpers in Bewegungen des Unterkörpers zu übersetzen oder Audio in Text umzuwandeln. Darüber hinaus lernt das Modell die zeitliche Entwicklung von Aktionen, indem es bestimmte Aktionsrahmen zufällig maskiert.

In der Post-Training-Phase wird das Modell mithilfe gepaarter Daten verfeinert, um nachgelagerte Aufgaben wie die kollaborative Sprachgestengenerierung oder die Text-zu-Aktion-Generierung auszuführen. Damit das Modell natürlichen menschlichen Anweisungen folgen kann, erstellten die Forscher eine Multitasking-Anweisungsfolgevorlage, die Aufgaben wie Audio-in-Action, Text-in-Action und Emotion-in-Action in Anweisungen umwandelt. Das Modell verfügt außerdem über die Möglichkeit, Gesten zu bearbeiten, um basierend auf Text- und Audiohinweisen koordinierte Ganzkörperbewegungen zu generieren.

Schließlich eröffnet das Modell auch neue Möglichkeiten zur Vorhersage von Emotionen aus Handlungen. Dies hat wichtige Auswirkungen auf Bereiche wie die psychische Gesundheit oder die Psychiatrie. Dieses Modell ist in der Lage, die in Handlungen ausgedrückten Emotionen genauer vorherzusagen als andere Modelle und zeigt ein starkes Verständnis der Körpersprache.

Die Forschung zeigt, dass die Vereinheitlichung der verbalen und nonverbalen Sprache menschlicher Handlungen für praktische Anwendungen von entscheidender Bedeutung ist und Sprachmodelle hierfür einen leistungsstarken Rahmen bieten.

Papieradresse: https://arxiv.org/pdf/2412.10523v1

Alles in allem hat diese Forschung erhebliche Fortschritte auf dem Gebiet der multimodalen künstlichen Intelligenz gebracht. Ihr Anwendungspotenzial in der Mensch-Computer-Interaktion, der Erstellung virtueller Charaktere und der Emotionserkennung ist enorm und verdient weitere Aufmerksamkeit und Forschung. Es wird erwartet, dass dieses Modell in Zukunft in weiteren Bereichen eine Rolle spielen und die Entwicklung der Technologie der künstlichen Intelligenz vorantreiben wird.