Zhipu AI hat sein CogAgent-9B-Modell als Open Source bereitgestellt, das auf dem GLM-4V-9B-Training basiert. Hierbei handelt es sich um ein Agentenaufgabenmodell, das Benutzeranweisungen anhand von Screenshots verstehen und den nächsten GUI-Vorgang vorhersagen kann. Dieses Modell weist eine starke Universalität auf und eignet sich für verschiedene GUI-Interaktionsszenarien wie PCs, Mobiltelefone und Autos. Im Vergleich zur Vorgängerversion wurde CogAgent-9B-20241220 in vielen Aspekten deutlich verbessert, unterstützt zweisprachiges Chinesisch und Englisch und kann detaillierte Denkprozesse, Handlungsbeschreibungen und Sensibilitätsbeurteilungen ausgeben. Es hat bei mehreren Datensätzen führende Ergebnisse erzielt und seine Vorteile bei der GUI-Positionierung sowie bei einstufigen und mehrstufigen Vorgängen unter Beweis gestellt. Der Open-Source-CogAgent-9B fördert nicht nur die Entwicklung der Großmodelltechnik, sondern bietet auch neue Möglichkeiten für Sehbehinderte.

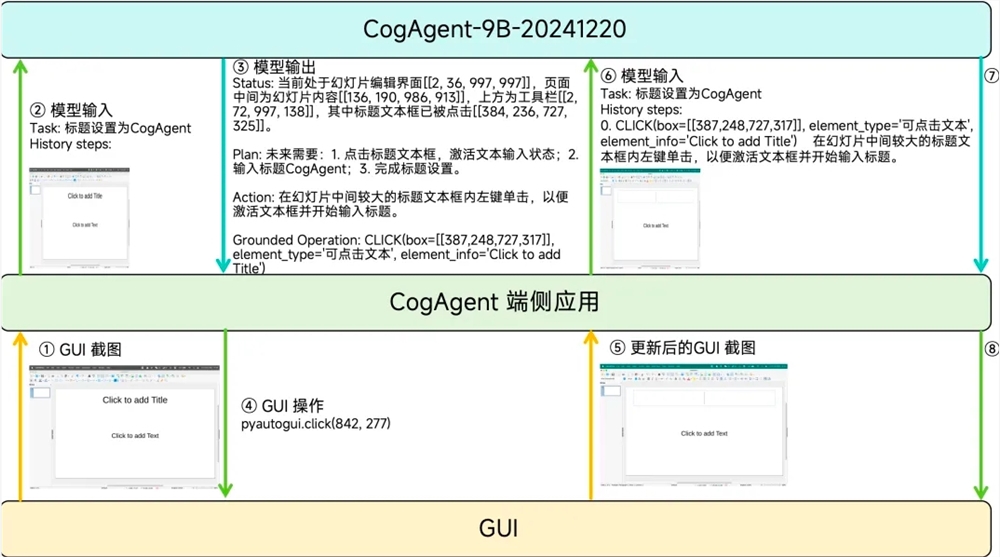

Im Vergleich zur ersten Version des CogAgent-Modells, die im Dezember 2023 als Open Source veröffentlicht wurde, hat sich CogAgent-9B-20241220 hinsichtlich der GUI-Wahrnehmung, der Genauigkeit der Inferenzvorhersage, der Vollständigkeit des Aktionsraums, der Aufgabenuniversalität und der Generalisierung erheblich verbessert und unterstützt zweisprachige Screenshots und Sprache Interaktion auf Chinesisch und Englisch. Die Eingabe von CogAgent umfasst nur die Anweisungen des Benutzers in natürlicher Sprache, ausgeführte historische Aktionsaufzeichnungen und GUI-Screenshots, ohne jegliche Textdarstellung von Layoutinformationen oder zusätzlichen Informationen zur Elementbeschriftung. Die Ausgabe umfasst den Denkprozess, die Beschreibung der nächsten Aktion in natürlicher Sprache, die strukturierte Beschreibung der nächsten Aktion und die Sensibilitätsbeurteilung der nächsten Aktion.

Im Leistungstest erzielte CogAgent-9B-20241220 führende Ergebnisse bei mehreren Datensätzen und demonstrierte seine Vorteile bei der GUI-Positionierung, Einzelschrittoperationen, chinesischen Schrittlisten und Mehrschrittoperationen. Dieser Schritt von Smart Spectrum Technology fördert nicht nur die Entwicklung der Großmodelltechnologie, sondern bietet auch neue Tools und Möglichkeiten für sehbehinderte IT-Anwender.

Code:

https://github.com/THUDM/CogAgent

Modell:

Huggingface: https://huggingface.co/THUDM/cogagent-9b-20241220

Cogagent-Community: https://modelscope.cn/models/ZhipuAI/cogagent-9b-20241220

Die Open Source von CogAgent-9B markiert einen wichtigen Schritt im Agenten-Ökosystem großer Modelle. Seine effizienten GUI-Interaktionsfähigkeiten und seine breite Anwendbarkeit geben eine neue Richtung für die zukünftige Entwicklung intelligenter Interaktionstechnologie vor und kündigen auch das Kommen bequemerer und intelligenterer zukünftiger Anwendungsszenarien an. Wir freuen uns auf weitere innovative Anwendungen auf Basis von CogAgent-9B.