Das Training großer KI-Modelle ist kostspielig und der enorme Ressourcenbedarf schränkt ihre breite Anwendung ein und wirft Bedenken hinsichtlich der Energieeffizienz und der Umweltauswirkungen auf. Herkömmliche Trainingsmethoden sind ineffizient, basieren auf dichten Matrizen und erfordern viel Speicher und Rechenleistung. Obwohl einige bestehende Methoden versuchen, diese Probleme zu lindern, weisen sie in der praktischen Anwendung immer noch Einschränkungen auf. Daher ist es von entscheidender Bedeutung, einen Ansatz zu entwickeln, der gleichzeitig die Speichernutzung, die Rechenkosten und die Trainingszeit reduzieren kann, ohne die Leistung zu beeinträchtigen.

Das Training groß angelegter KI-Modelle (wie Transformers und Sprachmodelle) ist zu einem unverzichtbaren Schlüsselelement im KI-Bereich geworden, ist jedoch auch mit hohen Rechenkosten, Speicherverbrauch und Energiebedarf konfrontiert. Beispielsweise verfügt GPT-3 von OpenAI über 175 Milliarden Parameter und erfordert wochenlanges GPU-Training. Dieser enorme Ressourcenbedarf schränkt die Anwendung dieser Technologie auf große, rechenressourcenreiche Unternehmen ein und verschärft gleichzeitig die Bedenken hinsichtlich der Energieeffizienz und der Umweltauswirkungen. Die Bewältigung dieser Herausforderungen ist von entscheidender Bedeutung, um eine breitere Zugänglichkeit und Nachhaltigkeit der KI-Entwicklung zu gewährleisten.

Traditionelle Trainingsmethoden sind ineffizient und innovative Lösungen sind dringend erforderlich

CoMERA-Framework: Effizientes Training durch adaptive Tensoroptimierung

Die Grundlage von CoMERA ist eine adaptive Tensordarstellung, die es Modellebenen ermöglicht, ihre Ränge basierend auf Ressourcenbeschränkungen dynamisch anzupassen. Durch die Änderung des Tensorrangs ermöglicht das Framework eine Komprimierung, ohne die Betriebsintegrität des neuronalen Netzwerks zu beeinträchtigen. Diese dynamische Optimierung wird durch einen zweistufigen Trainingsprozess erreicht:

Frühe Phasen: Fokus auf stabile Konvergenz.

Spätere Phasen: Feinabstimmung des Rangs, um bestimmte Komprimierungsziele zu erreichen.

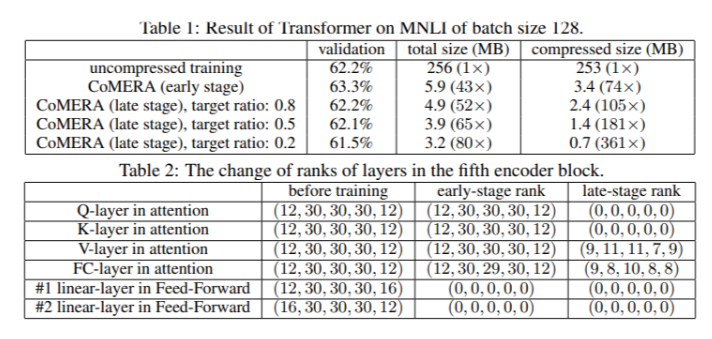

In einem Transformer-Modell mit sechs Encodern erreichte CoMERA in seinen frühen Phasen ein Kompressionsverhältnis von bis zu 43x und in seinen späteren Optimierungsphasen ein noch höheres Kompressionsverhältnis von 361x. Darüber hinaus reduziert es den Speicherverbrauch um das Neunfache und erhöht die Trainingsgeschwindigkeit pro Runde um das Zwei- bis Dreifache im Vergleich zu GaLore.

Mehrere Testergebnisse zeigen, dass CoMERA eine hervorragende Leistung aufweist

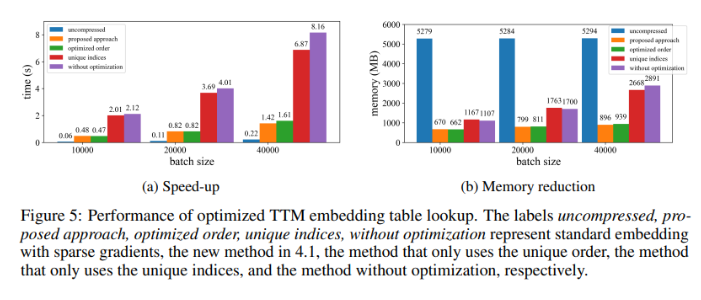

Bei Anwendung auf ein Transformer-Modell, das auf dem MNLI-Datensatz trainiert wurde, reduziert CoMERA die Modellgröße von 256 MB auf nur 3,2 MB und behält dabei die Genauigkeit bei. In großen Empfehlungssystemen wie DLRM komprimiert CoMERA Modelle um das 99-fache und reduziert die Spitzenspeichernutzung um das 7-fache. Das Framework schnitt auch beim Vortraining von CodeBERT, einem domänenspezifischen großen Sprachmodell, gut ab und erreichte ein Gesamtkomprimierungsverhältnis von 4,23x und eine 2-fache Beschleunigung in einigen Trainingsphasen. Diese Ergebnisse unterstreichen seine Fähigkeit, eine Vielzahl von Aufgaben und Architekturen zu bewältigen und erweitern seine Anwendbarkeit in verschiedenen Bereichen.

Zusammenfassung der wichtigsten Vorteile des CoMERA-Frameworks

Die wichtigsten Schlussfolgerungen dieser Studie lauten wie folgt:

CoMERA erreicht Komprimierungsraten von bis zu 361x für bestimmte Schichten und 99x für das gesamte Modell, wodurch der Speicher- und Arbeitsspeicherbedarf erheblich reduziert wird.

Dieses Framework verkürzt die Trainingszeit jeder Runde von Transformer- und Empfehlungssystemen um das Zwei- bis Dreifache und spart so Rechenressourcen und Zeit.

Durch die Verwendung tensorisierter Darstellungen und CUDA-Diagramme reduziert CoMERA den Spitzenspeicherverbrauch um das Siebenfache und ermöglicht so das Training auf kleineren GPUs.

Der Ansatz von CoMERA unterstützt mehrere Architekturen, einschließlich Transformer und große Sprachmodelle, und behält dabei die Genauigkeit bei oder verbessert sie.

Durch die Reduzierung des Energie- und Ressourcenaufwands für die Schulung trägt CoMERA dazu bei, nachhaltigere KI-Praktiken zu ermöglichen und modernste Modelle einem breiteren Publikum zugänglich zu machen.

Alles in allem bietet das CoMERA-Framework eine bahnbrechende Lösung für das effiziente Training großer KI-Modelle, die durch adaptive Tensoroptimierung die Rechenkosten und den Speicherbedarf erheblich reduziert und gleichzeitig die Modellgenauigkeit beibehält. Diese Forschung leistet einen wichtigen Beitrag zur Weiterentwicklung und breiteren Zugänglichkeit des Bereichs KI.