Kürzlich haben das Deep-Learning-Team von Google und Forscher mehrerer Universitäten ein neues System namens „MegaSaM“ veröffentlicht, das Kameraparameter und Tiefenkarten aus dynamischen Videos effizient schätzen kann. Dies stellt einen großen Durchbruch im Bereich Computer Vision dar und dürfte die Videoverarbeitungstechnologie revolutionieren und weitreichende Anwendungen in vielen Bereichen ermöglichen. Herkömmliche Methoden weisen beim Umgang mit dynamischen Szenen viele Einschränkungen auf. Das Aufkommen von MegaSaM löst diese Probleme effektiv und bietet eine neue Lösung für die dynamische Videoanalyse.

Kürzlich haben das Deep-Learning-Team von Google und Forscher mehrerer Universitäten gemeinsam ein neues System namens „MegaSaM“ veröffentlicht, mit dem Kameraparameter und Tiefenkarten aus gewöhnlichen dynamischen Videos schnell und genau geschätzt werden können. Das Aufkommen dieser Technologie wird den Videos, die wir in unserem täglichen Leben aufnehmen, mehr Möglichkeiten eröffnen, insbesondere im Hinblick auf die Erfassung und Analyse dynamischer Szenen.

Herkömmliche Technologien wie Structure from Motion (SfM) und Monocular Simultaneous Localization and Mapping (SLAM) erfordern in der Regel die Eingabe von Videos statischer Szenen und haben hohe Parallaxenanforderungen. Angesichts dynamischer Szenen ist die Leistung dieser Methoden oft unbefriedigend, da der Algorithmus ohne statischen Hintergrund fehleranfällig ist. Obwohl in den letzten Jahren einige auf neuronalen Netzwerken basierende Methoden versucht haben, dieses Problem zu lösen, weisen diese Methoden häufig einen enormen Rechenaufwand und mangelnde Stabilität bei dynamischen Videos auf, insbesondere wenn die Kamerabewegung unkontrolliert ist oder das Sichtfeld unbekannt ist.

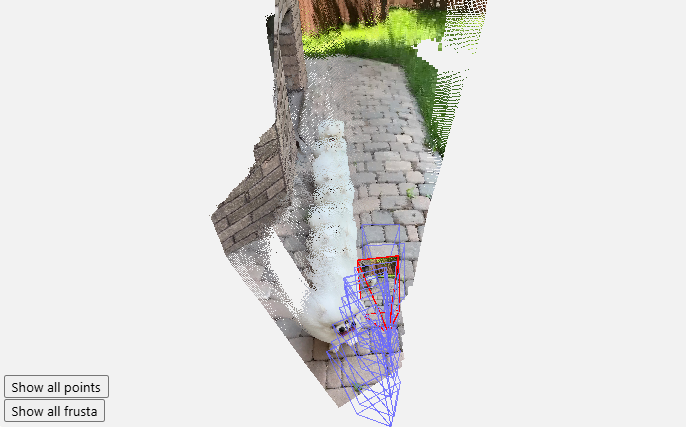

Das Aufkommen von MegaSaM hat diese Situation verändert. Das Forschungsteam hat das Deep-Vision-SLAM-Framework sorgfältig modifiziert, um eine Anpassung an komplexe dynamische Szenen zu ermöglichen, insbesondere wenn der Kamerapfad nicht eingeschränkt ist. Nach einer Reihe von Experimenten stellten die Forscher fest, dass MegaSaM frühere verwandte Technologien in Bezug auf Kameraposition und Tiefenschätzung deutlich übertraf und auch in Bezug auf die Laufzeit eine gute Leistung erbrachte, die sogar mit einigen Methoden vergleichbar war.

Dank der Leistungsfähigkeit des Systems kann es praktisch jedes Video verarbeiten, einschließlich gelegentlicher Aufnahmen, bei denen es während des Filmens zu intensiven Bewegungen oder Szenendynamiken kommen kann. MegaSaM verarbeitet das Quellvideo mit etwa 0,7 Bildern pro Sekunde und demonstriert damit seine hervorragende Leistung. Das Forschungsteam zeigt in seiner Galerie auch weitere Verarbeitungsergebnisse, um die Wirksamkeit in realen Anwendungen zu demonstrieren.

Dieses Forschungsergebnis bringt nicht nur frischen Wind in den Bereich Computer Vision, sondern bietet den Benutzern auch neue Möglichkeiten für die Videoverarbeitung im täglichen Leben. Wir freuen uns darauf, MegaSaM in Zukunft in weiteren Szenen zu sehen.

Projekteingang: https://mega-sam.github.io/#demo

Highlight:

Das MegaSaM-System ist in der Lage, Kameraparameter und Tiefenkarten aus gewöhnlichen dynamischen Videos schnell und genau abzuschätzen.

Diese Technologie überwindet die Mängel traditioneller Methoden in dynamischen Szenen und passt sich an die Echtzeitverarbeitung komplexer Umgebungen an.

Experimentelle Ergebnisse zeigen, dass MegaSaM frühere Technologien sowohl hinsichtlich der Genauigkeit als auch der betrieblichen Effizienz übertrifft.

Das Aufkommen des MegaSaM-Systems hat revolutionäre Veränderungen in der dynamischen Videoverarbeitung mit sich gebracht, und seine effiziente und genaue Leistung bietet die Möglichkeit für weitere Anwendungsszenarien in der Zukunft. Man geht davon aus, dass MegaSaM mit der kontinuierlichen Weiterentwicklung und Verbesserung der Technologie in immer mehr Bereichen eine wichtige Rolle spielen und den Menschen mehr Komfort bieten wird.