Das Qwen-Team hat sein neuestes multimodales Argumentationsmodell QVQ als Open Source bereitgestellt, das auf Qwen2-VL-72B aufbaut und das visuelle Verständnis und die Argumentationsfähigkeiten der KI deutlich verbessert. QVQ erreichte beim MMMU-Test eine hohe Punktzahl von 70,3 und übertraf sein Vorgängermodell in mehreren mathematischen Benchmarks. In diesem Artikel werden die Merkmale, Vorteile, Einschränkungen und die Verwendung des QVQ-Modells ausführlich vorgestellt und relevante Links bereitgestellt, um den Lesern das bessere Verständnis und die Verwendung des Modells zu erleichtern.

Das Qwen-Team kündigte kürzlich die Veröffentlichung seines neuesten multimodalen Argumentationsmodells QVQ als Open Source an und markiert damit einen wichtigen Schritt für das visuelle Verständnis und die komplexen Problemlösungsfähigkeiten der künstlichen Intelligenz. Dieses Modell basiert auf Qwen2-VL-72B und zielt darauf ab, die Denkfähigkeiten der KI durch die Kombination von Sprache und visuellen Informationen zu verbessern. In der MMMU-Bewertung erreichte QVQ eine hohe Punktzahl von 70,3 und zeigte in mehreren mathematikbezogenen Benchmark-Tests deutliche Leistungsverbesserungen im Vergleich zu Qwen2-VL-72B-Instruct.

Das QVQ-Modell hat besondere Vorteile bei visuellen Denkaufgaben gezeigt, insbesondere in Bereichen, die komplexes analytisches Denken erfordern. Trotz der hervorragenden Leistung von QVQ-72B-Preview wies das Team auch auf einige Einschränkungen des Modells hin, darunter Sprachmischungs- und Codewechselprobleme, die Möglichkeit, in zirkuläre Logikmuster zu verfallen, Sicherheits- und ethische Überlegungen sowie Leistungs- und Benchmark-Einschränkungen. Das Team betonte, dass das Modell zwar das visuelle Denken verbessert habe, die Fähigkeit von Qwen2-VL-72B jedoch nicht vollständig ersetzen könne. Während des mehrstufigen visuellen Denkprozesses könne das Modell allmählich den Fokus auf den Bildinhalt verlieren, was zu Halluzinationen führen könne.

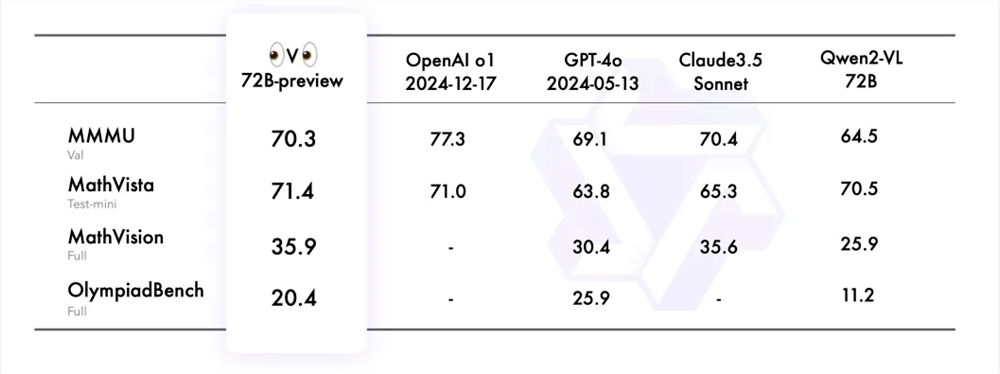

Das Qwen-Team evaluierte QVQ-72B-Preview anhand von vier Datensätzen, darunter MMMU, MathVista, MathVision und OlympiadBench. Diese Datensätze sollen das umfassende Verständnis und die Argumentationsfähigkeiten des Modells in Bezug auf das Sehvermögen untersuchen. Der QVQ-72B-Preview schnitt in diesen Benchmarks gut ab und konnte die Lücke zum Spitzenmodell effektiv schließen.

Um die Anwendung des QVQ-Modells bei visuellen Denkaufgaben weiter zu demonstrieren, stellte das Qwen-Team mehrere Beispiele zur Verfügung und teilte einen Link zum technischen Blog. Darüber hinaus stellte das Team auch Codebeispiele für die Modellinferenz und die Verwendung der Magic API-Inferenz zum direkten Aufruf des QVQ-72B-Preview-Modells bereit. Die API-Inferenz der Magic Platform bietet Unterstützung für das QVQ-72B-Preview-Modell, und Benutzer können das Modell direkt über API-Aufrufe verwenden.

Modelllink:

https://modelscope.cn/models/Qwen/QVQ-72B-Preview

Erlebnislink:

https://modelscope.cn/studios/Qwen/QVQ-72B-preview

Chinesischer Blog:

https://qwenlm.github.io/zh/blog/qvq-72b-preview

Die offene Quelle des QVQ-Modells stellt wertvolle Ressourcen für die multimodale Forschung im Bereich der künstlichen Intelligenz bereit und kündigt auch die Weiterentwicklung der KI im Bereich des visuellen Denkens in der Zukunft an. Obwohl es einige Einschränkungen gibt, kann die hervorragende Leistung in vielen Benchmark-Tests dennoch überzeugen. Wir freuen uns auf die weitere Optimierung und Verbesserung des QVQ-Modells in der Zukunft.