Gemeinsame Untersuchungen von Top-Institutionen wie der Harvard University und der Stanford University zeigen, dass das o1-Preview-Modell von OpenAI erstaunliche Fähigkeiten bei medizinischen Argumentationsaufgaben gezeigt hat und sogar menschliche Ärzte übertrifft. In dieser Studie wurde eine umfassende Bewertung des o1-Vorschaumodells durchgeführt, die mehrere Aspekte wie die Generierung von Differenzialdiagnosen, die Darstellung des Prozesses des diagnostischen Denkens, die Triage-Differentialdiagnose, das probabilistische Denken und das Denken des Managements abdeckte, und es mit menschlichen Ärzten und der frühen groß angelegten Sprache verglichen Modelle. Die Forschungsergebnisse sind aufsehenerregend, bringen neue Durchbrüche bei der Anwendung künstlicher Intelligenz im medizinischen Bereich und weisen auch den Weg für die zukünftige Entwicklungsrichtung medizinischer künstlicher Intelligenz.

Die Anwendung künstlicher Intelligenz im medizinischen Bereich hat erneut einen großen Durchbruch gebracht! Eine gemeinsam von der Harvard University, der Stanford University und anderen Spitzeninstitutionen durchgeführte Studie zeigte, dass das o1-Preview-Modell von OpenAI bei mehreren medizinischen Argumentationsaufgaben erstaunliche Fähigkeiten zeigte und diese sogar übertraf menschliche Ärzte. Diese Studie bewertete nicht nur die Leistung des Modells bei medizinischen Multiple-Choice-Benchmark-Tests, sondern konzentrierte sich auch auf seine Diagnose- und Managementfähigkeiten in simulierten realen klinischen Szenarien. Die Ergebnisse sind beeindruckend.

Die Forscher führten eine umfassende Bewertung des o1-Preview-Modells anhand von fünf Experimenten durch, darunter die Generierung von Differenzialdiagnosen, die Darstellung des diagnostischen Argumentationsprozesses, die Triage-Differentialdiagnose, das probabilistische Denken und das Managementdenken. Die Experimente wurden von medizinischen Experten unter Verwendung validierter psychometrischer Methoden ausgewertet und waren darauf ausgelegt, die Leistung von o1-preview mit früheren menschlichen Kontrollen und früheren Benchmarks für große Sprachmodelle zu vergleichen. Die Ergebnisse zeigen, dass o1-preview erhebliche Verbesserungen bei der Differenzialdiagnosegenerierung und der Qualität der Diagnose- und Managementbegründung erzielt.

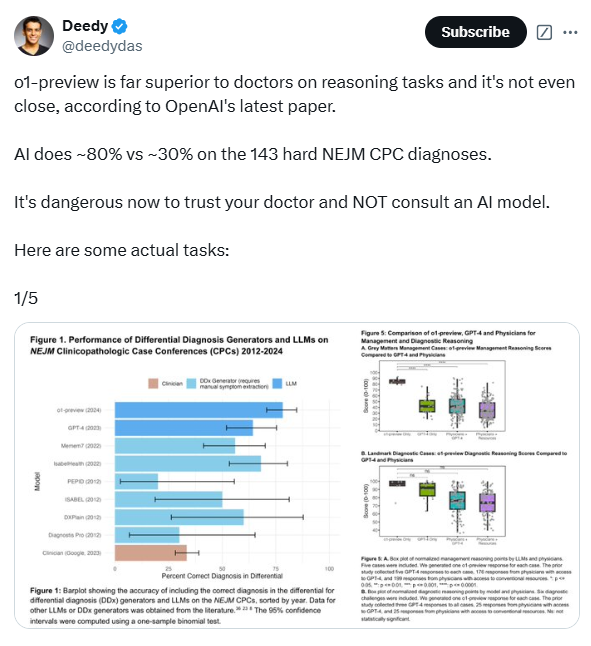

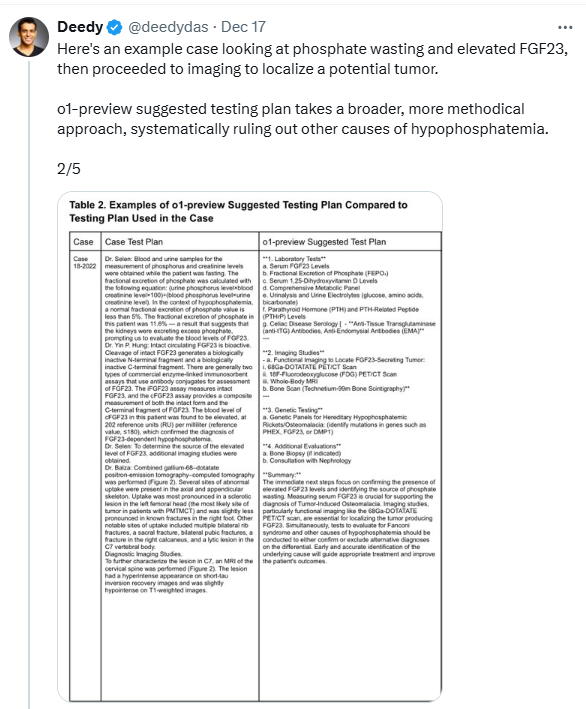

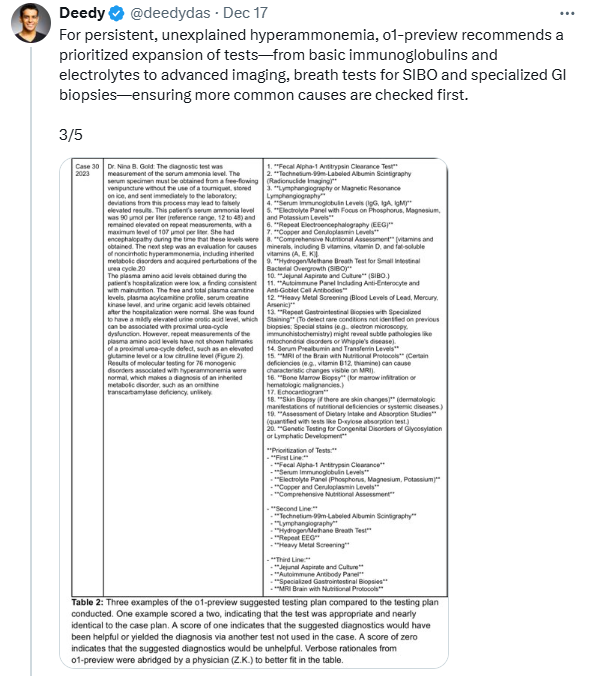

Bei der Beurteilung der Fähigkeit von o1-preview, Differenzialdiagnosen zu erstellen, verwendeten die Forscher Fälle des Clinical Pathology Colloquium (CPC), die im New England Journal of Medicine (NEJM) veröffentlicht wurden. Die Ergebnisse zeigten, dass die vom Modell gegebene Differenzialdiagnose in 78,3 % der Fälle die richtige Diagnose enthielt und in 52 % der Fälle die erste Diagnose die richtige Diagnose war. Noch bemerkenswerter ist, dass o1-preview in 88,6 % der Fälle genaue oder sehr genaue Diagnosen lieferte, verglichen mit 72,9 % der gleichen Fälle beim vorherigen GPT-4-Modell. Darüber hinaus schnitt o1-preview auch bei der Auswahl des nächsten Diagnosetests gut ab, indem es in 87,5 % der Fälle den richtigen Test auswählte und in 11 % der Fälle ein Testschema auswählte, das als hilfreich erachtet wurde.

Um die Fähigkeiten zum klinischen Denken von o1-preview weiter zu bewerten, verwendeten die Forscher 20 klinische Fälle aus dem NEJM-Heiler-Kurs. Die Ergebnisse zeigten, dass o1-Preview in diesen Fällen bei behandelnden Ärzten und Assistenzärzten deutlich besser abschnitt als GPT-4 und in 78/80 Fällen perfekte R-IDEA-Werte erzielte. Der R-IDEA-Score ist eine 10-Punkte-Skala zur Beurteilung der Qualität der Dokumentation des Clinical Reasoning. Darüber hinaus bewerteten die Forscher die Management- und Diagnosefähigkeiten von o1-preview anhand des Managementfalls „Grey Matters“ und des Diagnosefalls „Landmark“. Im Fall „Grey Matters“ schnitt o1-preview deutlich besser ab als GPT-4, Ärzte, die GPT-4 nutzen, und Ärzte, die herkömmliche Ressourcen nutzen. Im „Landmark“-Fall schneidet o1-preview auf Augenhöhe mit GPT-4 ab, ist aber besser als Ärzte, die GPT-4 oder herkömmliche Ressourcen verwenden.

Die Studie ergab jedoch auch, dass die Leistung von o1-preview beim probabilistischen Denken mit der des Vorgängermodells vergleichbar war, ohne nennenswerte Verbesserung. In einigen Fällen war das Modell dem Menschen bei der Vorhersage von Krankheitswahrscheinlichkeiten unterlegen. Die Forscher stellten außerdem fest, dass eine Einschränkung von o1-preview in seiner Tendenz zur Ausführlichkeit liegt, was in einigen Experimenten möglicherweise zu seiner Punktzahl beigetragen hat. Darüber hinaus konzentrierte sich diese Studie hauptsächlich auf die Modellleistung und beinhaltete keine Mensch-Computer-Interaktion. Daher sind in Zukunft weitere Untersuchungen darüber erforderlich, wie o1-preview die Mensch-Computer-Interaktion verbessert, um effektivere Tools zur klinischen Entscheidungsunterstützung zu entwickeln.

Dennoch zeigt diese Studie, dass o1-preview bei Aufgaben, die komplexes kritisches Denken erfordern, wie Diagnose und Management, eine gute Leistung erbringt. Die Forscher betonen, dass die Benchmarks für diagnostisches Denken im medizinischen Bereich schnell gesättigt werden, was die Entwicklung anspruchsvollerer und realistischerer Bewertungsmethoden erfordert. Sie fordern Tests dieser Technologien in realen klinischen Umgebungen und die Vorbereitung auf kollaborative Innovationen zwischen Klinikern und künstlicher Intelligenz. Darüber hinaus muss ein robuster Aufsichtsrahmen eingerichtet werden, um die weit verbreitete Implementierung von KI-Systemen zur klinischen Entscheidungsunterstützung zu überwachen.

Papieradresse: https://www.arxiv.org/pdf/2412.10849

Insgesamt liefert diese Studie starke Belege für den Einsatz künstlicher Intelligenz im medizinischen Bereich und weist zugleich auf die Richtung zukünftiger Forschung hin. Die hervorragende Leistung des o1-preview-Modells ist aufregend, aber seine Einschränkungen erfordern auch eine sorgfältige Abwägung und die Gewährleistung seiner Sicherheit und Zuverlässigkeit in klinischen Anwendungen. Zukünftig wird die Mensch-Maschine-Kollaboration ein wichtiger Trend im medizinischen Bereich werden.