Magic Square Quantitative hat kürzlich eine neue Generation des großen Modells DeepSeek-V3 veröffentlicht. Seine 671-Milliarden-Parameter-Skala und die MoE-Architektur machen seine Leistung mit den Top-Closed-Source-Modellen vergleichbar Aufmerksamkeit in der Branche. DeepSeek-V3 hat in vielen Tests gut abgeschnitten, insbesondere alle vorhandenen Modelle im mathematischen Fähigkeitstest übertroffen, und bietet API-Dienste zu einem deutlich niedrigeren Preis als Modelle wie GPT-4, wodurch Entwickler und Unternehmen kostengünstige KI-Lösungen erhalten. In diesem Artikel werden die Leistungs-, Kosten- und Kommerzialisierungsstrategie von DeepSeek-V3 im Detail analysiert und seine Auswirkungen auf die KI-Branche erörtert.

Magic Square Quantitative veröffentlichte am Abend des 26. Dezember eine neue Generation des Großmodells DeepSeek-V3 und stellte damit einen erstaunlichen technologischen Durchbruch dar. Dieses Modell, das die MoE-Architektur (Mixed Experts) verwendet, ist nicht nur hinsichtlich der Leistung mit Top-Closed-Source-Modellen vergleichbar, sondern seine kostengünstigen und hocheffizienten Funktionen haben auch die Aufmerksamkeit der Branche auf sich gezogen.

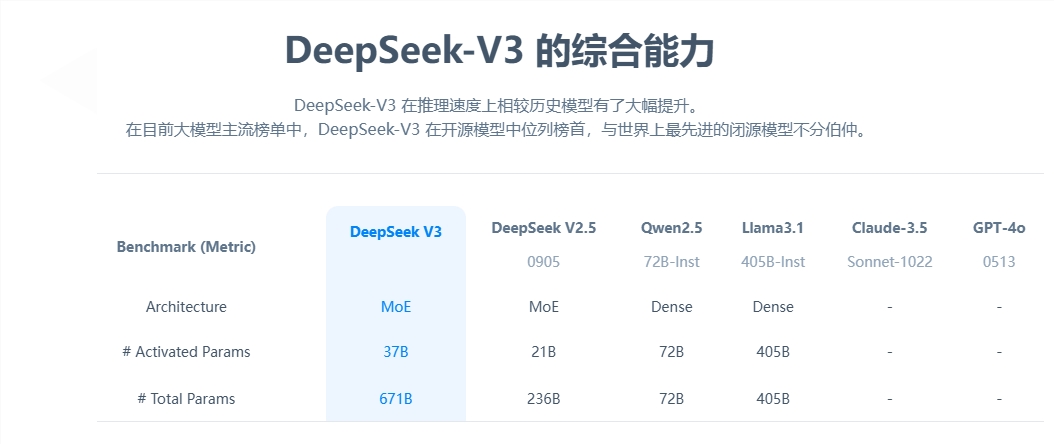

Aus Sicht der Kernparameter verfügt DeepSeek-V3 über 671 Milliarden Parameter, davon 37 Milliarden Aktivierungsparameter, und hat das Vortraining auf einer Datenskala von 14,8 Billionen Token abgeschlossen. Im Vergleich zum Produkt der vorherigen Generation wurde die Generierungsgeschwindigkeit des neuen Modells um das Dreifache erhöht und kann 60 Token pro Sekunde verarbeiten, was die Effizienz praktischer Anwendungen erheblich verbessert.

In Bezug auf die Leistungsbewertung zeigt DeepSeek-V3 eine hervorragende Stärke. Es übertrifft nicht nur bekannte Open-Source-Modelle wie Qwen2.5-72B und Llama-3.1-405B, sondern liegt in mehreren Tests auch mit GPT-4 und Claude-3.5-Sonnet gleichauf. Insbesondere im mathematischen Leistungstest übertraf das Modell alle bestehenden Open-Source- und Closed-Source-Modelle mit hervorragenden Ergebnissen.

Am auffälligsten ist der kostengünstige Vorteil von DeepSeek-V3. Laut Open-Source-Dokumenten belaufen sich die Gesamttrainingskosten des Modells, die mit 2 US-Dollar pro GPU-Stunde berechnet werden, auf nur 5,576 Millionen US-Dollar. Dieses bahnbrechende Ergebnis ist auf die gemeinsame Optimierung von Algorithmen, Frameworks und Hardware zurückzuführen. OpenAI-Mitbegründer Karpathy lobte dies und wies darauf hin, dass DeepSeek-V3 in nur 2,8 Millionen GPU-Stunden eine Leistung erreichte, die Llama3 übertraf, und die Recheneffizienz um etwa das Elffache stieg.

Im Hinblick auf die Kommerzialisierung wurden die API-Servicepreise von DeepSeek-V3 im Vergleich zur vorherigen Generation zwar erhöht, die Kostenleistung bleibt jedoch hoch. Die neue Version kostet 0,5 bis 2 Yuan pro Million Input-Tokens und 8 Yuan pro Million Output-Tokens, wobei die Gesamtkosten etwa 10 Yuan betragen. Im Vergleich dazu beträgt der entsprechende Servicepreis von GPT-4 etwa 140 Yuan, und der Preisunterschied ist erheblich.

Als umfassendes Open-Source-Großmodell demonstriert die Veröffentlichung von DeepSeek-V3 nicht nur den Fortschritt der chinesischen KI-Technologie, sondern bietet Entwicklern und Unternehmen auch eine leistungsstarke, kostengünstige KI-Lösung.

Das Erscheinen von DeepSeek-V3 stellt einen großen Durchbruch in der chinesischen KI-Technologie im Bereich groß angelegter Sprachmodelle dar. Aufgrund seiner geringen Kosten und seiner hohen Leistung ist es bei kommerziellen Anwendungen äußerst wettbewerbsfähig, und es lohnt sich, auf seine zukünftige Entwicklung zu blicken . Die Open Source dieses Modells stellt außerdem wertvolle Ressourcen für die globale KI-Community bereit und fördert den Austausch und die Entwicklung von KI-Technologie.