ByteDance hat kürzlich mit Depth Anything V2 eine neue Generation von Tiefenmodellen veröffentlicht, die einen bedeutenden Durchbruch auf dem Gebiet der monokularen Tiefenschätzung erzielt haben. Im Vergleich zur Vorgängergeneration wurde die V2-Version hinsichtlich Detailgenauigkeit, Robustheit und Effizienz erheblich verbessert und ist mehr als zehnmal schneller als das auf Stable Diffusion basierende Modell. Der Fortschritt dieser Technologie spiegelt sich nicht nur in der Optimierung des Modells selbst wider, sondern auch in seinen innovativen Trainingsmethoden, die neue Möglichkeiten in den Bereich Computer Vision bringen. Der Artikel beschreibt die wichtigsten Funktionen, Trainingsmethoden und vielfältigen Anwendungsszenarien von Depth Anything V2 und ermöglicht uns so ein tiefgreifendes Verständnis der Weiterentwicklung dieser Technologie.

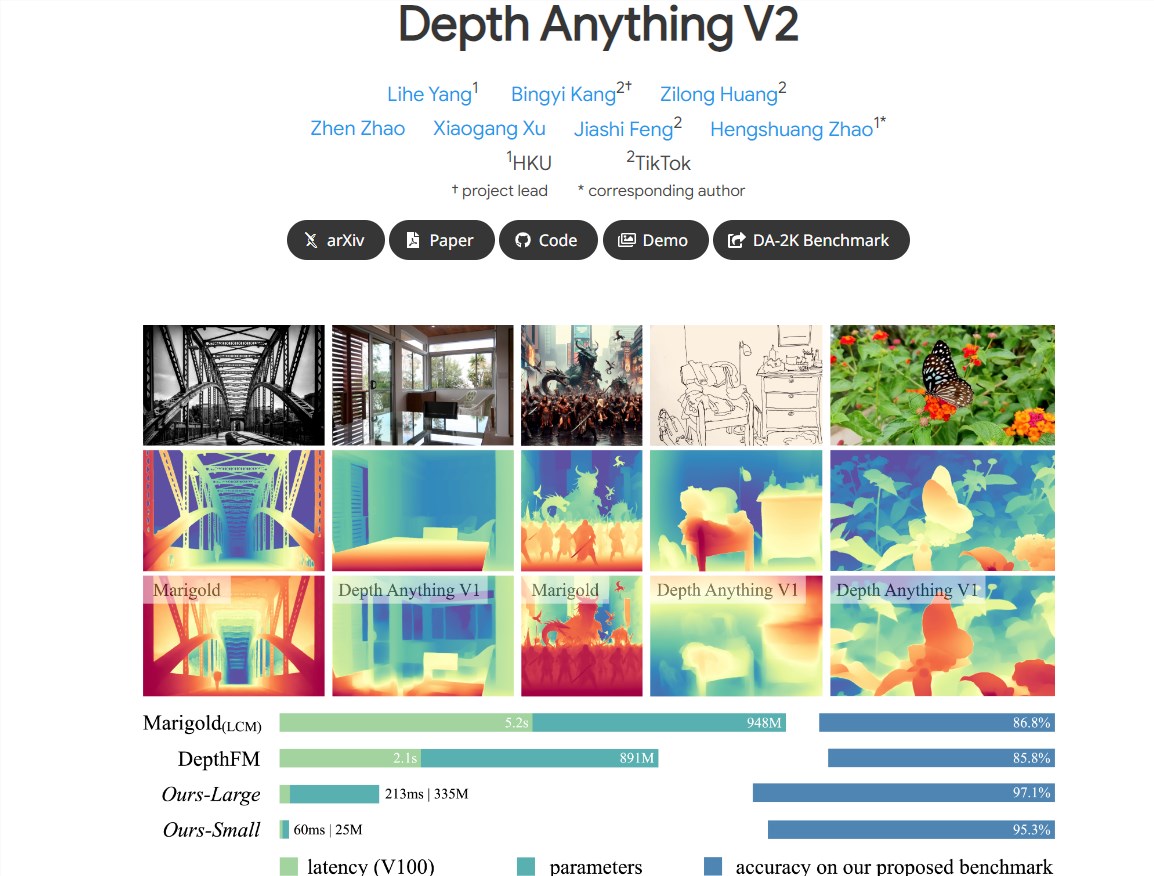

Neuigkeiten von ChinaZ.com vom 14. Juni: ByteDance hat eine neue Generation des Tiefenmodells Depth Anything V2 veröffentlicht, das erhebliche Leistungsverbesserungen im Bereich der monokularen Tiefenschätzung erzielt hat. Im Vergleich zur vorherigen Generation von Depth Anything V1 verfügt die V2-Version über feinere Details und eine stärkere Robustheit, während sie gleichzeitig die Effizienz deutlich verbessert, mehr als zehnmal schneller als das auf Stable Diffusion basierende Modell.

Hauptmerkmale:

Feinere Details: Das V2-Modell ist im Detail optimiert und liefert feinere Tiefenvorhersagen.

Hohe Effizienz und Genauigkeit: Im Vergleich zu auf SD basierenden Modellen weist V2 eine deutlich verbesserte Effizienz und Genauigkeit auf.

Unterstützung mehrerer Skalenmodelle: Bietet Modelle verschiedener Maßstäbe mit Parametern im Bereich von 25 M bis 1,3 B zur Anpassung an verschiedene Anwendungsszenarien.

Schlüsselpraktiken: Verbesserte Modellleistung durch Ersetzen realer Bilder durch synthetische Bilder, Erweitern der Modellkapazität für Lehrkräfte und Verwendung großformatiger pseudoannotierter Bilder zum Unterrichten von Schülermodellen.

Drei Schlüsselpraktiken zur Verbesserung der Modellleistung:

Verwendung synthetischer Bilder: Alle kommentierten realen Bilder werden durch synthetische Bilder ersetzt, was die Trainingseffizienz des Modells verbessert.

Erweiterte Kapazität des Lehrermodells: Durch die Erweiterung der Kapazität des Lehrermodells wird die Generalisierungsfähigkeit des Modells verbessert.

Anwendung pseudokommentierter Bilder: Verwenden Sie großformatige pseudokommentierte reale Bilder als Brücke, um Schülermodelle zu unterrichten und die Robustheit des Modells zu verbessern.

Unterstützung verschiedenster Anwendungsszenarien:

Um den Anforderungen einer breiten Palette von Anwendungen gerecht zu werden, stellen Forscher Modelle in verschiedenen Maßstäben bereit und nutzen ihre Generalisierungsfähigkeiten für die Feinabstimmung durch metrische Tiefenbezeichnungen.

Um zukünftige Forschungen zu erleichtern, wird ein vielfältiger Bewertungsbenchmark erstellt, der spärliche tiefe Anmerkungen enthält.

Trainingsmethoden basierend auf synthetischen und realen Bildern:

Die Forscher trainierten zunächst das größte Lehrermodell auf synthetischen Bildern, generierten dann hochwertige Pseudoetiketten für großformatige unbeschriftete reale Bilder und trainierten Schülermodelle auf diesen pseudoetikettierten realen Bildern.

Der Trainingsprozess verwendet 595.000 synthetische Bilder und mehr als 62 Millionen echte pseudobeschriftete Bilder.

Die Einführung des Depth Anything V2-Modells demonstriert die innovativen Fähigkeiten von ByteDance im Bereich der Deep-Learning-Technologie. Seine effizienten und präzisen Leistungsmerkmale zeigen, dass das Modell über ein breites Anwendungspotenzial im Bereich Computer Vision verfügt.

Projektadresse: https:// Depth-anything-v2.github.io/

Alles in allem markiert die Einführung des Modells Depth Anything V2 einen bedeutenden Fortschritt in der monokularen Tiefenschätzungstechnologie. Seine hohe Effizienz, Genauigkeit und breite Anwendungsaussichten verleihen ihm in der Zukunft ein enormes Entwicklungspotenzial im Bereich Computer Vision, und es lohnt sich, auf seine Implementierung in weiteren Anwendungsszenarien gespannt zu sein.