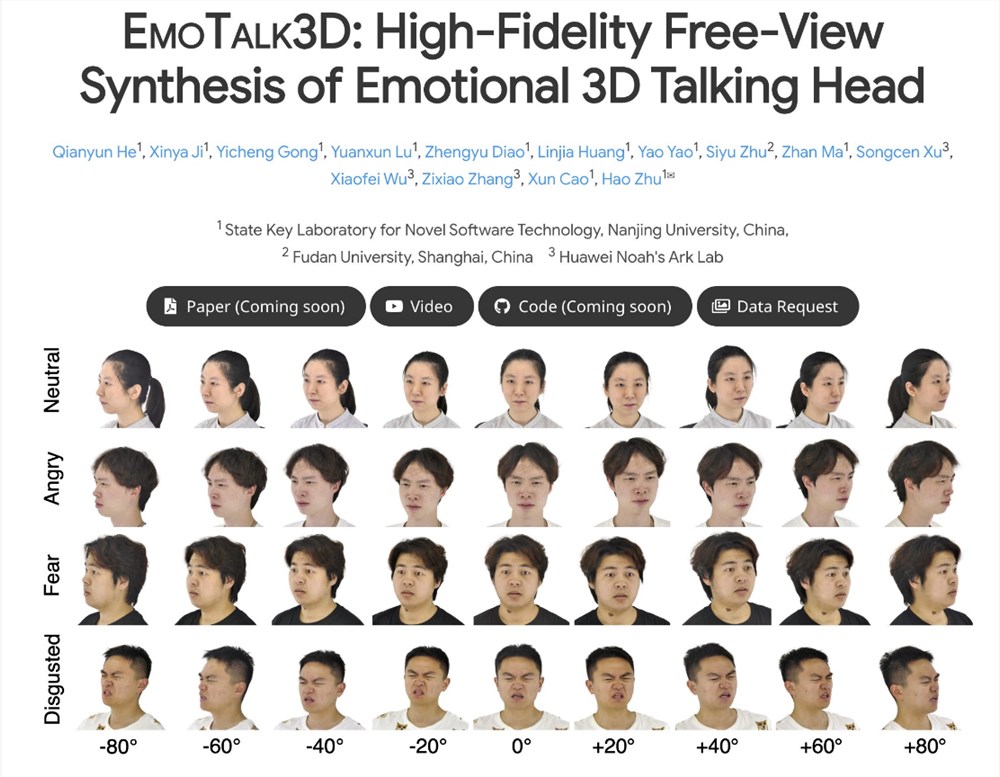

Das EmoTalk3D-Projekt hat bahnbrechende Fortschritte auf dem Gebiet der künstlichen Intelligenz erzielt. Sein Kern liegt in der erfolgreichen Synthese von hochauflösenden, emotionalen sprechenden 3D-Avataren. Dieses Projekt löst die Probleme der vorhandenen Technologie in Bezug auf die Konsistenz mehrerer Ansichten und die Unzulänglichkeit des emotionalen Ausdrucks. Das Framework kann geometrische 3D-Sequenzen genau vorhersagen, das Erscheinungsbild von 3D-Avataren auf der Grundlage einer 4D-Gauß-Darstellung synthetisieren und letztendlich frei sichtbare sprechende Avatar-Animationen erzielen, bei denen selbst subtile Ausdrücke und Falten realistisch dargestellt werden können.

Es wird davon ausgegangen, dass das Forschungsteam des EmoTalk3D-Projekts eine neue Synthesemethode vorgeschlagen hat, um die Mängel der aktuellen sprechenden 3D-Avatar-Technologie in Bezug auf Konsistenz bei mehreren Ansichten und emotionalen Ausdruck zu beheben. Dieser Ansatz ermöglicht nicht nur eine verbesserte Lippensynchronisation und Wiedergabequalität, sondern ermöglicht auch einen kontrollierbaren emotionalen Ausdruck in den generierten sprechenden Avataren.

Das Forschungsteam entwarf ein Mapping-Framework „Sprache zu Geometrie zu Erscheinungsbild“. Das Framework sagt zunächst originalgetreue geometrische 3D-Sequenzen aus Audiomerkmalen voraus und synthetisiert dann auf der Grundlage dieser Geometrien das Erscheinungsbild eines 3D-sprechenden Kopfes, dargestellt durch eine 4D-Gauß-Funktion. In diesem Prozess wird das Erscheinungsbild weiter in kanonische und dynamische Gaußsche Komponenten zerlegt, die durch Lernen aus Multi-View-Videos verschmolzen werden, um eine frei sichtbare, sprechende Avatar-Animation zu erstellen.

Erwähnenswert ist, dass das Forschungsteam des EmoTalk3D-Projekts auch die Schwierigkeiten früherer Methoden bei der Erfassung dynamischer Gesichtsdetails, wie der Darstellung von Falten und subtilen Ausdrücken, erfolgreich gelöst hat. Experimentelle Ergebnisse zeigen, dass diese Methode erhebliche Vorteile bei der Erzeugung von hochauflösenden und emotional kontrollierbaren sprechenden 3D-Avataren bietet und gleichzeitig eine bessere Wiedergabequalität und Stabilität bei der Erzeugung von Lippenbewegungen aufweist.

Derzeit wurden der Code und die Datensätze des EmoTalk3D-Projekts unter der angegebenen HTTPS-URL zur Referenz und Verwendung durch Forscher und Entwickler auf der ganzen Welt veröffentlicht. Dieser innovative technologische Durchbruch wird zweifellos neue Dynamik in die Entwicklung des Bereichs sprechender 3D-Avatare bringen und wird voraussichtlich in Zukunft in vielen Bereichen wie Virtual Reality, Augmented Reality sowie Film- und Fernsehproduktion zum Einsatz kommen.

Der Erfolg des EmoTalk3D-Projekts hat neue Möglichkeiten für die Produktion digitaler 3D-Charaktere eröffnet. Seine hochauflösende, emotionale 3D-Avatar-Technologie wird revolutionäre Veränderungen in den Bereichen Virtual Reality, Augmented Reality sowie Film- und Fernsehproduktion mit sich bringen. In Zukunft können wir uns auf das Aufkommen weiterer Produkte und Anwendungen freuen, die auf der EmoTalk3D-Technologie basieren und den Menschen ein noch intensiveres Erlebnis bieten.