Die offene Kimi-Plattform steht kurz vor dem Start der mit Spannung erwarteten internen Tests der Kontext-Caching-Funktion. Diese innovative Technologie wird das Benutzererlebnis großer Langtextmodelle erheblich verbessern. Durch das Zwischenspeichern doppelter Token-Inhalte kann Kontext-Caching die Kosten für Benutzer, die denselben Inhalt anfordern, erheblich senken und die Antwortgeschwindigkeit der API-Schnittstelle erheblich verbessern. Dies ist besonders wichtig für Anwendungsszenarien, die häufige Anfragen und wiederholte Verweise auf eine große Anzahl von Anfangskontexten erfordern, wie beispielsweise umfangreiche und sich stark wiederholende Eingabeaufforderungsszenarien.

Neuigkeiten von ChinaZ.com vom 20. Juni: Kimi Open Platform gab kürzlich bekannt, dass die mit Spannung erwartete Context-Caching-Funktion bald interne Tests starten wird. Diese innovative Funktion unterstützt große Langtextmodelle und bietet Benutzern durch einen effizienten Kontext-Caching-Mechanismus ein beispielloses Erlebnis.

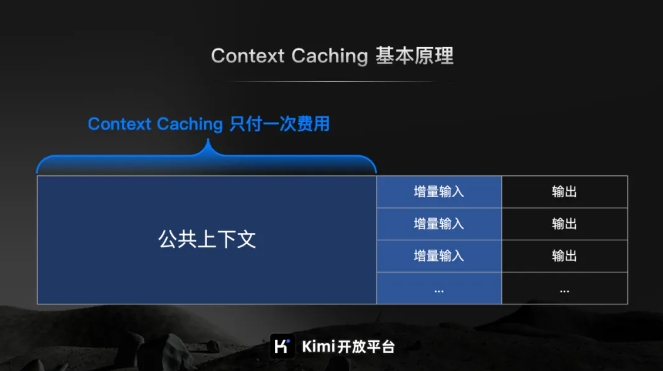

Laut der offiziellen Einführung der Kimi Open Platform handelt es sich bei Context Caching um eine hochmoderne Technologie, die darauf ausgelegt ist, die Kosten für Benutzer, die denselben Inhalt anfordern, durch das Zwischenspeichern doppelter Token-Inhalte erheblich zu senken. Sein Arbeitsprinzip besteht darin, verarbeitete Textfragmente intelligent zu identifizieren und zu speichern. Wenn der Benutzer sie erneut anfordert, kann das System sie schnell aus dem Cache abrufen, wodurch die Antwortgeschwindigkeit der API-Schnittstelle erheblich verbessert wird.

Bei umfangreichen und stark repetitiven Eingabeaufforderungsszenarien kommen die Vorteile der Kontext-Caching-Funktion besonders zum Tragen. Es kann schnell auf eine große Anzahl häufiger Anfragen reagieren und die Verarbeitungseffizienz erheblich verbessern, während gleichzeitig die Kosten durch die Wiederverwendung zwischengespeicherter Inhalte gesenkt werden.

Besonders hervorzuheben ist, dass sich die Context-Caching-Funktion besonders für Anwendungsszenarien eignet, die häufige Anfragen und wiederholte Verweise auf eine große Anzahl von Ausgangskontexten erfordern. Durch diese Funktion können Benutzer auf einfache Weise effizientes Kontext-Caching implementieren und so die Arbeitseffizienz verbessern und die Betriebskosten senken.

Die internen Tests der Kontext-Caching-Funktion stehen kurz vor dem Start, was einen wichtigen Schritt der offenen Kimi-Plattform zur Verbesserung der Effizienz großer Modelle und zur Reduzierung der Benutzerkosten darstellt. Die Zukunft ist vielversprechend.