Die Universität Peking arbeitete mit dem KI-Team von Kuaishou zusammen, um ein neues Videogenerierungs-Framework namens VideoTetris zu entwickeln, das das Problem der komplexen Videogenerierung erfolgreich löste und dessen Leistung kommerzielle Modelle wie Pika und Gen-2 übertraf. Dieses Framework definiert auf innovative Weise kombinierte Videogenerierungsaufgaben, kann Videos anhand komplexer Anweisungen genau generieren und unterstützt die Generierung langer Videos und progressiver Anweisungen mit mehreren Objekten, wodurch die Mängel bestehender Modelle bei der Verarbeitung komplexer Anweisungen und Details, z. B. bei der genauen Lokalisierung mehrerer, effektiv behoben werden Objekte und die Beibehaltung ihrer charakteristischen Details.

Neuigkeiten von ChinaZ.com vom 17. Juni: Die Peking-Universität und das KI-Team von Kuaishou haben zusammengearbeitet, um das Problem der komplexen Videogenerierung erfolgreich zu lösen. Sie schlugen ein neues Framework namens VideoTetris vor, das verschiedene Details wie ein Puzzle einfach kombinieren kann, um Videos mit hohem Schwierigkeitsgrad und komplexen Anweisungen zu erstellen. Dieses Framework übertrifft kommerzielle Modelle wie Pika und Gen-2 bei komplexen Videogenerierungsaufgaben.

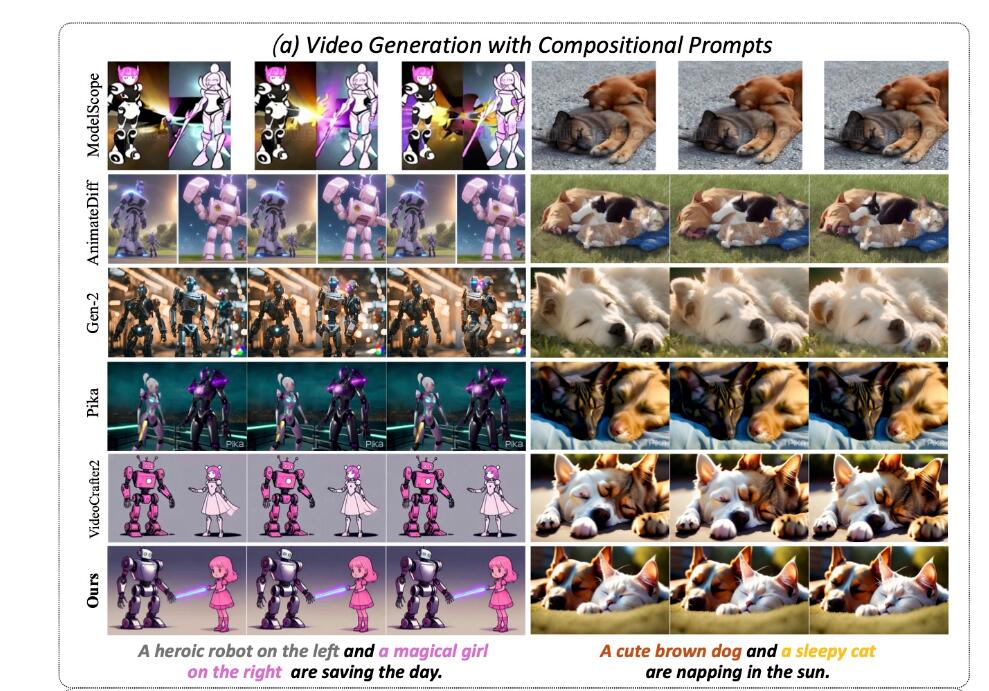

Das VideoTetris-Framework definiert zum ersten Mal die kombinierte Videogenerierungsaufgabe, einschließlich zweier Unteraufgaben: 1) Videogenerierung nach komplexen Kombinationsanweisungen, 2) lange Videogenerierung nach progressiven kombinierten Multiobjektanweisungen. Das Team stellte fest, dass fast alle bestehenden Open-Source- und kommerziellen Modelle keine korrekten Videos generieren konnten. Wenn Sie beispielsweise „links einen süßen braunen Hund und rechts eine schlafende Katze, die in der Sonne ein Nickerchen macht“, eingeben, werden im resultierenden Video häufig Informationen über die beiden Objekte zusammengeführt, was seltsam aussieht.

Im Gegensatz dazu behält VideoTetris erfolgreich alle Standortinformationen und detaillierten Funktionen bei. Bei der Generierung langer Videos unterstützt es komplexere Anweisungen, wie zum Beispiel „Übergang von einem süßen braunen Eichhörnchen auf einem Haufen Haselnüsse zu einem süßen braunen Eichhörnchen und einem süßen weißen Eichhörnchen auf einem Haufen Haselnüsse.“ Die Reihenfolge der generierten Videos stimmt mit den Eingabeanweisungen überein und die beiden Eichhörnchen können auf natürliche Weise Futter austauschen.

Das VideoTetris-Framework verwendet die räumlich-zeitliche kombinierte Diffusionsmethode. Es dekonstruiert zunächst Textaufforderungen nach Zeit und weist verschiedenen Videobildern unterschiedliche Aufforderungsinformationen zu. Anschließend wird die räumliche Dimension in jedem Bild dekonstruiert, um unterschiedliche Objekte unterschiedlichen Videobereichen zuzuordnen. Schließlich wird eine effiziente Generierung von Kombinationsanweisungen durch räumlich-zeitliche Kreuzaufmerksamkeit erreicht.

Um qualitativ hochwertigere Langvideos zu generieren, schlug das Team außerdem eine verbesserte Vorverarbeitungsmethode für Trainingsdaten vor, um die Generierung langer Videos dynamischer und stabiler zu gestalten. Darüber hinaus wird ein Referenzrahmen-Aufmerksamkeitsmechanismus eingeführt und natives VAE wird verwendet, um frühere Rahmeninformationen zu kodieren, was sich von anderen Modellen mit CLIP-Kodierung unterscheidet, wodurch eine bessere Inhaltskonsistenz erreicht wird.

Das Ergebnis der Optimierung ist, dass lange Videos keine großflächigen Farbstiche mehr aufweisen, sich besser an komplexe Anweisungen anpassen können und die generierten Videos dynamischer und natürlicher sind. Das Team führte außerdem die neuen Bewertungsindikatoren VBLIP-VQA und VUnidet ein und weitete damit die Bewertungsmethode der kombinierten Generation erstmals auf die Videodimension aus.

Experimentelle Tests zeigen, dass das VideoTetris-Modell in Bezug auf die kombinierten Videogenerierungsfähigkeiten alle Open-Source-Modelle übertrifft, sogar kommerzielle Modelle wie Gen-2 und Pika. Es wird berichtet, dass der Code vollständig Open Source sein wird.

Projektadresse: https://top.aibase.com/tool/videotetris

Alles in allem hat das VideoTetris-Framework bedeutende Durchbrüche auf dem Gebiet der komplexen Videogenerierung erzielt, und seine effiziente räumlich-zeitliche Kombinationsdiffusionsmethode und innovative Bewertungsindikatoren bieten eine neue Richtung für die Entwicklung zukünftiger Videogenerierungstechnologie. Die Open Source dieses Projekts stellt außerdem mehr Forschern wertvolle Ressourcen zur Verfügung und fördert die weitere Entwicklung auf diesem Gebiet. Wir freuen uns darauf, dass VideoTetris in Zukunft in weiteren Anwendungsszenarien eine Rolle spielen kann.