Forschungsteams von Institutionen wie der Chinesischen Universität Hongkong und der Chinesischen Akademie der Wissenschaften haben kürzlich ein vollständig modales Pre-Training-Paradigma namens MiCo eingeführt, das bahnbrechende Fortschritte im Bereich des multimodalen Lernens erzielt und 37 State-of-the-Arts aktualisiert hat -The-Art-Performance-Rekorde (SOTA). MiCo zielt darauf ab, eine vollmodale Intelligenz aufzubauen, die jede Modalität verstehen und universelle Darstellungen lernen kann, und simuliert den multimodalen kognitiven Prozess des menschlichen Gehirns durch die Einführung weiterer Modalitäten, Datenmengen und Modellparameter. Der Kern besteht darin, verschiedene Modi in „Wissensmodus“ und „Schnittstellenmodus“ zu unterteilen und eine entsprechende vollmodale Lernarchitektur zu entwerfen, wobei multimodaler Kontext verwendet wird, um die gegenseitige Verstärkung zwischen Modalitäten zu stärken und eine modalübergreifende Kontextbeziehung aufzubauen. Dieses Forschungsergebnis liefert neue Richtungen und Ideen für die Entwicklung des Bereichs der Künstlichen Intelligenz.

Neuigkeiten von ChinaZ.com vom 17. Juni: Ein Forschungsteam der Chinesischen Universität Hongkong, der Chinesischen Akademie der Wissenschaften und anderer Institutionen hat ein vollständig modales Pre-Training-Paradigma namens MiCo (Multimodal Context) vorgeschlagen. Diese Methode hat bemerkenswerte Ergebnisse erzielt wurden im Bereich des multimodalen Lernens erreicht und 37 State-of-the-Art-Performance-Rekorde (SOTA) aufgestellt.

Kernfunktionen:

Vollmodales Verständnis: MiCo zielt darauf ab, eine vollmodale Intelligenz aufzubauen, die jede Modalität verstehen und universelle Darstellungen lernen kann.

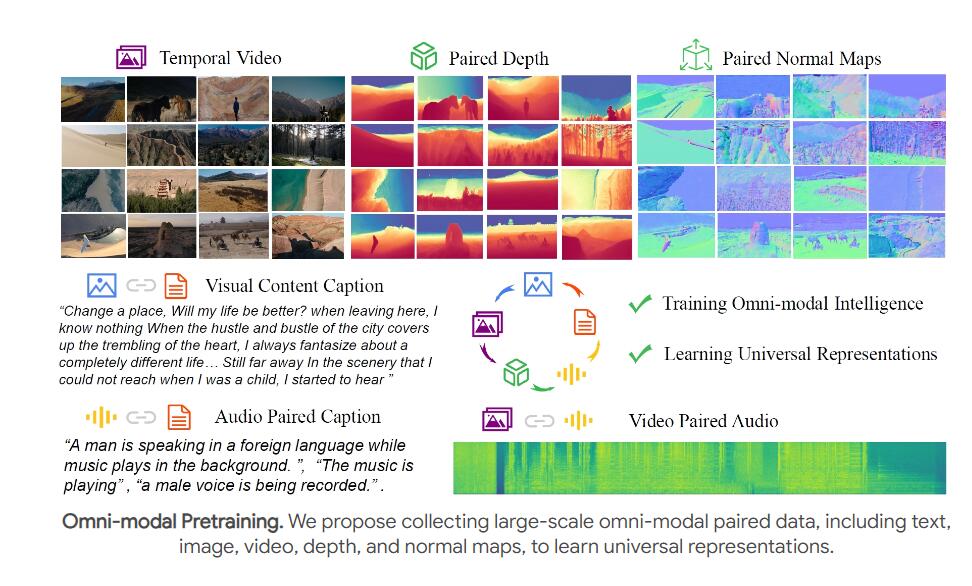

Groß angelegtes Vortraining: Durch die Einführung weiterer Modalitäten, Datenmengen und Modellparameter simuliert MiCo den multimodalen kognitiven Prozess des menschlichen Gehirns während des Vortrainingsprozesses.

Design neuronaler Netzwerkstrukturen: MiCo unterteilt verschiedene Modi in „Wissensmodus“ und „Schnittstellenmodus“ und entwirft eine entsprechende vollmodale Lernarchitektur, die durch generative Argumentationsmethoden ausgerichtet wird.

Multimodaler Kontext und Skalierungsgesetz: MiCo nutzt multimodalen Kontext, um die gegenseitige Verstärkung zwischen Modalitäten zu stärken und modalübergreifende Kontextbeziehungen aufzubauen.

Die experimentellen Ergebnisse zeigen:

Im Single-Modal-Benchmark-Test zur Wahrnehmung von 10 verschiedenen Modi erzielte MiCo 7 SOTA-Ergebnisse.

Bei 25 modalübergreifenden Verständnisaufgaben, einschließlich Abruf, Frage und Antwort, Beschreibung usw., erzielte MiCo 20 SOTA-Ergebnisse.

In 18 multimodalen groß angelegten Benchmark-Tests für Sprachmodelle erzielte MiCo insgesamt 10 SOTA-Ergebnisse.

MiCos Vortrainingsmethode:

Das Team nutzte Videos und gepaarte Audio-, Textbeschreibungen-, Tiefen- und Normalwerte für ein gemeinsames Vortraining, um die visuellen, auditiven und raumzeitlichen Wahrnehmungsfähigkeiten des menschlichen Gehirns zu simulieren.

Multimodale Kontextbeziehungen werden durch Extrahieren multimodaler Features mit einem rein modalen Encoder (z. B. ViT) und Extrahieren von Textfeatures mit einem Textencoder erstellt.

Fazit und zukünftige Arbeit:

Das MiCo-Projekt ist ein wichtiger Versuch der künstlichen Intelligenz, die multimodale Kognition des menschlichen Gehirns zu simulieren. Das Team erwartet, dass es zukünftige Forschungen anregen und leistungsfähigere vollmodale Basismodelle entwickeln wird.

Zukünftige Arbeitspläne umfassen die Kombination weiterer Modalitäten wie optischer Fluss, IMU-Daten und Ereignisdateien, um das vollmodale gemeinsame Vortraining weiter zu verbessern.

Die herausragende Leistung von MiCo hat einen neuen Maßstab im Bereich des multimodalen Lernens gesetzt. Sein zukünftiges Entwicklungspotenzial ist enorm und verdient weitere Aufmerksamkeit. Es lohnt sich auch, auf die zukünftige Forschungsrichtung des Teams zu blicken, und ich glaube, dass MiCo weiterhin die Weiterentwicklung der Technologie der künstlichen Intelligenz vorantreiben wird.