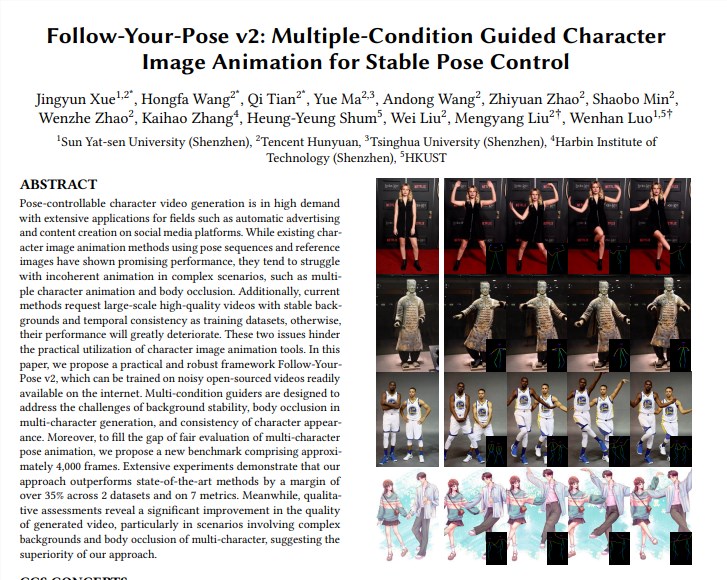

Das Team von Tencent Hunyuan hat sich mit der Sun Yat-sen University und der Hong Kong University of Science and Technology zusammengetan, um ein neues Tusheng-Videomodell „Follow-Your-Pose-v2“ auf den Markt zu bringen und damit einen Durchbruch in der Videogenerierungstechnologie von Einzel- bis Mehrpersonenvideos zu erzielen. Dieses Modell kann Gruppenfotos mehrerer Personen verarbeiten und dafür sorgen, dass sich die Personen auf den Fotos gleichzeitig im generierten Video bewegen, wodurch die Effizienz und Qualität der Videogenerierung erheblich verbessert wird. Der Clou der Technologie besteht darin, dass sie die Generierung von Videoaktionen für mehrere Personen unterstützt, über starke Generalisierungsfähigkeiten verfügt, anhand von Fotos/Videos aus dem täglichen Leben trainiert und generiert werden kann und Probleme wie die Verdeckung von Charakteren korrekt handhaben kann. Das Modell übertrifft bestehende Techniken bei mehreren Datensätzen und demonstriert seine leistungsstarke Leistung und breite Anwendungsaussichten.

Unterstützen Sie die Generierung von Videoaktionen für mehrere Personen: Realisieren Sie die Generierung von Videoaktionen für mehrere Personen mit weniger zeitaufwändiger Argumentation.

Starke Verallgemeinerungsfähigkeit: Es können qualitativ hochwertige Videos unabhängig von Alter, Kleidung, Rasse, Hintergrundunordnung oder Handlungskomplexität erstellt werden.

Fotos/Videos aus dem täglichen Leben verfügbar: Modelltraining und -generation können Fotos aus dem täglichen Leben (einschließlich Schnappschüsse) oder Videos verwenden, ohne nach qualitativ hochwertigen Bildern/Videos suchen zu müssen.

Korrekte Handhabung der Charakterverdeckung: Angesichts des Problems, dass sich die Körper mehrerer Charaktere in einem einzigen Bild gegenseitig blockieren, kann ein Verdeckungsbild mit der richtigen Vorder-zu-Rücken-Beziehung erstellt werden.

Technische Umsetzung:

Das Modell verwendet die „optische Flussführung“, um Hintergrundinformationen zum optischen Fluss einzuführen, die eine stabile Hintergrundanimation erzeugen können, selbst wenn die Kamera wackelt oder der Hintergrund instabil ist.

Durch den „Inference Map Guide“ und den „Depth Map Guide“ kann das Modell die räumlichen Informationen der Charaktere im Bild und die räumlichen Positionsbeziehungen mehrerer Charaktere besser verstehen und die Probleme der Animation mehrerer Charaktere und der Körperverdeckung effektiv lösen .

Bewerten und vergleichen:

Das Team schlug einen neuen Multi-Character-Benchmark vor, der etwa 4.000 Frames von Videos mit mehreren Charakteren enthält, um die Wirkung der Generierung mehrerer Charaktere zu bewerten.

Experimentelle Ergebnisse zeigen, dass „Follow-Your-Pose-v2“ den Stand der Technik bei zwei öffentlichen Datensätzen (TikTok- und TED-Reden) und 7 Indikatoren um mehr als 35 % übertrifft.

Bewerbungsaussichten:

Die Bild-zu-Video-Generierungstechnologie hat breite Anwendungsaussichten in vielen Branchen wie der Produktion von Filminhalten, Augmented Reality, Spieleproduktion und Werbung. Sie ist eine der KI-Technologien, die im Jahr 2024 viel Aufmerksamkeit erregen werden.

Weitere Informationen:

Das Hunyuan-Team von Tencent kündigte außerdem eine Beschleunigungsbibliothek für das große Open-Source-Modell vinzentischer Diagramme (Hunyuan DiT) an, die die Argumentationseffizienz erheblich verbessert und die Zeit für die Diagrammerstellung um 75 % verkürzt.

Der Schwellenwert für die Verwendung des Hunyuan DiT-Modells wurde gesenkt. Benutzer können das Modell in der offiziellen Modellbibliothek von Hugging Face mit drei Codezeilen aufrufen.

Papieradresse: https://arxiv.org/pdf/2406.03035

Projektseite: https://top.aibase.com/tool/follow-your-pose

Das Aufkommen des „Follow-Your-Pose-v2“-Modells stellt einen großen Durchbruch in der Videotechnologie von Tusheng dar und seine Anwendungsaussichten in vielen Bereichen sind gespannt. Angesichts der kontinuierlichen Weiterentwicklung und Verbesserung der Technologie wird davon ausgegangen, dass dieses Modell in Zukunft in mehr Szenarien eine wichtige Rolle spielen und den Menschen ein komfortableres und intelligenteres Videogenerierungserlebnis bieten wird.