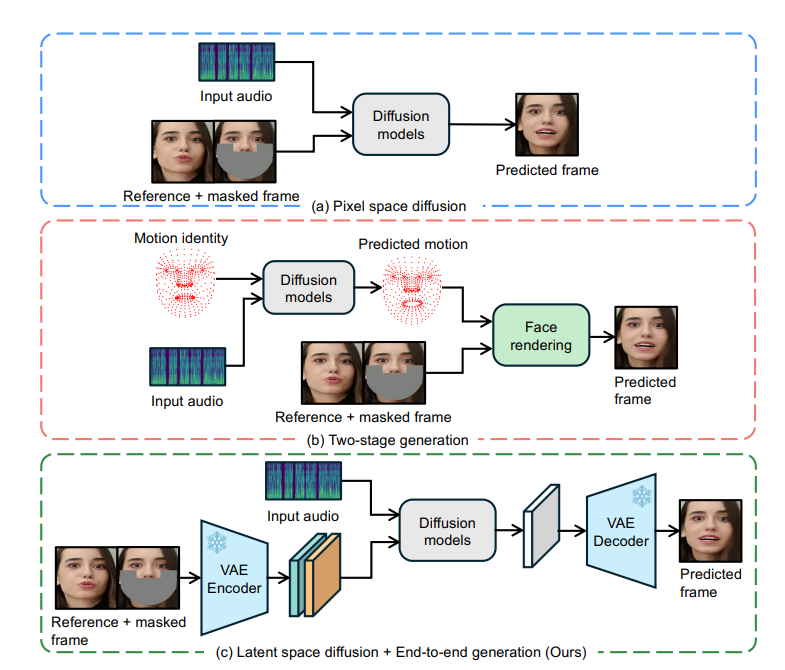

ByteDance hat eine innovative Lippensynchronisationstechnologie namens LatentSync als Open-Source-Lösung bereitgestellt, die auf dem latenten Diffusionsmodell der Audiobedingungen basiert und eine präzise Synchronisierung der Lippenbewegungen der Figur im Video mit dem Audio erreicht. Es nutzt direkt die Leistungsfähigkeit der stabilen Diffusion ohne die Notwendigkeit einer zwischengeschalteten Bewegungsdarstellung, modelliert effektiv komplexe audiovisuelle Assoziationen und verbessert die zeitliche Konsistenz durch die Temporal Representation Alignment (TREPA)-Technologie. LatentSync optimiert außerdem das Konvergenzproblem von SyncNet und verbessert die Genauigkeit der Lippensynchronisation erheblich. Diese Technologie bietet erhebliche Vorteile in Bezug auf End-to-End-Framework, hochwertige Generierung, zeitliche Konsistenz und SyncNet-Optimierung und bietet eine neue Lösung für audiogesteuerte Porträtanimationen.

Es wurde festgestellt, dass diffusionsbasierte Lippensynchronisationsmethoden hinsichtlich der zeitlichen Konsistenz aufgrund von Inkonsistenzen im Diffusionsprozess zwischen verschiedenen Frames schlecht abschneiden. Um dieses Problem zu lösen, führt LatentSync die Time Representation Alignment (TREPA)-Technologie ein. TREPA nutzt zeitliche Darstellungen, die aus großen selbstüberwachten Videomodellen extrahiert wurden, um generierte Bilder mit realen Bildern abzugleichen und so die zeitliche Konsistenz zu verbessern und gleichzeitig die Genauigkeit der Lippensynchronisation aufrechtzuerhalten.

Darüber hinaus führte das Forschungsteam eine eingehende Untersuchung des Konvergenzproblems von SyncNet durch und identifizierte durch eine große Anzahl empirischer Studien die Schlüsselfaktoren, die die Konvergenz von SyncNet beeinflussen, einschließlich Modellarchitektur, Trainingshyperparameter und Datenvorverarbeitungsmethoden. Durch die Optimierung dieser Faktoren wird die Genauigkeit von SyncNet beim HDTF-Testsatz deutlich von 91 % auf 94 % verbessert. Da sich das allgemeine Trainingsgerüst von SyncNet nicht ändert, kann diese Erfahrung auch auf andere Lippensynchronisations- und audiogesteuerte Porträtanimationsmethoden unter Verwendung von SyncNet angewendet werden.

LatentSync-Vorteile

End-to-End-Framework: Generieren Sie synchronisierte Lippenbewegungen direkt aus Audio ohne zwischenzeitliche Bewegungsdarstellung.

Hochwertige Generierung: Nutzen Sie die leistungsstarken Funktionen von Stable Diffusion, um dynamische und realistische Sprachvideos zu generieren.

Zeitliche Konsistenz: Verbessern Sie die zeitliche Konsistenz zwischen Videobildern durch die TREPA-Technologie.

SyncNet-Optimierung: Lösen Sie das Konvergenzproblem von SyncNet und verbessern Sie die Genauigkeit der Lippensynchronisation erheblich.

Funktionsprinzip

Der Kern von LatentSync basiert auf der Bild-zu-Bild-Reparaturtechnologie, die die Eingabe eines maskierten Bildes als Referenz erfordert. Um die visuellen Gesichtsmerkmale des Originalvideos zu integrieren, gibt das Modell auch Referenzbilder ein. Nach dem Kanalspleißen werden diese Eingabeinformationen zur Verarbeitung in das U-Net-Netzwerk eingegeben.

Das Modell verwendet den vorab trainierten Audio-Feature-Extraktor Whisper, um Audioeinbettungen zu extrahieren. Lippenbewegungen können durch den Ton umgebender Frames beeinflusst werden. Daher bündelt das Modell den Ton mehrerer umgebender Frames als Eingabe, um mehr zeitliche Informationen bereitzustellen. Audioeinbettungen werden über Cross-Attention-Layer in U-Net integriert.

Um das Problem zu lösen, dass SyncNet eine Bildraumeingabe erfordert, prognostiziert das Modell zunächst den verrauschten Raum und erhält dann den geschätzten sauberen latenten Raum durch eine einstufige Methode. Die Studie ergab, dass das Training von SyncNet im Pixelraum besser ist als das Training im latenten Raum, was möglicherweise daran liegt, dass die Informationen der Lippenregion während der VAE-Codierung verloren gehen.

Der Trainingsprozess ist in zwei Phasen unterteilt: In der ersten Phase lernt U-Net visuelle Funktionen ohne Pixelraumdekodierung und fügt SyncNet-Verluste hinzu. Die zweite Stufe fügt den SyncNet-Verlust mithilfe der Überwachungsmethode für den dekodierten Pixelraum hinzu und verwendet den LPIPS-Verlust, um die visuelle Qualität des Bildes zu verbessern. Um sicherzustellen, dass das Modell zeitliche Informationen korrekt lernt, muss das Eingangsrauschen auch zeitlich konsistent sein, und das Modell verwendet ein Modell mit gemischtem Rauschen. Darüber hinaus wird in der Datenvorverarbeitungsphase auch eine affine Transformation verwendet, um eine Gesichtsfrontalisierung zu erreichen.

TREPA-Technologie

TREPA verbessert die zeitliche Konsistenz, indem es die zeitlichen Darstellungen generierter und realer Bildsequenzen angleicht. Diese Methode verwendet das groß angelegte selbstüberwachte Videomodell VideoMAE-v2, um zeitliche Darstellungen zu extrahieren. Im Gegensatz zu Methoden, die nur den Abstandsverlust zwischen Bildern nutzen, kann die zeitliche Darstellung zeitliche Korrelationen in Bildsequenzen erfassen und so die allgemeine zeitliche Konsistenz verbessern. Studien haben ergeben, dass TREPA die Genauigkeit der Lippensynchronisation nicht nur beeinträchtigt, sondern sogar verbessern kann.

SyncNet-Konvergenzprobleme

Untersuchungen haben ergeben, dass der Trainingsverlust von SyncNet tendenziell nahe 0,69 bleibt und nicht weiter reduziert werden kann. Durch umfangreiche experimentelle Analysen stellte das Forschungsteam fest, dass die Stapelgröße, die Anzahl der Eingaberahmen und die Datenvorverarbeitungsmethode einen erheblichen Einfluss auf die Konvergenz von SyncNet haben. Auch die Modellarchitektur beeinflusst die Konvergenz, jedoch in geringerem Maße.

Experimentelle Ergebnisse zeigen, dass LatentSync andere hochmoderne Lippensynchronisationsmethoden in mehreren Metriken übertrifft. Insbesondere im Hinblick auf die Genauigkeit der Lippensynchronisation dank des optimierten SyncNet und der Audio-Cross-Attention-Schicht, die die Beziehung zwischen Audio- und Lippenbewegungen besser erfassen kann. Darüber hinaus wurde die Zeitkonsistenz von LatentSync dank der TREPA-Technologie deutlich verbessert.

Projektadresse: https://github.com/bytedance/LatentSync

Die offene Quelle von LatentSync hat neue Durchbrüche bei der Entwicklung der Lippensynchronisationstechnologie gebracht. Seine effiziente, genaue Leistung und optimierten Trainingsmethoden sind forschungs- und anwendungswürdig. Es wird erwartet, dass diese Technologie in Zukunft eine größere Rolle in der Videoproduktion, der virtuellen Realität und anderen Bereichen spielen wird.