Der praktische Anwendungseffekt generativer Sprachmodelle wird häufig durch die Dekodierungsstrategie in der Inferenzphase begrenzt. Bestehende Methoden wie RLHF konzentrieren sich hauptsächlich auf die Gewinnrate des Modells und ignorieren die Auswirkungen von Dekodierungsstrategien auf die Modellleistung, was zu einer geringen Effizienz und Schwierigkeiten bei der Sicherstellung der Ausgabequalität führt. Um dieses Problem zu lösen, haben Google DeepMind und das Google-Forschungsteam das InfAlign-Framework vorgeschlagen, das darauf abzielt, die Inferenzstrategie mit dem Modellausrichtungsprozess zu kombinieren, um die Inferenzleistung und Zuverlässigkeit des Modells zu verbessern.

Generative Sprachmodelle stehen im Prozess vom Training bis zur praktischen Anwendung vor vielen Herausforderungen. Eines der Hauptprobleme besteht darin, wie während der Inferenzphase eine optimale Modellleistung erreicht werden kann.

Aktuelle Gegenmaßnahmen wie Reinforcement Learning through Human Feedback (RLHF) konzentrieren sich hauptsächlich auf die Verbesserung der Gewinnrate des Modells, ignorieren jedoch häufig Dekodierungsstrategien während der Inferenz, wie z. B. Best-of-N-Sampling und kontrollierte Dekodierung. Diese Lücke zwischen Trainingszielen und tatsächlicher Nutzung kann zu Ineffizienzen führen und die Qualität und Zuverlässigkeit der Ergebnisse beeinträchtigen.

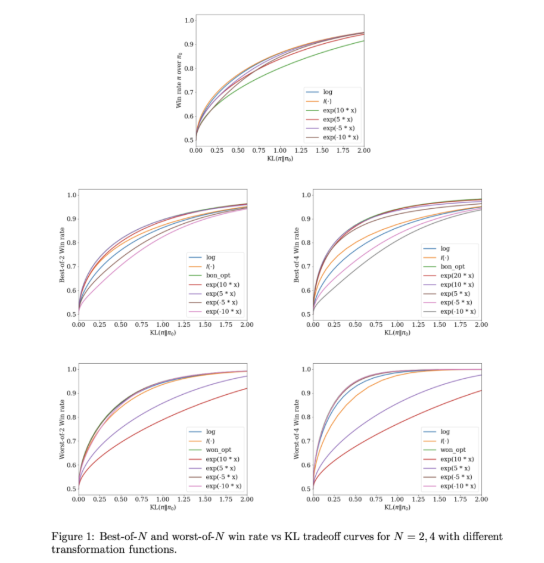

Um diese Probleme anzugehen, haben Google DeepMind und das Google Research-Team InfAlign entwickelt, ein Framework für maschinelles Lernen, das mit Inferenzstrategien kombiniert werden kann. InfAlign integriert Inferenzzeitmethoden in den Alignment-Prozess und ist bestrebt, die Lücke zwischen Training und Anwendung zu schließen. Es verwendet eine kalibrierte Reinforcement-Learning-Methode, um die Belohnungsfunktion basierend auf einer bestimmten Inferenzstrategie anzupassen. InfAlign ist besonders effektiv bei Techniken wie der Best-of-N-Stichprobe (Generierung mehrerer Antworten und Auswahl der besten Antwort) und Worst-of-N (häufig bei Sicherheitsbewertungen verwendet) und stellt sicher, dass das ausgerichtete Modell sowohl in kontrollierten als auch in realen Umgebungen funktioniert -Weltszenarien gut.

Der Kern von InfAlign ist der CTRL-Algorithmus (Calibration and Transformation Reinforcement Learning), der drei Schritte umfasst: Kalibrierung der Belohnungswerte, Transformation dieser Werte gemäß der Inferenzstrategie und Lösung eines KL-regularisierten Optimierungsproblems. InfAlign richtet Trainingsziele an Inferenzanforderungen aus, indem es Belohnungstransformationen an bestimmte Szenarien anpasst. Diese Methode verbessert nicht nur die Gewinnrate während der Inferenz, sondern erhält auch die Recheneffizienz aufrecht. Darüber hinaus erhöht InfAlign die Robustheit des Modells, sodass es verschiedene Dekodierungsstrategien effektiv bewältigen und eine konsistent hochwertige Ausgabe erzeugen kann.

Die Wirksamkeit von InfAlign wird in Experimenten anhand der Nützlichkeits- und Unbedenklichkeitsdatensätze von Anthropic überprüft. Im Vergleich zu bestehenden Methoden verbessert InfAlign die Inferenzgewinnrate um 8–12 % bei der Best-of-N-Stichprobe und um 4–9 % bei der Worst-of-N-Sicherheitsbewertung. Diese Verbesserungen sind auf die kalibrierte Belohnungstransformation zurückzuführen, die das Fehlkalibrierungsproblem des Belohnungsmodells effektiv löst und eine konsistente Leistung in verschiedenen Inferenzszenarien gewährleistet.

InfAlign stellt einen wichtigen Fortschritt bei der Ausrichtung generativer Sprachmodelle dar. Durch die Einbeziehung inferenzbewusster Strategien berücksichtigt InfAlign den entscheidenden Unterschied zwischen Training und Einsatz. Seine solide theoretische Grundlage und empirischen Ergebnisse unterstreichen sein Potenzial, die Ausrichtung von KI-Systemen umfassend zu verbessern.

Link: https://arxiv.org/abs/2412.19792

Höhepunkte:

InfAlign ist ein neues Framework, das von Google DeepMind entwickelt wurde und darauf abzielt, die Leistung von Sprachmodellen in der Inferenzphase zu verbessern.

Dieses Framework passt die Belohnungsfunktion der Inferenzstrategie durch kalibrierte Methoden des verstärkenden Lernens an, um eine Übereinstimmung zwischen Trainingszielen und Inferenzanforderungen zu erreichen.

Experimentelle Ergebnisse zeigen, dass InfAlign die Inferenzgewinnrate des Modells bei mehreren Aufgaben erheblich verbessert und eine gute Anpassungsfähigkeit und Zuverlässigkeit beweist.

Das Aufkommen des InfAlign-Frameworks liefert neue Ideen zur Lösung der Effizienz- und Qualitätsprobleme generativer Sprachmodelle in der Inferenzphase. Sein Beitrag zur Verbesserung der Modellrobustheit und -zuverlässigkeit verdient Aufmerksamkeit. Zukünftige Forschungen können die Anwendung von InfAlign auf verschiedene Modelle und Aufgaben weiter untersuchen, um die Weiterentwicklung der generativen KI-Technologie voranzutreiben.