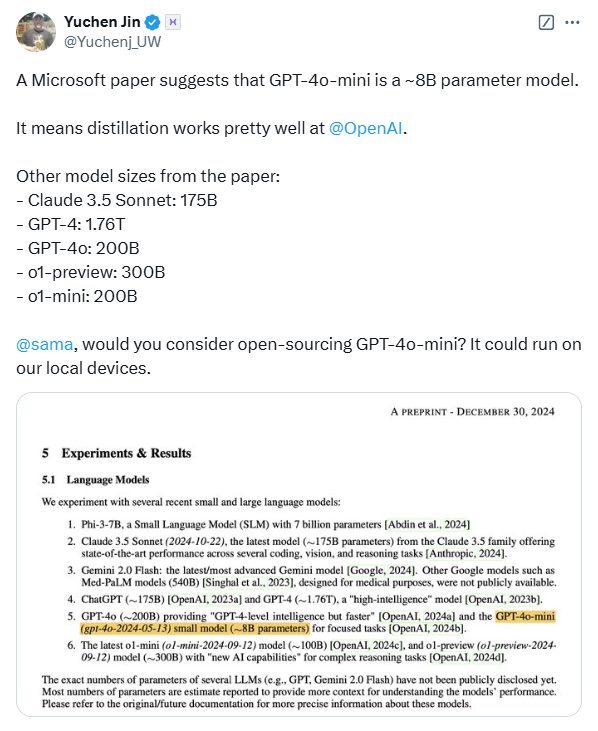

Ein Artikel zur medizinischen KI-Bewertung enthüllte unerwartet die Parametergrößen mehrerer großer Sprachmodelle, was in der Branche große Besorgnis erregte. Dieses von Microsoft veröffentlichte Papier basiert auf dem MEDEC-Benchmark-Test im medizinischen Bereich und schätzt die Modellparameter von OpenAI, Anthropic und anderen Unternehmen, einschließlich Modellen wie der GPT-4-Serie von OpenAI und Claude 3.5 Sonnet von Anthropic. Es gibt Unterschiede zwischen den im Papier genannten Parameterskalen und öffentlichen Informationen. Beispielsweise unterscheidet sich die Parameterskala von GPT-4 stark von den zuvor von NVIDIA angekündigten Daten. Dies hat in der Branche eine hitzige Diskussion über Modellarchitektur und Technik ausgelöst Stärke und löste erneut Bedenken hinsichtlich der Vertraulichkeit von Parametern bei den Menschen aus.

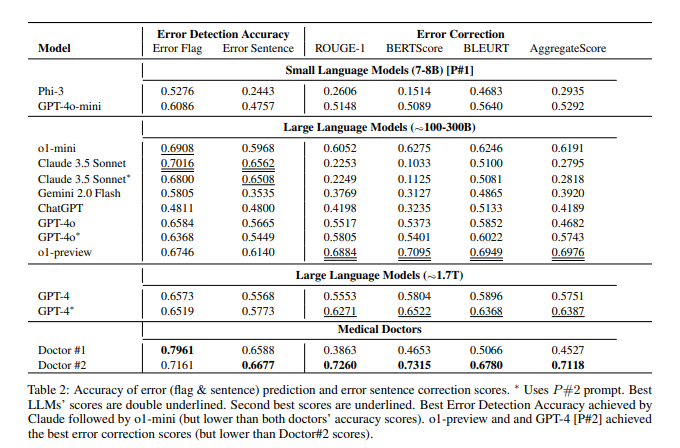

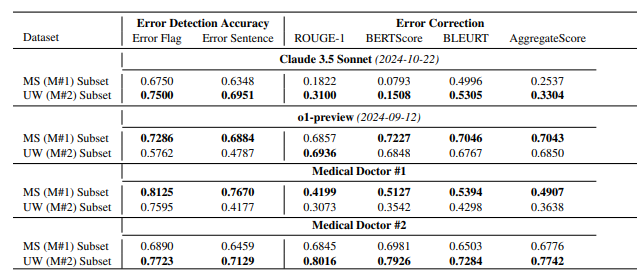

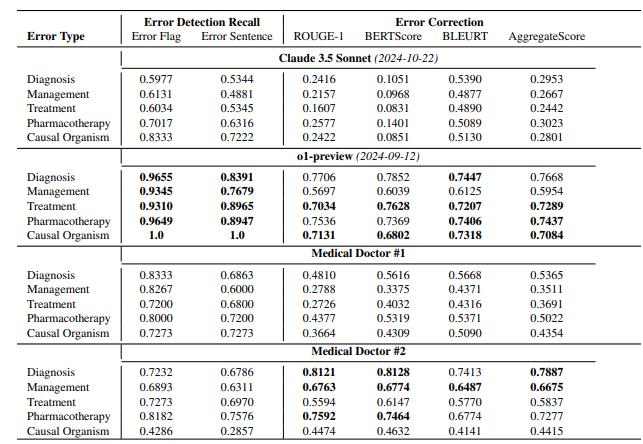

Dem Papier zufolge verfügt das o1-Preview-Modell von OpenAI über etwa 300 B Parameter, GPT-4o über etwa 200 B und GPT-4o-mini über nur 8 B. Die Parametergröße von Claude3.5Sonnet beträgt etwa 175 B. MEDEC-Testergebnisse zeigen, dass Claude3.5Sonnet bei der Fehlererkennung gut abschneidet und einen Wert von 70,16 erreicht. Die Parameter von Google Gemini werden in dem Dokument nicht erwähnt. Dies kann daran liegen, dass Gemini TPU anstelle einer NVIDIA-GPU verwendet, was es schwierig macht, die Geschwindigkeit der Token-Generierung genau abzuschätzen. Die „durchgesickerten“ Parameterinformationen in dem Papier sowie die Bewertungsergebnisse der Modellleistung stellen wertvolle Referenzen für die Branche dar, um gründlich über den Weg der Großmodelltechnologie, den Geschäftswettbewerb und zukünftige Entwicklungsrichtungen nachzudenken.

Dies ist nicht das erste Mal, dass Microsoft Modellparameterinformationen in Papieren „durchsickern lässt“. Im Oktober letzten Jahres gab Microsoft in einem Papier die 20B-Parametergröße von GPT-3.5-Turbo bekannt, löschte diese Informationen jedoch später in einer aktualisierten Version. Dieses wiederholte „Leck“ hat unter Brancheninsidern zu Spekulationen darüber geführt, ob es konkrete Absichten gibt.

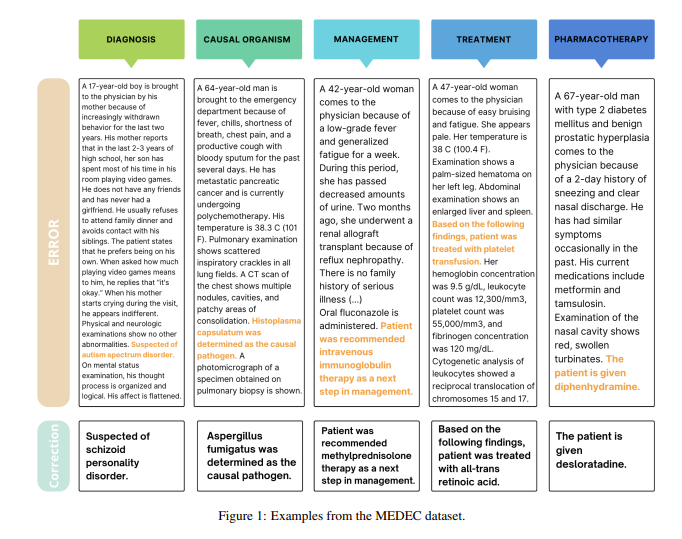

Es ist erwähnenswert, dass der Hauptzweck dieses Papiers darin besteht, einen Benchmark im medizinischen Bereich namens MEDEC einzuführen. Das Forschungsteam analysierte 488 klinische Notizen von drei US-Krankenhäusern und bewertete die Fähigkeit wichtiger Modelle, Fehler in der medizinischen Dokumentation zu erkennen und zu korrigieren. Die Testergebnisse zeigen, dass Claude3.5Sonnet mit einem Wert von 70,16 andere Modelle bei der Fehlererkennung anführt.

Über die Authentizität dieser Daten wird in der Branche heftig diskutiert. Einige Leute glauben, dass die technische Stärke von Anthropic unterstrichen wird, wenn Claude3.5Sonnet mit einer geringeren Anzahl von Parametern eine hervorragende Leistung erzielt. Einige Analysten glauben auch, dass einige Parameterschätzungen durch Modellpreisinferenzen angemessen sind.

Besonders hervorzuheben ist, dass das Papier nur die Parameter des Mainstream-Modells schätzt, die spezifischen Parameter von Google Gemini jedoch nicht erwähnt. Einige Analysten glauben, dass dies möglicherweise mit der Verwendung von TPU anstelle der NVIDIA-GPU durch Gemini zusammenhängt, was es schwierig macht, die Geschwindigkeit der Token-Generierung genau abzuschätzen.

Während OpenAI sein Open-Source-Engagement schrittweise abschwächt, rücken Kerninformationen wie Modellparameter möglicherweise weiterhin in den Mittelpunkt der anhaltenden Aufmerksamkeit der Branche. Dieses unerwartete Leck löste erneut ein tiefgreifendes Nachdenken der Menschen über die Architektur von KI-Modellen, technische Wege und den Geschäftswettbewerb aus.

Referenzen:

https://arxiv.org/pdf/2412.19260

https://x.com/Yuchenj_UW/status/1874507299303379428

https://www.reddit.com/r/LocalLLaMA/comments/1f1vpyt/why_gpt_4o_mini_is_probably_around_8b_active/

Alles in allem sind die in diesem Artikel „durchgesickerten“ Informationen zu Modellparametern zwar nicht der Hauptinhalt der Forschung des Artikels, haben jedoch in der Branche eingehende Diskussionen über den Maßstab großer Modellparameter, die Auswahl technischer Routen usw. ausgelöst Die kommerzielle Wettbewerbslandschaft bietet eine Grundlage für die zukünftige Entwicklung des Bereichs der künstlichen Intelligenz und bietet neue Denkrichtungen.