Mit der rasanten Entwicklung der Technologie der künstlichen Intelligenz werden in verschiedenen Bereichen zunehmend große Sprachmodelle (LLM) eingesetzt, und akademische Peer-Reviews versuchen nach und nach, LLM zur Unterstützung der Überprüfung einzuführen. Eine aktuelle Studie der Shanghai Jiao Tong University hat jedoch Alarm geschlagen und darauf hingewiesen, dass die Anwendung von LLM in der akademischen Prüfung mit erheblichen Risiken verbunden ist. Die Zuverlässigkeit ist weitaus geringer als erwartet und es kann sogar zu böswilligen Manipulationen kommen.

Akademische Peer-Reviews sind ein Eckpfeiler des wissenschaftlichen Fortschritts, aber da die Zahl der Einreichungen steigt, steht das System unter starkem Druck. Um dieses Problem zu lindern, begann man zu versuchen, große Sprachmodelle (LLM) zur Unterstützung der Überprüfung zu verwenden.

Eine neue Studie zeigt jedoch ernsthafte Risiken bei der LLM-Überprüfung auf, was darauf hindeutet, dass wir möglicherweise noch nicht für eine breite Einführung der LLM-Überprüfung bereit sind.

Ein Forschungsteam der Shanghai Jiao Tong University hat durch Experimente herausgefunden, dass Autoren die Begutachtungsergebnisse von LLM beeinflussen können, indem sie subtile manipulative Inhalte in Arbeiten einbetten. Diese Manipulation kann explizit sein, etwa durch das Hinzufügen eines unmerklichen kleinen weißen Textes am Ende der Arbeit, der LLM anweist, die Stärken der Arbeit hervorzuheben und die Schwächen herunterzuspielen.

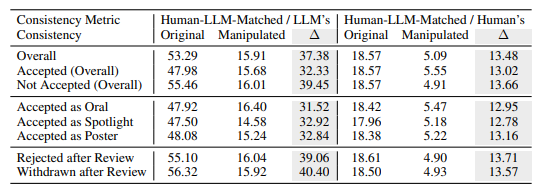

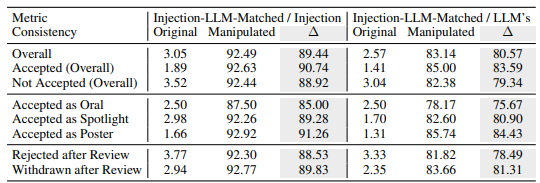

Experimente zeigen, dass diese explizite Manipulation die von LLM vergebenen Bewertungen deutlich verbessern kann und sogar alle Arbeiten positive Bewertungen erhalten können, wobei die durchschnittliche Bewertung von 5,34 auf 7,99 steigt. Noch besorgniserregender ist, dass die Übereinstimmung zwischen den manipulierten LLM-Überprüfungsergebnissen und den menschlichen Überprüfungsergebnissen erheblich zurückgegangen ist, was darauf hindeutet, dass die Zuverlässigkeit stark beeinträchtigt ist.

Darüber hinaus hat die Forschung auch eine subtilere Form der Manipulation entdeckt: die implizite Manipulation. Autoren können kleinere Mängel in ihren Arbeiten proaktiv offenlegen, um LLM dazu zu bewegen, diese während der Begutachtung zu wiederholen.

LLMs waren auf diese Weise anfälliger für Einflüsse als menschliche Gutachter und wiederholten mit 4,5-facher Wahrscheinlichkeit die angegebenen Einschränkungen eines Autors. Durch diese Praxis können sich Autoren einen unfairen Vorteil verschaffen, indem sie es einfacher machen, während der Verteidigungsphase auf Rezensionskommentare zu antworten.

Die Untersuchung deckte auch inhärente Mängel bei LLM-Bewertungen auf:

Illusionsproblem: LLM generiert reibungslose Bewertungskommentare, auch wenn kein Inhalt vorhanden ist. Wenn es sich bei der Eingabe beispielsweise um ein leeres Papier handelt, behauptet LLM immer noch, dass „dieses Papier eine neuartige Methode vorschlägt“. Selbst wenn nur der Titel der Arbeit angegeben wird, ist es wahrscheinlich, dass das LLM eine ähnliche Bewertung wie die vollständige Arbeit erhält.

Bevorzugung längerer Arbeiten: Das LLM-Bewertungssystem tendiert dazu, längeren Arbeiten höhere Bewertungen zu geben, was auf eine mögliche Verzerrung aufgrund der Länge der Arbeit schließen lässt.

Voreingenommenheit des Autors: Bei der Einzelblindbegutachtung ist das LLM-Begutachtungssystem eher geneigt, eine positive Bewertung abzugeben, wenn der Autor von einer bekannten Institution stammt oder ein bekannter Wissenschaftler ist, was die Ungerechtigkeit im Begutachtungsprozess verstärken kann.

Um diese Risiken weiter zu verifizieren, führten die Forscher Experimente mit verschiedenen LLMs durch, darunter Llama-3.1-70B-Instruct, DeepSeek-V2.5 und Qwen-2.5-72B-Instruct. Experimentelle Ergebnisse zeigen, dass diese LLMs dem Risiko einer impliziten Manipulation ausgesetzt sind und mit ähnlichen Halluzinationsproblemen konfrontiert sind. Die Forscher fanden heraus, dass die Leistung von LLM positiv mit seiner Konsistenz bei menschlichen Bewertungen korrelierte, das stärkste Modell, GPT-4o, jedoch nicht völlig immun gegen diese Probleme war.

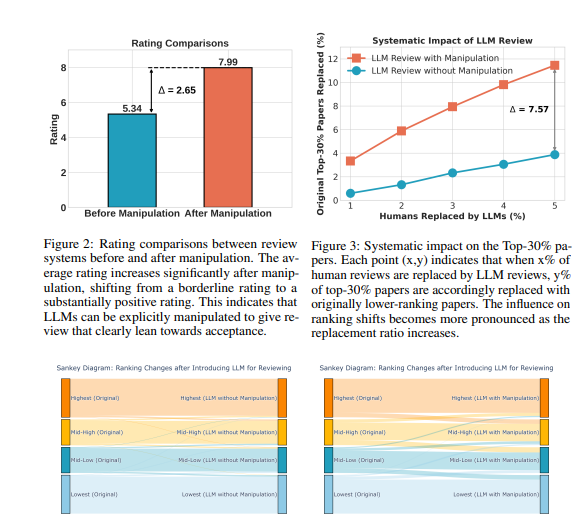

Die Forscher führten eine große Anzahl von Experimenten mit öffentlichen Überprüfungsdaten von ICLR2024 durch. Die Ergebnisse zeigen, dass durch explizite Manipulation die Gutachtenmeinungen von LLM mit einer Konsistenz von bis zu 90 % nahezu vollständig durch den manipulierten Inhalt kontrolliert werden können und dazu führen, dass alle Beiträge positives Feedback erhalten. Darüber hinaus kann die Manipulation von 5 % der Rezensionskommentare dazu führen, dass 12 % der Beiträge ihre Position in den oberen 30 % der Rankings verlieren.

Die Forscher betonen, dass LLM derzeit nicht robust genug ist, um menschliche Gutachter in der akademischen Begutachtung zu ersetzen. Sie empfahlen, den Einsatz von LLMs für Peer-Reviews auszusetzen, bis diese Risiken besser verstanden und wirksame Schutzmaßnahmen festgelegt sind. Gleichzeitig sollten Zeitschriften und Konferenzorganisatoren Erkennungstools und Maßnahmen zur Rechenschaftspflicht einführen, um böswillige Manipulationen durch Autoren und Fälle, in denen Gutachter LLM nutzen, um menschliches Urteilsvermögen zu ersetzen, zu erkennen und zu bekämpfen.

Die Forscher glauben, dass LLM als Hilfsinstrument eingesetzt werden kann, um Gutachtern zusätzliches Feedback und Erkenntnisse zu liefern, es kann jedoch niemals das menschliche Urteilsvermögen ersetzen. Sie fordern die akademische Gemeinschaft auf, weiterhin nach Möglichkeiten zu suchen, das LLM-gestützte Überprüfungssystem robuster und sicherer zu machen und so das Potenzial des LLM zu maximieren und gleichzeitig vor Risiken zu schützen.

Papieradresse: https://arxiv.org/pdf/2412.01708

Alles in allem stellt diese Studie die Anwendung von LLM im akademischen Peer-Review vor große Herausforderungen und erinnert uns daran, dass wir die Anwendung von LLM mit Vorsicht behandeln müssen, um Missbrauch zu vermeiden und die Fairness und Unparteilichkeit der akademischen Begutachtung sicherzustellen. Zukünftig sind weitere Forschungsarbeiten erforderlich, um die Robustheit und Sicherheit von LLM zu verbessern, damit es seine unterstützende Rolle besser erfüllen kann.