MiniMax hat am 15. Januar 2025 eine neue Open-Source-Modellreihe MiniMax-01 veröffentlicht, darunter das große Textmodell MiniMax-Text-01 und das visuelle multimodale große Modell MiniMax-VL-01. Diese Reihe von Modellparametern erreicht bis zu 456 Milliarden, mit einer einzigen Aktivierung von 45,9 Milliarden. Sie führt mutige Innovationen in der Architektur ein und wendet den linearen Aufmerksamkeitsmechanismus zum ersten Mal in großem Maßstab an, wodurch die Einschränkungen des traditionellen Transformators durchbrochen werden der effizienten Verarbeitung von Kontexten von bis zu 4 Millionen Token, deutlich vor bestehenden Modellen. Die MiniMax-01-Serie liegt in puncto Leistung auf Augenhöhe mit Top-Modellen aus Übersee und weist erhebliche Vorteile bei der Langtextverarbeitung auf. Ihre effizienten Verarbeitungsfähigkeiten und ihr niedriger Preis machen sie bei kommerziellen Anwendungen äußerst wettbewerbsfähig.

MiniMax kündigte am 15. Januar 2025 die Open Source seiner neuen Modellserie MiniMax-01 an. Die Serie umfasst das große Basissprachenmodell MiniMax-Text-01 und das visuelle multimodale große Modell MiniMax-VL-01. Die MiniMax-01-Serie hat mutige Innovationen in der Architektur hervorgebracht und zum ersten Mal einen linearen Aufmerksamkeitsmechanismus in großem Maßstab implementiert und damit die Einschränkungen der traditionellen Transformer-Architektur durchbrochen. Sein Parametervolumen beträgt bis zu 456 Milliarden, und eine einzelne Aktivierung beträgt 45,9 Milliarden. Seine Gesamtleistung ist mit Top-Modellen aus Übersee vergleichbar und es kann Kontexte mit bis zu 4 Millionen Token effizient verarbeiten. Diese Länge ist 32-mal so groß wie die von GPT-4o und Claude-3,5-Sonett 20 Mal.

MiniMax glaubt, dass 2025 ein entscheidendes Jahr für die schnelle Entwicklung von Agenten sein wird. Unabhängig davon, ob es sich um ein Einzelagentensystem oder ein Multiagentensystem handelt, ist ein längerer Kontext erforderlich, um kontinuierlichen Speicher und große Kommunikationsmengen zu unterstützen. Die Einführung der MiniMax-01-Modellreihe soll genau dieser Nachfrage gerecht werden und den ersten Schritt zur Etablierung der Grundfähigkeiten komplexer Agenten machen.

Dank architektonischer Innovation, Effizienzoptimierung und integriertem Cluster-Training und Push-Design kann MiniMax Text- und multimodale Verständnis-API-Dienste zum niedrigsten Preis der Branche anbieten. Der Standardpreis beträgt 1 Yuan/Million Token für den Input und 8 für den Output-Token Yuan/Hundert. 10.000 Token. Die offene MiniMax-Plattform und die Überseeversion wurden für Entwickler eingeführt.

Die Modelle der MiniMax-01-Serie sind Open Source auf GitHub und werden kontinuierlich aktualisiert. In den gängigen Text- und multimodalen Verständnisbewertungen der Branche lag die MiniMax-01-Serie bei den meisten Aufgaben gleichauf mit den international anerkannten fortgeschrittenen Modellen GPT-4o-1120 und Claude-3.5-Sonnet-1022. Insbesondere bei Langtextaufgaben weist MiniMax-Text-01 im Vergleich zum Gemini-Modell von Google den langsamsten Leistungsabfall mit zunehmender Eingabelänge auf, was deutlich besser ist als bei Gemini.

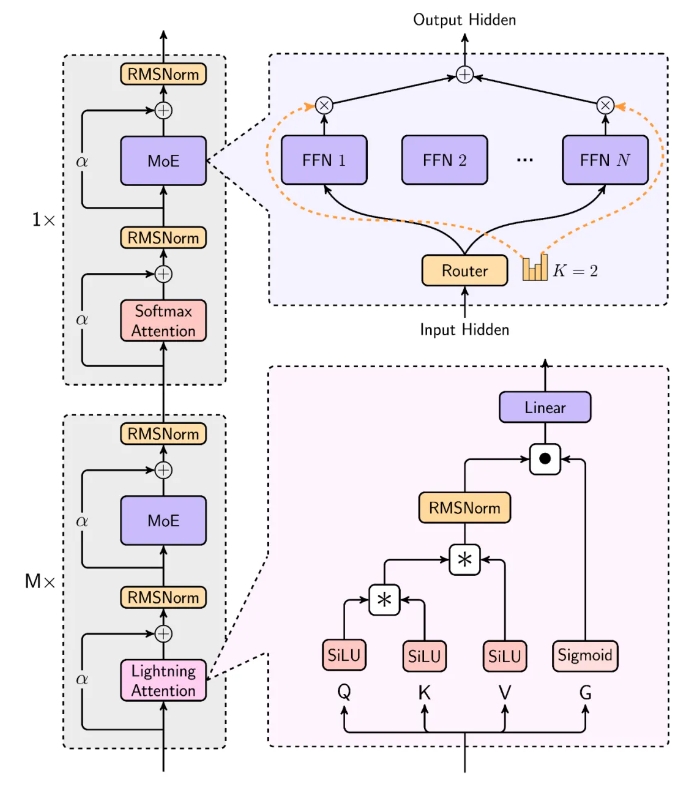

Das Modell von MiniMax ist bei der Verarbeitung langer Eingaben äußerst effizient und nähert sich der linearen Komplexität. Im Strukturdesign verwenden 7 von 8 Schichten lineare Aufmerksamkeit basierend auf Lightning Attention und 1 Schicht nutzt traditionelle SoftMax-Aufmerksamkeit. Dies ist das erste Mal in der Branche, dass der lineare Aufmerksamkeitsmechanismus auf die Ebene kommerzieller Modelle ausgeweitet wurde. MiniMax hat das Skalierungsgesetz, die Kombination mit MoE, das Strukturdesign, die Trainingsoptimierung und die Inferenzoptimierung umfassend berücksichtigt und das Trainings- und Inferenzsystem rekonstruiert. einschließlich effizienterer MoE-All-to-All-Kommunikationsoptimierung, längerer Sequenzoptimierung und effizienter Kernel-Implementierung der linearen Aufmerksamkeit auf der Inferenzebene.

In den meisten akademischen Tests hat die MiniMax-01-Serie Ergebnisse erzielt, die mit denen der ersten Stufe im Ausland vergleichbar sind. Es liegt in der Langzeitkontextbewertung deutlich vorn, wie beispielsweise seine hervorragende Leistung bei der 4-Millionen-Needle-In-A-Haystack-Abrufaufgabe. Neben akademischen Datensätzen erstellte MiniMax auch einen Testsatz für Assistenzszenarien auf der Grundlage realer Daten, und MiniMax-Text-01 schnitt in diesem Szenario hervorragend ab. Auch im multimodalen Verständnis-Testset liegt MiniMax-VL-01 vorne.

Open-Source-Adresse: https://github.com/MiniMax-AI

Die Open-Source-Modelle der MiniMax-01-Serie haben der Entwicklung des KI-Bereichs neue Dynamik verliehen. Ihre Durchbrüche in der Langtextverarbeitung und im multimodalen Verständnis werden die schnelle Entwicklung der Agententechnologie und verwandter Anwendungen fördern. Wir freuen uns auf weitere Innovationen und Durchbrüche von MiniMax in der Zukunft.