Mit dem explosionsartigen Wachstum des Videodatenvolumens ist die Frage, wie Videoinformationen effektiv zum Abrufen von Wissen und zur Beantwortung von Fragen genutzt werden können, zu einem Forschungsschwerpunkt geworden. Herkömmliche RAG-Systeme (Retrieval-Augmented Generation) stützen sich meist auf Textinformationen und können die reichhaltigen multimodalen Informationen, die in Videos enthalten sind, nur schwer ausschöpfen. In diesem Artikel wird ein neuartiges Framework namens VideoRAG vorgestellt, das in der Lage ist, für eine Anfrage relevante Videos dynamisch abzurufen und visuelle und textliche Informationen effektiv zu integrieren, um genauere und informativere Antworten zu generieren. Das Framework nutzt Large Video Language Models (LVLMs), um eine nahtlose Integration multimodaler Daten zu erreichen und verarbeitet nicht untertitelte Videos durch automatische Spracherkennungstechnologie, wodurch die Abruf- und Generierungseffizienz erheblich verbessert wird.

Mit der rasanten Entwicklung der Videotechnologie ist Video zu einem wichtigen Werkzeug für den Informationsabruf und das Verständnis komplexer Konzepte geworden. Video kombiniert visuelle, zeitliche und kontextbezogene Daten, um eine multimodale Darstellung über statische Bilder und Text hinaus bereitzustellen. Mit der zunehmenden Verbreitung von Video-Sharing-Plattformen und der Verbreitung von Lehr- und Informationsvideos bietet die Nutzung von Videos als Wissensquelle heute beispiellose Möglichkeiten zur Lösung von Fragen, die detaillierten Kontext, räumliches Verständnis und Prozessdemonstration erfordern.

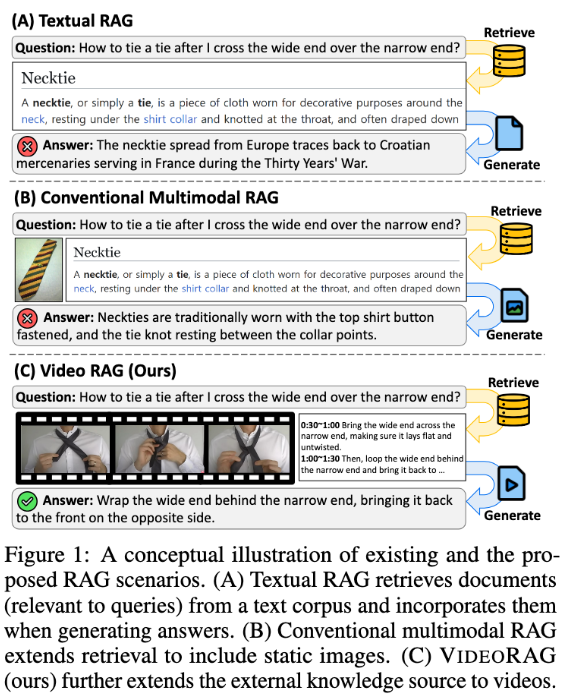

Allerdings übersehen bestehende Retrieval-Augmented Generation (RAG)-Systeme oft das volle Potenzial von Videodaten. Diese Systeme stützen sich häufig auf Textinformationen und verwenden gelegentlich statische Bilder zur Unterstützung von Abfrageantworten, erfassen jedoch nicht die visuelle Dynamik und die multimodalen Hinweise, die in Videos enthalten sind, die für komplexe Aufgaben von entscheidender Bedeutung sind. Herkömmliche Ansätze definieren entweder abfragebezogene Videos ohne Abruf vor oder konvertieren die Videos in ein Textformat, wodurch wichtiger visueller Kontext und zeitliche Dynamik verloren gehen und die Fähigkeit, genaue und informative Antworten zu liefern, eingeschränkt wird.

Um diese Probleme zu lösen, schlug das Forschungsteam des Korea Advanced Institute of Science and Technology (KaIST) und DeepAuto.ai ein neuartiges Framework vor – VideoRAG. Das Framework ist in der Lage, für eine Anfrage relevante Videos dynamisch abzurufen und visuelle und textliche Informationen in den Generierungsprozess zu integrieren. VideoRAG nutzt fortschrittliche LVLMs (Large-Scale Video Language Models), um eine nahtlose Integration multimodaler Daten zu erreichen und sicherzustellen, dass abgerufene Videos kontextuell mit Benutzeranfragen übereinstimmen und die zeitliche Vielfalt der Videoinhalte erhalten bleibt.

Der Workflow von VideoRAG ist in zwei Hauptphasen unterteilt: Abrufen und Generieren. Während der Abrufphase identifiziert das Framework durch die Abfrage Videos, die ihren visuellen und textlichen Merkmalen ähneln.

In der Generierungsphase wird die automatische Spracherkennungstechnologie verwendet, um Hilfstextdaten für Videos ohne Untertitel zu generieren und so sicherzustellen, dass die Antwortgenerierung für alle Videos effektiv Informationen beitragen kann. Die relevanten abgerufenen Videos werden weiter in das Generierungsmodul eingegeben, das multimodale Daten wie Videobilder, Untertitel und Abfragetext integriert und sie mithilfe von LVLMs verarbeitet, um lange, umfassende, genaue und kontextbezogene Antworten zu generieren.

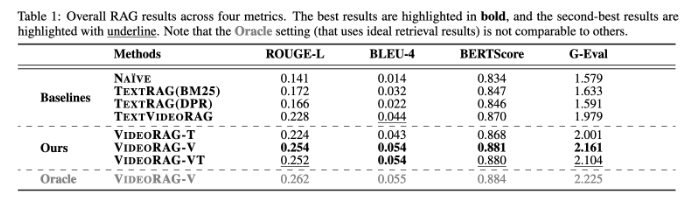

VideoRAG führt umfangreiche Experimente mit Datensätzen wie WikiHowQA und HowTo100M durch und die Ergebnisse zeigen, dass die Antwortqualität deutlich besser ist als bei herkömmlichen Methoden. Dieses neue Framework verbessert nicht nur die Fähigkeiten von Systemen zur Generierung von Retrieval-Enhancements, sondern setzt auch neue Maßstäbe für zukünftige multimodale Retrieval-Systeme.

Papier: https://arxiv.org/abs/2501.05874

Highlight:

**Neues Framework**: VideoRAG ruft relevante Videos dynamisch ab und führt visuelle und textliche Informationen zusammen, um den Generierungseffekt zu verbessern.

**Experimentelle Verifizierung**: Getestet an mehreren Datensätzen, zeigt deutlich bessere Antwortqualität als die herkömmliche RAG-Methode.

**Technische Innovation**: Mithilfe groß angelegter Videosprachmodelle schlägt VideoRAG ein neues Kapitel in der multimodalen Datenintegration auf.

Alles in allem bietet das VideoRAG-Framework eine neue Lösung für videobasierte Abrufverbesserungsaufgaben. Seine Durchbrüche bei der multimodalen Datenintegration und dem Informationsabruf liefern wichtige Informationen für zukünftige intelligentere und genauere Informationsabrufsysteme. Es wird erwartet, dass die Forschungsergebnisse in der Bildung, Medizin und anderen Bereichen breite Anwendung finden.