Die audiogesteuerte Bildanimationstechnologie hat in den letzten Jahren erhebliche Fortschritte gemacht, doch die Komplexität und Effizienzprobleme bestehender Modelle schränken ihre Anwendung ein. Um diese Probleme zu lösen, haben Forscher eine neue Technologie namens JoyVASA entwickelt, die durch ein innovatives zweistufiges Design die Qualität, Effizienz und den Anwendungsbereich audiogesteuerter Bildanimationen deutlich verbessert. JoyVASA ist nicht nur in der Lage, längere animierte Videos zu erstellen, sondern animiert auch menschliche Porträts und Tiergesichter und unterstützt mehrere Sprachen.

Kürzlich haben Forscher eine neue Technologie namens JoyVASA vorgeschlagen, die darauf abzielt, audiogesteuerte Bildanimationseffekte zu verbessern. Durch die kontinuierliche Weiterentwicklung von Deep-Learning- und Diffusionsmodellen hat die audiogesteuerte Porträtanimation erhebliche Fortschritte bei der Videoqualität und der Genauigkeit der Lippensynchronisation gemacht. Allerdings erhöht die Komplexität bestehender Modelle die Effizienz von Training und Inferenz, begrenzt aber auch die Dauer und die Kontinuität zwischen Bildern von Videos.

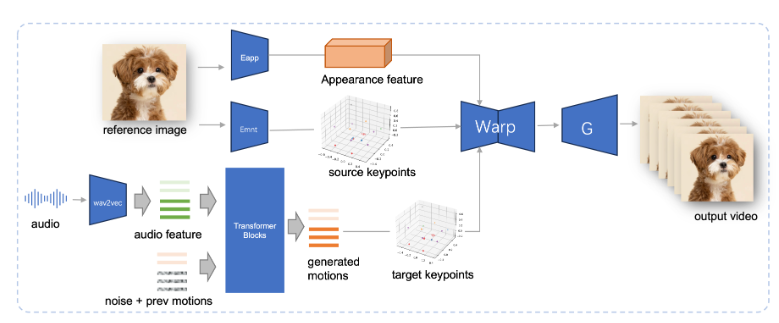

JoyVASA verwendet ein zweistufiges Design. Die erste Stufe führt ein entkoppeltes Gesichtsdarstellungsgerüst ein, um dynamische Gesichtsausdrücke von statischen dreidimensionalen Gesichtsdarstellungen zu trennen.

Durch diese Trennung kann das System jedes statische 3D-Gesichtsmodell mit dynamischen Aktionssequenzen kombinieren, um längere animierte Videos zu erstellen. In der zweiten Phase trainierte das Forschungsteam einen Diffusionstransformator, der Aktionssequenzen direkt aus Audio-Hinweisen generieren kann, ein Prozess, der unabhängig von der Charakteridentität ist. Schließlich verwendet der auf dem Training der ersten Stufe basierende Generator die 3D-Gesichtsdarstellung und die generierte Aktionssequenz als Eingabe, um hochwertige Animationseffekte zu rendern.

Insbesondere ist JoyVASA nicht auf die Animation menschlicher Porträts beschränkt, sondern kann auch Tiergesichter nahtlos animieren. Dieses Modell wird anhand eines gemischten Datensatzes trainiert, der private chinesische Daten und öffentliche englische Daten kombiniert und gute Funktionen zur Unterstützung mehrerer Sprachen aufweist. Die experimentellen Ergebnisse belegen die Wirksamkeit dieser Methode. Zukünftige Forschung wird sich auf die Verbesserung der Echtzeitleistung und die Verfeinerung der Ausdruckskontrolle konzentrieren, um die Anwendung dieses Frameworks in der Bildanimation weiter zu erweitern.

Die Entstehung von JoyVASA markiert einen wichtigen Durchbruch in der audiogesteuerten Animationstechnologie und eröffnet neue Möglichkeiten im Bereich Animation.

Projekteingang: https://jdh-algo.github.io/JoyVASA/

Highlight:

Die JoyVASA-Technologie ermöglicht die Erstellung längerer animierter Videos durch die Entkopplung von Gesichtsausdrücken aus 3D-Modellen.

Diese Technologie kann Aktionssequenzen basierend auf Audiohinweisen generieren und verfügt über die doppelte Fähigkeit, Charakter- und Tieranimationen durchzuführen.

JoyVASA ist auf chinesische und englische Datensätze geschult, verfügt über mehrsprachige Unterstützung und bietet Dienstleistungen für Benutzer auf der ganzen Welt an.

Die Innovation der JoyVASA-Technologie liegt in ihrem entkoppelten Design und der effizienten Nutzung von Audio-Hinweisen, was eine neue Richtung für die zukünftige Entwicklung der audiogesteuerten Bildanimationstechnologie vorgibt. Dank der Unterstützung mehrerer Sprachen und der effizienten Animationsgenerierungsfunktionen ist sie außerdem weit verbreitet Aussichten. Es wird erwartet, dass JoyVASA in Zukunft die Echtzeitleistung weiter verbessern und eine ausgefeiltere Ausdruckssteuerung erreichen kann.