Das Forschungsteam der University of Washington hat ein neues visuelles Tracking-Modell SAMURAI auf den Markt gebracht, das auf SAM2 basiert und darauf abzielt, die Herausforderungen der visuellen Verfolgung in komplexen Szenen zu meistern, insbesondere die Verfolgung sich schnell bewegender und sich selbst verdeckender Objekte. SAMURAI verbessert die Vorhersagefähigkeit von Objektbewegungen und die Genauigkeit der Maskenauswahl erheblich, indem es zeitliche Bewegungshinweise und bewegungsbewusste Speicherauswahlmechanismen einführt, wodurch eine robuste und genaue Verfolgung ohne Umschulung erreicht wird und eine gute Leistung bei mehreren Benchmark-Datensätzen erzielt wird.

Kürzlich hat ein Forschungsteam der University of Washington ein neues visuelles Tracking-Modell namens SAMURAI veröffentlicht. Dieses Modell basiert auf dem Segment Anything Model2 (SAM2) und soll die Herausforderungen lösen, die bei der visuellen Objektverfolgung in komplexen Szenen auftreten, insbesondere beim Umgang mit sich schnell bewegenden und sich selbst verdeckenden Objekten.

SAM2 schneidet bei Objektsegmentierungsaufgaben gut ab, weist jedoch einige Einschränkungen bei der visuellen Verfolgung auf. Beispielsweise berücksichtigt die Festfensterspeicherung in überfüllten Szenen nicht die Qualität des ausgewählten Speichers, was dazu führen kann, dass sich Fehler in der gesamten Videosequenz ausbreiten.

Um dieses Problem zu lösen, schlug das Forschungsteam SAMURAI vor, das die Vorhersagefähigkeit von Objektbewegungen und die Genauigkeit der Maskenauswahl erheblich verbessert, indem es zeitliche Bewegungshinweise und einen Mechanismus zur Auswahl des Bewegungswahrnehmungsgedächtnisses einführt. Diese Innovation ermöglicht es SAMURAI, eine robuste und genaue Verfolgung zu erreichen, ohne dass eine Umschulung oder Feinabstimmung erforderlich ist.

Im Hinblick auf den Echtzeitbetrieb zeigte SAMURAI eine starke Zero-Shot-Leistung, was bedeutet, dass das Modell immer noch eine gute Leistung erbringen kann, ohne auf einen bestimmten Datensatz trainiert zu werden.

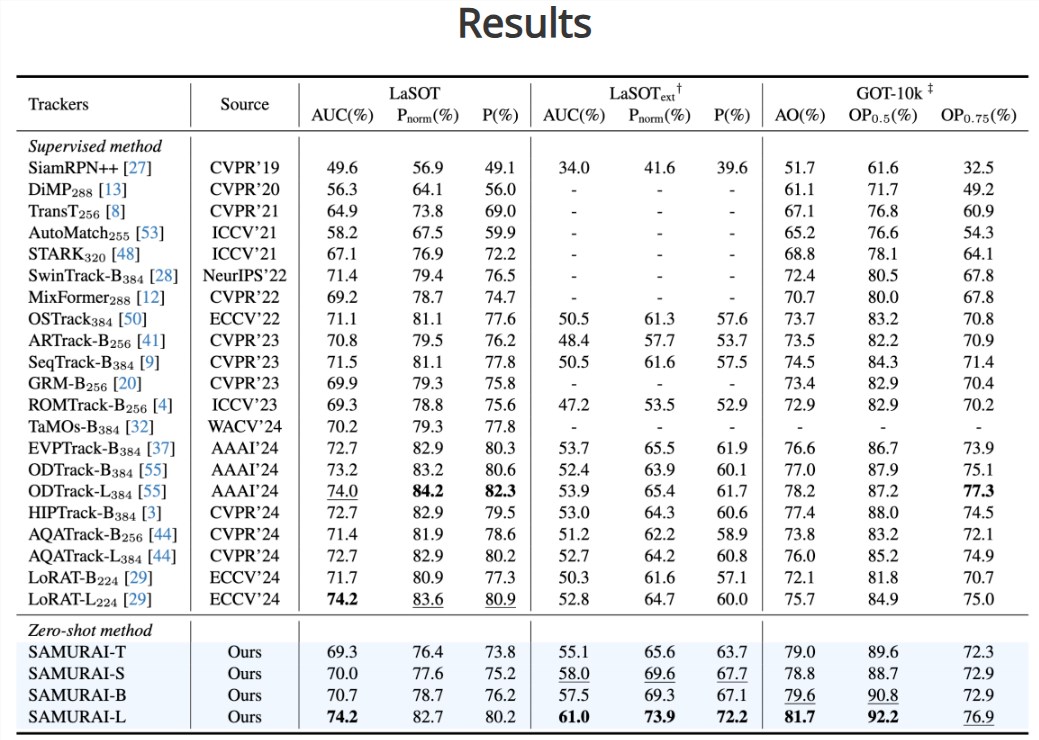

Durch die Auswertung stellte das Forschungsteam fest, dass die Erfolgsquote und Genauigkeit von SAMURAI bei mehreren Benchmark-Datensätzen deutlich verbessert wurde. Beim LaSOT-ext-Datensatz erreichte SAMURAI eine AUC-Steigerung von 7,1 %, während es beim GOT-10k-Datensatz eine AO-Steigerung von 3,5 % erreichte. Darüber hinaus schneidet SAMURAI im Vergleich zu vollständig überwachten Methoden beim LaSOT-Datensatz ebenso konkurrenzfähig ab und demonstriert seine Robustheit und sein breites Anwendungspotenzial in komplexen Tracking-Szenarien.

Das Forschungsteam stellte fest, dass der Erfolg von SAMURAI den Grundstein für die zukünftige Anwendung der visuellen Tracking-Technologie in komplexeren und dynamischeren Umgebungen legt. Sie hoffen, dass diese Innovation die Entwicklung des Bereichs der visuellen Verfolgung vorantreiben, den Anforderungen von Echtzeitanwendungen gerecht werden und stärkere visuelle Erkennungsfähigkeiten für verschiedene intelligente Geräte bereitstellen kann.

Projekteingang: https://yangchris11.github.io/samurai/

Highlight:

SAMURAI ist eine innovative Verbesserung des SAM2-Modells mit dem Ziel, die visuelle Objektverfolgung in komplexen Szenen zu verbessern.

Durch die Einführung eines bewegungsbewussten Speichermechanismus ist SAMURAI in der Lage, Objektbewegungen genau vorherzusagen, die Maskenauswahl zu optimieren und so eine Fehlerausbreitung zu vermeiden.

Bei mehreren Benchmark-Datensätzen zeigt SAMURAI eine starke Null-Schuss-Leistung, was die Erfolgsquote und Genauigkeit der Verfolgung erheblich verbessert.

Das Aufkommen des SAMURAI-Modells stellt einen bedeutenden Fortschritt in der visuellen Tracking-Technologie dar. Seine hohe Genauigkeit und Robustheit in komplexen Szenen unterstützen die Verbesserung der visuellen Erkennungsfähigkeiten zukünftiger intelligenter Geräte. Es lohnt sich, auf seinen Einsatz in weiteren Bereichen zu blicken .