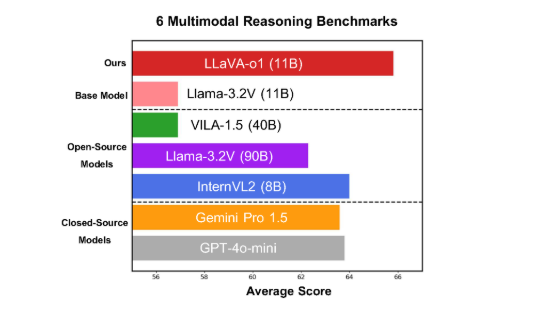

Die Universität Peking und andere wissenschaftliche Forschungsteams haben kürzlich das multimodale Open-Source-Modell LLaVA-o1 veröffentlicht. Dieses Modell zeigt erhebliche Vorteile im Bereich des multimodalen Denkens und gilt als das erste visuelle Sprachmodell, das spontanes und systematisches Denken ermöglicht Leistung vergleichbar mit GPT-o1. LLaVA-o1 verwendet einen Argumentationsmechanismus für „langsames Denken“, um den Argumentationsprozess in vier Phasen zu zerlegen: Zusammenfassung, visuelle Erklärung, logisches Denken und Schlussfolgerungsgenerierung, wodurch Fehler effektiv vermieden werden, die durch die Vereinfachung des traditionellen Modellargumentationsprozesses verursacht werden. Das Modell übertraf viele Konkurrenten bei sechs anspruchsvollen Benchmarks und übertraf Vergleiche mit größeren oder Closed-Source-Modellen, wobei seine 11B-Parameter-Version herausragte.

Kürzlich gaben die Universität Peking und andere wissenschaftliche Forschungsteams die Veröffentlichung eines multimodalen Open-Source-Modells namens LLaVA-o1 bekannt, das angeblich das erste visuelle Sprachmodell ist, das zu spontanem und systematischem Denken fähig ist, vergleichbar mit GPT-o1.

Das Modell schneidet bei sechs anspruchsvollen multimodalen Benchmarks gut ab, wobei seine 11B-Parameter-Version andere Konkurrenten wie Gemini-1.5-pro, GPT-4o-mini und Llama-3.2-90B-Vision-Instruct übertrifft.

LLaVA-o1 basiert auf dem Llama-3.2-Vision-Modell und verwendet einen Denkmechanismus für „langsames Denken“, der komplexere Denkprozesse selbstständig durchführen kann und damit die traditionelle Denkketten-Eingabeaufforderungsmethode übertrifft.

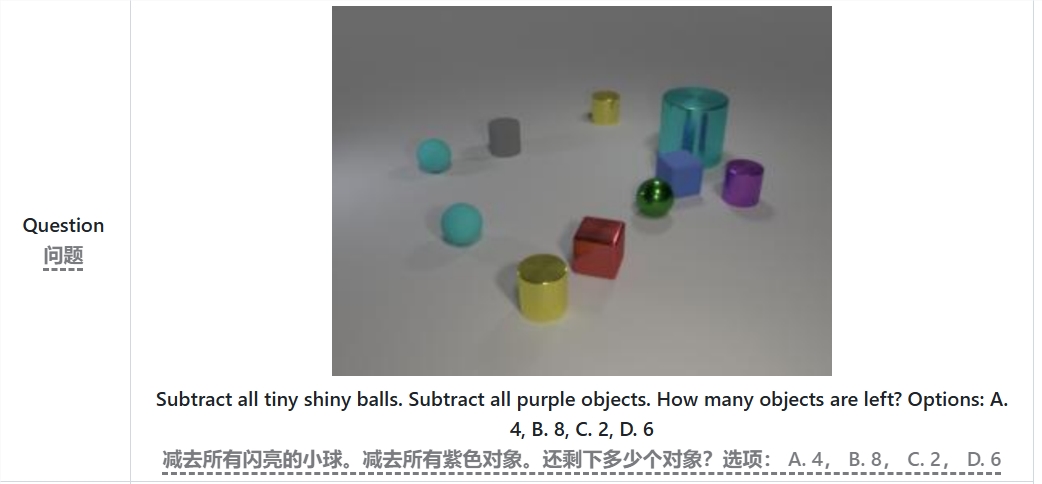

Beim multimodalen Inferenz-Benchmark übertraf LLaVA-o1 sein Basismodell um 8,9 %. Das Besondere an dem Modell ist, dass sein Argumentationsprozess in vier Phasen unterteilt ist: Zusammenfassung, visuelle Erklärung, logisches Denken und Generierung von Schlussfolgerungen. In traditionellen Modellen ist der Argumentationsprozess oft relativ einfach und kann leicht zu falschen Antworten führen, während LLaVA-o1 durch strukturierte mehrstufige Argumentation eine genauere Ausgabe gewährleistet.

Wenn Sie beispielsweise das Problem „Wie viele Objekte bleiben nach Abzug aller kleinen hellen Kugeln und violetten Objekte übrig?“ lösen, fasst LLaVA-o1 zunächst das Problem zusammen, extrahiert dann Informationen aus dem Bild und führt dann eine schrittweise Argumentation durch , und geben Sie schließlich Antwort. Dieser abgestufte Ansatz verbessert die systematischen Argumentationsfähigkeiten des Modells und macht es effizienter bei der Bearbeitung komplexer Probleme.

Es ist erwähnenswert, dass LLaVA-o1 im Inferenzprozess eine Strahlsuchmethode auf Bühnenebene einführt. Dieser Ansatz ermöglicht es dem Modell, in jeder Inferenzphase mehrere Kandidatenantworten zu generieren und die beste Antwort auszuwählen, um mit der nächsten Inferenzphase fortzufahren, wodurch die Gesamtqualität der Inferenz erheblich verbessert wird. Mit überwachter Feinabstimmung und angemessenen Trainingsdaten schneidet LLaVA-o1 im Vergleich mit größeren oder Closed-Source-Modellen gut ab.

Die Forschungsergebnisse des Teams der Peking-Universität fördern nicht nur die Entwicklung multimodaler KI, sondern liefern auch neue Ideen und Methoden für zukünftige Modelle des visuellen Sprachverständnisses. Das Team erklärte, dass der Code, die Pre-Training-Gewichte und die Datensätze von LLaVA-o1 vollständig Open Source sein werden, und sie freuen sich darauf, dass weitere Forscher und Entwickler dieses innovative Modell gemeinsam erforschen und anwenden.

Papier: https://arxiv.org/abs/2411.10440

GitHub: https://github.com/PKU-YuanGroup/LLaVA-o1

Highlight:

LLaVA-o1 ist ein neues multimodales Argumentationsmodell, das von der Peking-Universität und anderen Teams veröffentlicht wurde und über die Fähigkeit zum „langsamen Denken“ verfügt.

Das Modell übertrifft das Basismodell im multimodalen Inferenz-Benchmark-Test um 8,9 %.

LLaVA-o1 gewährleistet Genauigkeit durch strukturiertes mehrstufiges Denken und wird in naher Zukunft als Open Source verfügbar sein.

Die Open Source von LLaVA-o1 wird die Forschung und Entwicklung im Bereich der multimodalen KI fördern und eine solide Grundlage für die Konstruktion intelligenterer und leistungsfähigerer visueller Sprachmodelle bieten. Wir freuen uns darauf, in zukünftigen Anwendungen mehr Potenzial dieses Modells zu sehen. Die bereitgestellten Artikel und GitHub-Links erleichtern Forschern das Verständnis und die umfassende Nutzung des Modells.