Die Kosten für die Reduzierung der Schulungskosten großer Modelle sind der aktuelle Forschungs -Hotspot im Bereich der künstlichen Intelligenz. Die jüngsten Forschungen, die vom Tencent Mixed Yuan -Team veröffentlicht wurden, hat die Gesetze des Ausmaßes der quantitativen Ausbildung mit niedrigem Raten tief erörtert, das neue Ideen für Schulungsmodelle mit hoher Effizienz bietet. Die Studie analysierte die Auswirkungen der Modellgröße, der Trainingsdaten, der quantitativen Genauigkeit und anderer Faktoren auf die Trainingseffekte durch eine große Anzahl von Experimenten und erhielt schließlich das Gesetz, wie Trainingsressourcen effektiv zugewiesen werden können, um die beste Wirkung unter unterschiedlicher Genauigkeit zu erzielen. Diese Forschung hat nicht nur eine wichtige theoretische Bedeutung, sondern bietet auch wertvolle Anleitungen für die tatsächliche Anwendung großer Modelle.

Die schnelle Entwicklung des Großsprachmodells (LLM), die Kosten für die Ausbildung und das Denken von Modellen, werden heute zunehmend zum Schwerpunkt von Forschung und Anwendung. Kürzlich veröffentlichte das Tencent Mixed Yuan -Team eine wichtige Studie, in der die "Skalierungsgesetze" der quantitativen Ausbildung mit niedrigem Niveau das Skala -Gesetz der Ausbildung des schwimmenden Punktes quantitatives quantitativer Training zutiefst diskutierte. Der Kern dieser Studie besteht darin, die Berechnungs- und Speicherkosten zu senken, indem die Genauigkeit des Modells verringert und die Leistung nicht verliert.

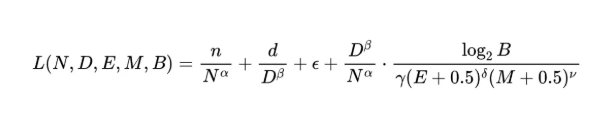

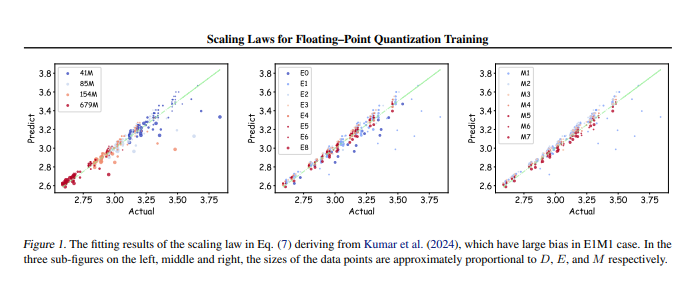

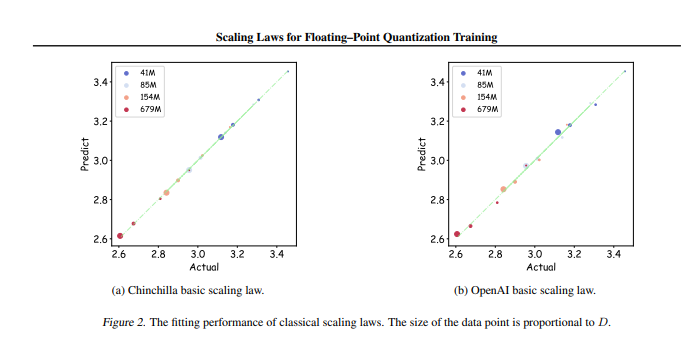

Das Forschungsteam führte bis zu 366 Sätze des schwimmenden Punktes quantitatives Training verschiedener Parameter und Genauigkeit durch. ), das Indexbit (e) ,,,,,,, Größe (b). In diesen Experimenten haben Forscher ein einheitliches Skalierungsgesetz erhalten, in dem er auftritt, wie Trainingsdaten und Modellparameter unter unterschiedlicher Genauigkeit effektiv konfiguriert werden können, um die besten Trainingsergebnisse zu erzielen.

Das Wichtigste ist, dass die Forschung darauf hinweist, dass in jedem quantitativen Training mit niedrigem punktuellem Punkt einen "Grenzwirkung" vorhanden ist, dh unter einer bestimmten Datenmenge wird die Leistung des Modells den optimalen Rückgang erreichen . Darüber hinaus ergab die Studie auch, dass die theoretisch die am besten gekostete schwebende Quantitative Trainingsgenauigkeit zwischen 4 und 8 Bissen betragen sollte, was eine wichtige Leit von Bedeutung für das effiziente LLM hat.

Diese Studie füllt nicht nur die Lücke im Bereich des schwebenden Punktes quantitatives Training, sondern bietet auch Referenz für zukünftige Hardwarehersteller, damit sie die Floating -Point -Computerfunktionen bei unterschiedlicher Genauigkeit optimieren können. Letztendlich bietet diese Forschung eine klare Richtung für die Praxis eines großen Modelltrainings, um sicherzustellen, dass sie bei begrenzten Ressourcen weiterhin effiziente Trainingseffekte erzielen kann.

Diplomadresse: https: //arxiv.org/pdf/2501.02423

Kurz gesagt, diese Studie des Tencent Hybrid -Teams lieferte eine wirksame Lösung für die Reduzierung der Kosten großer Schulungsmodelle. Diese Arbeit wies auf die Richtung des Modells mit hohem Effizienz und niedrigem Kostentraining hin, und es ist der Aufmerksamkeit und der Forschungsergebnis wert.