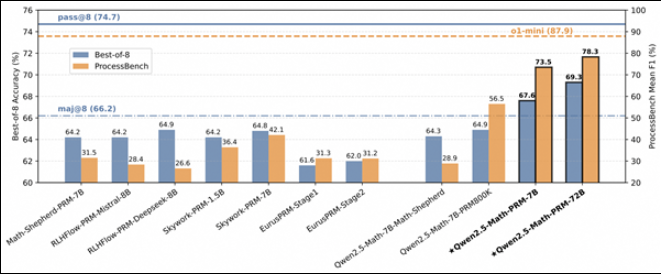

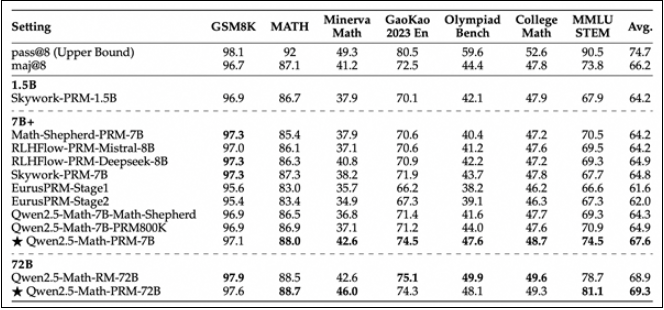

Das Alibaba Cloud Tongyi-Team führt ein neues mathematisches Belohnungsmodell Qwen2.5-Math-PRM ein. Dieses Modell ist in den Größen 72B und 7B erhältlich. Es übertrifft ähnliche Open-Source-Modelle deutlich, insbesondere bei der Identifizierung von Argumentationsfehlern. Es ist erwähnenswert, dass Version 7B sogar das beliebte GPT-4o übertraf, was den bahnbrechenden Fortschritt von Alibaba Cloud im Bereich der Forschung und Entwicklung von Inferenzmodellen demonstriert. Um die Modellleistung umfassender zu bewerten, hat das Team auch den ersten Bewertungsstandard ProcessBench auf Stufenebene als Open-Source-Lösung bereitgestellt, der 3.400 mathematische Fragen zum Schwierigkeitsgrad der Mathematikolympiade enthält und mit detaillierten Argumentationsprozessen von Experten versehen ist, um die Wissenschaftlichkeit sicherzustellen und Genauigkeit der Bewertung.

Heute hat das Alibaba Cloud Tongyi-Team offiziell ein neues Belohnungsmodell für den mathematischen Argumentationsprozess Qwen2.5-Math-PRM veröffentlicht. Das Modell ist in zwei Größen erhältlich: 72B und 7B, und seine Leistung ist deutlich besser als ähnliche Open-Source-Prozessbelohnungsmodelle, insbesondere bei der Identifizierung von Inferenzfehlern.

Die 7B-Version von Qwen2.5-Math-PRM übertraf überraschenderweise das in der Branche beliebte GPT-4o. Dieser Erfolg markiert einen wichtigen Schritt für Alibaba Cloud bei der Entwicklung von Inferenzmodellen. Um die Leistung des Modells beim mathematischen Denken umfassend zu bewerten, hat das Tongyi-Team auch den ersten Bewertungsstandard auf Schrittebene – ProcessBench – als Open-Source-Lösung bereitgestellt. Dieser Bewertungsstandard umfasst 3.400 mathematische Problemtestfälle, einschließlich schwieriger Fragen aus dem Wettbewerb der Internationalen Mathematikolympiade. Jeder Fall wird durch einen detaillierten Begründungsprozess von menschlichen Experten gekennzeichnet, um die Wissenschaftlichkeit und Vollständigkeit der Bewertung sicherzustellen.

Durch die Bewertung der Leistung von Qwen2.5-Math-PRM auf ProcessBench stellte das Forschungsteam fest, dass sowohl die Modelle der Größen 72B als auch 7B eine gute Leistung erbrachten. Insbesondere die 7B-Version übertrifft nicht nur das Open-Source-Modell gleicher Größe, sondern in einigen Aspekten sogar das Closed-Source-Modell GPT-4o-0806. Dies zeigt das große Potenzial des Prozessbelohnungsmodells (PRM) zur Verbesserung der Inferenzzuverlässigkeit und liefert neue Ideen für die Entwicklung zukünftiger Inferenzprozessüberwachungstechnologie.

Diese innovative Arbeit des Alibaba Cloud Tongyi-Teams fördert nicht nur die Weiterentwicklung der Argumentationstechnologie für künstliche Intelligenz, sondern bietet auch wertvolle Referenzen für andere Entwickler in der Branche. Durch Open Source hofft das Tongyi-Team, Erfahrungen mit mehr Forschern zu teilen und den technologischen Fortschritt in der gesamten Branche voranzutreiben.

Die Veröffentlichung von Qwen2.5-Math-PRM stellt einen neuen Durchbruch für große Modelle im Bereich des mathematischen Denkens dar. Seine Open-Source-Funktion bietet auch großen Komfort für Forschung und Anwendung in Wissenschaft und Industrie Mehr Möglichkeiten in der zukünftigen Entwicklung künstlicher Intelligenz.