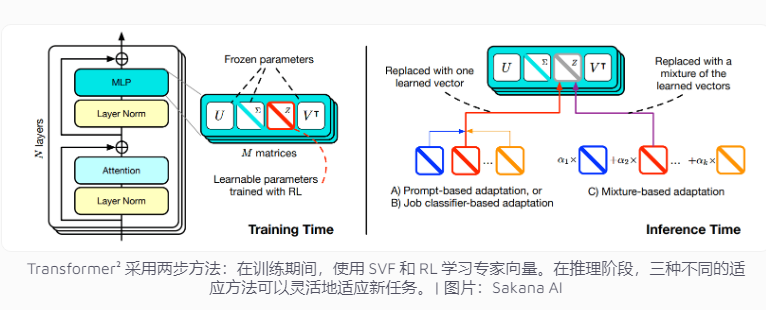

Das japanische Unternehmen Sakana AI hat kürzlich Transformer² veröffentlicht, eine innovative Technologie, die die Anpassungsfähigkeit von Sprachmodellaufgaben verbessern soll. Im Gegensatz zu herkömmlichen KI-Systemen, die mehrere Aufgaben gleichzeitig verarbeiten müssen, nutzt Transformer² zweistufiges Lernen unter Verwendung von Expertenvektoren und SVF-Technologie (Singular Value Fine Tuning), sodass es sich effizient an neue Aufgaben anpassen kann, ohne das gesamte Netzwerk wesentlich neu zu trainieren Dies reduziert den Ressourcenverbrauch erheblich und verbessert die Flexibilität und Genauigkeit des Modells. Diese Technologie konzentriert sich auf spezifische Aufgaben wie mathematische Operationen, Programmierung und logisches Denken, indem sie Expertenvektoren lernt, die die Bedeutung von Netzwerkverbindungen steuern, und verstärktes Lernen kombiniert, um die Modellleistung weiter zu optimieren.

Aktuelle Systeme der künstlichen Intelligenz müssen in der Regel mehrere Aufgaben in einem Training bewältigen. Allerdings stoßen sie bei der Bewältigung neuer Aufgaben häufig auf unerwartete Herausforderungen, was zu einer begrenzten Anpassungsfähigkeit des Modells führt. Das Designkonzept von Transformer² zielt auf dieses Problem ab und nutzt Experten-Vektor- und Singular-Value-Fine-Tuning-Technologie (SVF), um dem Modell die flexible Bewältigung neuer Aufgaben zu ermöglichen, ohne das gesamte Netzwerk neu zu trainieren.

Herkömmliche Trainingsmethoden erfordern die Anpassung der Gewichte des gesamten neuronalen Netzwerks, was nicht nur kostspielig ist, sondern auch dazu führen kann, dass das Modell zuvor erlerntes Wissen „vergisst“. Im Gegensatz dazu vermeiden SVF-Techniken diese Probleme, indem sie Expertenvektoren lernen, die die Wichtigkeit jeder Netzwerkverbindung steuern. Expertenvektoren helfen dem Modell, sich auf bestimmte Aufgaben wie mathematische Operationen, Programmierung und logisches Denken zu konzentrieren, indem sie die Gewichtsmatrix von Netzwerkverbindungen anpassen.

Dieser Ansatz reduziert die Anzahl der Parameter, die zur Anpassung des Modells an neue Aufgaben erforderlich sind, erheblich. Beispielsweise erfordert die LoRA-Methode 6,82 Millionen Parameter, während SVF nur 160.000 Parameter benötigt. Dies reduziert nicht nur den Speicher- und Rechenleistungsverbrauch, sondern verhindert auch, dass das Modell anderes Wissen vergisst, während es sich auf eine bestimmte Aufgabe konzentriert. Am wichtigsten ist, dass diese Expertenvektoren effektiv zusammenarbeiten können, um die Anpassungsfähigkeit des Modells an verschiedene Aufgaben zu verbessern.

Um die Anpassungsfähigkeit weiter zu verbessern, führt Transformer² Reinforcement Learning ein. Während des Trainingsprozesses optimiert das Modell kontinuierlich Expertenvektoren, indem es Aufgabenlösungen vorschlägt und Feedback einholt, wodurch die Leistung bei neuen Aufgaben verbessert wird. Das Team entwickelte drei Strategien, um dieses Expertenwissen zu nutzen: adaptive Hinweise, Aufgabenklassifikatoren und Wenig-Schuss-Anpassung. Insbesondere die adaptive Strategie mit wenigen Schüssen verbessert die Flexibilität und Genauigkeit des Modells weiter, indem Beispiele neuer Aufgaben analysiert und Expertenvektoren angepasst werden.

Transformer² übertrifft die traditionelle LoRA-Methode in mehreren Benchmarks. Bei mathematischen Aufgaben stieg die Leistung um 16 %, und die erforderlichen Parameter wurden deutlich reduziert. Bei einer neuen Aufgabe war die Genauigkeit von Transformer² 4 % höher als beim Originalmodell, während LoRA nicht die erwarteten Ergebnisse erzielte.

Transformer² löst nicht nur komplexe mathematische Probleme, sondern kombiniert auch Programmier- und logische Denkfähigkeiten, um einen domänenübergreifenden Wissensaustausch zu erreichen. Das Team entdeckte beispielsweise, dass auch kleinere Modelle die Leistung verbessern können, indem sie das Wissen größerer Modelle durch die Übertragung von Expertenvektoren nutzen, was neue Möglichkeiten für den Wissensaustausch zwischen Modellen bietet.

Obwohl Transformer² erhebliche Fortschritte bei der Anpassungsfähigkeit an Aufgaben gemacht hat, weist es immer noch einige Einschränkungen auf. Derzeit können mit SVF trainierte Expertenvektoren nur auf die vorhandenen Fähigkeiten im vorab trainierten Modell zurückgreifen und keine völlig neuen Fähigkeiten hinzufügen. Echtes kontinuierliches Lernen bedeutet, dass das Modell selbstständig neue Fähigkeiten erlernen kann. Dieses Ziel braucht noch Zeit, um es zu erreichen. Wie sich diese Technik auf große Modelle mit mehr als 70 Milliarden Parametern skalieren lässt, bleibt eine offene Frage.

Insgesamt zeigt Transformer² großes Potenzial im Bereich des kontinuierlichen Lernens und bietet durch seine effiziente Ressourcennutzung und deutliche Leistungssteigerung eine neue Richtung für die Entwicklung zukünftiger Sprachmodelle. Allerdings muss die Technologie weiterhin kontinuierlich verbessert werden, um bestehende Einschränkungen zu überwinden und echte kontinuierliche Lernziele zu erreichen.