Das Verständnis langer Videos war schon immer eine große Herausforderung im Bereich der Videoanalyse. Herkömmliche Modelle sind bei der Verarbeitung langer Videos ineffizient und es ist schwierig, wichtige Informationen effektiv zu extrahieren. In diesem Artikel werden eine hierarchische Video-Markup-Komprimierungstechnologie namens HiCo und das auf dieser Technologie basierende „VideoChat-Flash“-System vorgestellt, das die „Nadel im Heuhaufen“-Aufgabe durch mehrstufiges Lernen und verbesserte Fähigkeiten zum Verstehen langer Videos erheblich verbessert und erheblich reduziert Rechenanforderungen. Das Forschungsteam erstellte einen großen Datensatz mit 300.000 Stunden Video und 200 Millionen Wörtern an Anmerkungen für das Modelltraining und die Bewertung.

Insbesondere reduziert HiCo die Rechenkomplexität, indem lange Videos in kurze Segmente segmentiert und redundante Informationen komprimiert werden, während gleichzeitig semantische Assoziationen mit Benutzerabfragen genutzt werden, um die Anzahl der verarbeiteten Tags weiter zu reduzieren. „VideoChat-Flash“ verwendet ein mehrstufiges Lernschema, bei dem zunächst kurze Videos zur überwachten Feinabstimmung verwendet werden, dann nach und nach lange Videoschulungen eingeführt werden und schließlich ein umfassendes Verständnis des Korpus gemischter Länge erreicht wird. Darüber hinaus verbessert die verbesserte „Nadel im Heuhaufen“-Aufgabe das Verständnis des Modells für Kontext und Multi-Hop-Videokonfigurationen.

Bei der spezifischen Implementierung der Verarbeitung langer Videos wendet „VideoChat-Flash“ ein mehrstufiges Lernschema von kurzen Videos zu langen Videos an. Die Forscher verwendeten zunächst kurze Videos und die entsprechenden Anmerkungen für die überwachte Feinabstimmung und führten dann nach und nach lange Videos für das Training ein, um schließlich ein umfassendes Verständnis des Korpus gemischter Länge zu erreichen. Diese Methode verbessert nicht nur die visuelle Wahrnehmungsfähigkeit des Modells, sondern bietet auch umfassende Datenunterstützung für die Verarbeitung langer Videos. Das Forschungsteam erstellte einen riesigen Datensatz mit 300.000 Stunden Video und 200 Millionen Wörtern an Anmerkungen.

Darüber hinaus wird in der Studie eine verbesserte „Nadel im Heuhaufen“-Aufgabe für Multi-Hop-Videokonfigurationen vorgeschlagen. Mit dem neuen Benchmark muss das Modell nicht nur ein einzelnes Zielbild im Video finden, sondern auch mehrere miteinander verbundene Bildsequenzen verstehen und so die Fähigkeit des Modells verbessern, den Kontext zu verstehen.

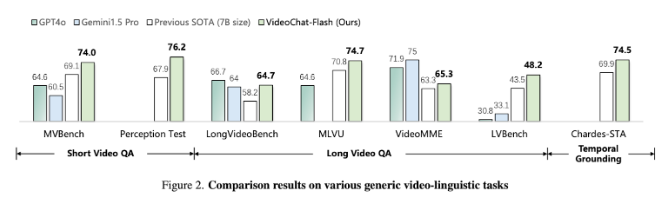

Experimentelle Ergebnisse zeigen, dass die vorgeschlagene Methode den Rechenaufwand um zwei Größenordnungen reduziert, insbesondere bei Benchmark-Tests von kurzen und langen Videos gut abschneidet und sich zu einem Spitzenreiter im neuen Bereich des Kurzvideoverständnisses entwickelt. Gleichzeitig übertrifft dieses Modell auch bestehende Open-Source-Modelle im Hinblick auf das Verständnis langer Videos und zeigt starke Zeitpositionierungsfunktionen.

Papier: https://arxiv.org/abs/2501.00574

Highlight:

Die Forscher schlugen die hierarchische Video-Tag-Komprimierungstechnologie HiCo vor, die den Rechenaufwand für die lange Videoverarbeitung erheblich reduziert.

Das „VideoChat-Flash“-System verwendet eine mehrstufige Lernmethode und kombiniert kurze und lange Videos für das Training, was die Verständnisfähigkeit des Modells verbessert.

Experimentelle Ergebnisse zeigen, dass diese Methode in mehreren Benchmark-Tests neue Leistungsstandards erreicht und sich zu einem fortschrittlichen Modell im Bereich der langen Videoverarbeitung entwickelt.

Alles in allem bietet diese Forschung eine neue Lösung für das effiziente Verständnis langer Videos und das VideoChat-Flash-System. Sie haben bedeutende Durchbrüche in der Recheneffizienz und Modellleistung erzielt und den Grundstein für zukünftige Anwendungen zur Analyse langer Videos gelegt. Die Forschungsergebnisse haben wichtige theoretische Bedeutung und praktischen Anwendungswert.