Die Generierung von Spielszenen war schon immer eine große Herausforderung im Bereich der Spieleentwicklung. Wie man die Beschränkungen bestehender Szenarien durchbrechen und eine vielfältigere und innovativere Spielwelt schaffen kann, ist eine Richtung, die Entwickler weiterhin erkunden. Kürzlich haben die Universität Hongkong und Kuaishou Technology gemeinsam ein innovatives Framework namens GameFactory entwickelt, das eine neue Idee zur Lösung dieses Problems liefert. Dieses Framework nutzt fortschrittliche Videodiffusionsmodelltechnologie in Kombination mit einer einzigartigen dreistufigen Trainingsstrategie, um neue und vielfältige Spielszenen zu generieren und so die Effizienz und Kreativität der Spielvideogenerierung erheblich zu verbessern.

Im Bereich der Spieleentwicklung war die Vielfalt und Innovation von Szenarien schon immer ein schwieriges Problem. Kürzlich haben die Universität Hongkong und Kuaishou Technology gemeinsam ein innovatives Framework namens GameFactory entwickelt, das darauf abzielt, das Problem der Szenengeneralisierung bei der Generierung von Spielvideos zu lösen. Dieses Framework nutzt vorab trainierte Videodiffusionsmodelle, die auf Open-Domain-Videodaten trainiert werden können, um neue und vielfältige Spielszenarien zu generieren.

Als fortschrittliche Generationstechnologie hat das Videodiffusionsmodell in den letzten Jahren großes Potenzial in den Bereichen Videogenerierung und physikalische Simulation gezeigt. Diese Modelle können wie Tools zur Videogenerierung auf Benutzereingaben wie Tastatur und Maus reagieren und dann entsprechende Spielszenen generieren. Allerdings bleibt die Szenenverallgemeinerung, die sich auf die Fähigkeit bezieht, völlig neue Spielszenarien über die bestehenden hinaus zu erstellen, in diesem Bereich weiterhin eine große Herausforderung. Obwohl das Sammeln einer großen Menge aktionskommentierter Videodatensätze eine direkte Möglichkeit zur Lösung dieses Problems darstellt, ist diese Methode zeitaufwändig und arbeitsintensiv, insbesondere in Open-Domain-Szenarien unpraktisch.

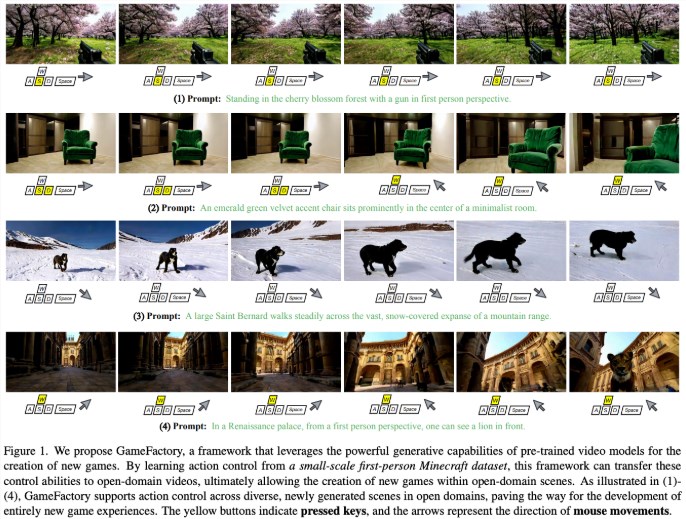

Um dieses Problem zu lösen, wurde das GameFactory-Framework ins Leben gerufen. Durch vorab trainierte Videodiffusionsmodelle ist GameFactory in der Lage, eine übermäßige Abhängigkeit von bestimmten Spieldatensätzen zu vermeiden und die Generierung verschiedener Spielszenarien zu unterstützen. Um die Lücke zwischen offenem Vorwissen und begrenzten Spieldatensätzen zu schließen, wendet GameFactory außerdem eine einzigartige dreistufige Trainingsstrategie an.

In der ersten Stufe wird LoRA (Low-Rank-Adaption) verwendet, um das vorab trainierte Modell zu verfeinern, um es an die spezifische Spieldomäne anzupassen und dabei die ursprünglichen Parameter beizubehalten. Die zweite Stufe friert die Parameter vor dem Training ein und konzentriert sich auf das Training des Bewegungssteuerungsmoduls, um Verwechslungen zwischen Stil und Steuerung zu vermeiden. Schließlich werden in der dritten Stufe die LoRA-Gewichte entfernt und die Parameter des Bewegungssteuerungsmoduls beibehalten, sodass das System kontrollierte Spielvideos in verschiedenen Open-Domain-Szenarien generieren kann.

Die Forscher bewerteten auch die Wirksamkeit verschiedener Kontrollmechanismen und stellten fest, dass der Kreuzaufmerksamkeitsmechanismus bei der Verarbeitung diskreter Steuersignale wie Tastatureingaben eine bessere Leistung erbrachte, während die Splicing-Methode bei der Verarbeitung von Mausbewegungssignalen eine bessere Leistung erbrachte. GameFactory unterstützt außerdem die autoregressive Bewegungssteuerung und ermöglicht so die Erstellung interaktiver Gameplay-Videos unbegrenzter Länge. Darüber hinaus veröffentlichte das Forschungsteam auch den hochwertigen Action-Annotation-Videodatensatz GF-Minecraft für das Training und die Evaluierung des Frameworks.

Papier: https://arxiv.org/abs/2501.08325

Highlight:

Das GameFactory-Framework wurde gemeinsam von der University of Hong Kong und Kuaishou Technology entwickelt, um das Problem der Szenengeneralisierung bei der Generierung von Spielvideos zu lösen.

Das Framework nutzt vorab trainierte Videodiffusionsmodelle, um verschiedene Spielszenarien zu generieren, und wendet eine dreistufige Trainingsstrategie an, um den Effekt zu verbessern.

Die Forscher veröffentlichten außerdem den Action-Annotation-Videodatensatz GF-Minecraft, um das Training und die Evaluierung von GameFactory zu unterstützen.

Das Aufkommen des GameFactory-Frameworks hat der Spieleentwicklung neue Möglichkeiten eröffnet. Seine effizienten Szenengenerierungsfunktionen und die Anpassungsfähigkeit an offene Domänen werden die Entwicklung der Spielebranche erheblich vorantreiben und den Spielern ein farbenfroheres Spielerlebnis bieten. Wir gehen davon aus, dass das GameFactory-Framework in Zukunft weiter verbessert wird, um Spieleentwicklern leistungsfähigere Tools zur Verfügung zu stellen.