Codestral 25.01, das neueste von Mistral veröffentlichte Open-Source-Codierungsmodell, hat erhebliche Leistungsverbesserungen erzielt und ist doppelt so schnell wie die vorherige Generation. Als aktualisierte Version von Codestral übernimmt Codestral 25.01 dessen niedrige Latenz- und Hochfrequenz-Betriebseigenschaften und ist für Anwendungen auf Unternehmensebene optimiert und unterstützt Aufgaben wie Codekorrektur, Testgenerierung und Zwischenbefüllung. Seine hervorragende Leistung im Python-Codierungstest, insbesondere die hohe Punktzahl von 86,6 % im HumanEval-Test, macht es zum Spitzenreiter unter den aktuellen schwergewichtigen Codierungsmodellen und übertrifft viele ähnliche Produkte.

Ähnlich wie der ursprüngliche Codestral konzentriert sich Codestral 25.01 weiterhin auf Operationen mit geringer Latenz und hoher Frequenz und unterstützt Codekorrektur, Testgenerierung und Zwischenfüllaufgaben. Mistral sagte, diese Version sei besonders für Unternehmen geeignet, die mehr Daten- und Modellresidenz benötigen. Benchmark-Tests zeigen, dass Codestral25.01 im Python-Codierungstest mit einem HumanEval-Testergebnis von 86,6 % die Erwartungen übertrifft und damit die Vorgängerversion Codellama70B Instruct und DeepSeek Coder33B Instruct weit übertrifft.

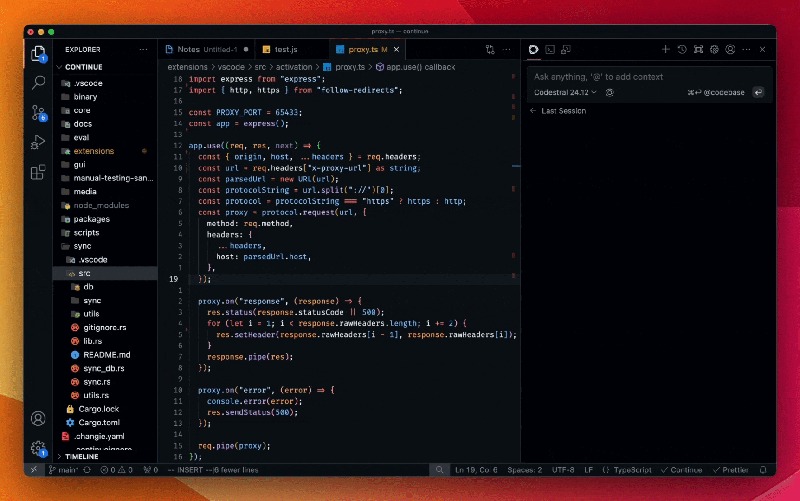

Entwickler können über das Mistral IDE-Plug-in sowie das lokale Bereitstellungstool Continue auf das Modell zugreifen. Darüber hinaus bietet Mistral auch Zugriff auf die API über Google Vertex AI und Mistral la Plateforme. Das Modell ist derzeit als Vorschau auf Azure AI Foundry verfügbar und wird bald auf der Amazon Bedrock-Plattform verfügbar sein.

Seit seiner Veröffentlichung im letzten Jahr hat sich Codestral by Mistral zu einem führenden Unternehmen im Code-fokussierten Open-Source-Modell entwickelt. Die erste Version von Codestral ist ein 22B-Parametermodell, das bis zu 80 Sprachen unterstützt und eine bessere Codierungsleistung als viele ähnliche Produkte bietet. Unmittelbar danach brachte Mistral Codestral-Mamba auf den Markt, ein auf der Mamba-Architektur basierendes Codegenerierungsmodell, das längere Codezeichenfolgen verarbeiten und mehr Eingabeanforderungen bewältigen kann.

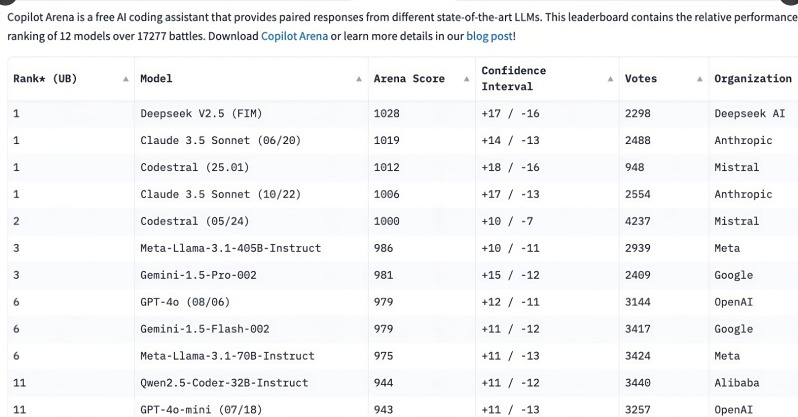

Die Veröffentlichung von Codestral 25.01 erregte große Aufmerksamkeit bei den Entwicklern und belegte bereits wenige Stunden nach der Veröffentlichung einen Spitzenplatz in der C o pilot Arena-Rangliste. Dieser Trend zeigt, dass spezialisierte Codierungsmodelle schnell zur ersten Wahl für Entwickler werden, insbesondere im Bereich der Codierungsaufgaben. Im Vergleich zu multifunktionalen allgemeinen Modellen wird der Bedarf an fokussierten Codierungsmodellen immer offensichtlicher.

Obwohl Allzweckmodelle wie o3 von OpenAI und Claude von Anthropic ebenfalls kodieren können, weisen speziell optimierte Kodierungsmodelle tendenziell eine bessere Leistung auf. Im vergangenen Jahr haben mehrere Unternehmen dedizierte Modelle für die Codierung herausgebracht, darunter Alibabas Qwen2.5-Coder und Chinas DeepSeek Coder, wobei letzterer das erste Modell war, das GPT-4Turbo übertraf. Darüber hinaus hat Microsoft auch GRIN-MoE auf den Markt gebracht, das auf dem Mix-of-Experts-Modell (MOE) basiert und nicht nur programmieren, sondern auch mathematische Probleme lösen kann.

Obwohl Entwickler immer noch darüber diskutieren, ob sie sich für Allzweckmodelle oder Spezialmodelle entscheiden sollen, hat der rasante Aufstieg von Codierungsmodellen gezeigt, dass ein enormer Bedarf an effizienten und genauen Codierungstools besteht. Mit dem Vorteil, speziell für Codierungsaufgaben geschult zu sein, nimmt Codestral25.01 zweifellos einen Platz in der Zukunft des Codierens ein.

Die Veröffentlichung von Codestral25.01 markiert einen weiteren Fortschritt im Bereich professioneller Codierungsmodelle. Seine überlegene Leistung und der bequeme Zugriff werden Entwicklern ein effizienteres Codierungserlebnis bieten und die Weiterentwicklung künstlicher Intelligenz im Bereich der Softwareentwicklung fördern. Wir freuen uns darauf, in Zukunft weitere ähnliche professionelle Modelle zu sehen, um Entwicklern mehr Auswahlmöglichkeiten zu bieten.