Sakana AI startet den innovativen adaptiven Sprachmodelltransformator², bei dem ein einzigartiger Mechanismus für zweistufige dynamische Gewichtsanpassungen verwendet wird, der während des Inferenzprozesses ohne teure Feinabstimmung dynamisch neue Aufgaben lernt und an sie anpasst. Dies markiert einen großen Durchbruch in der LLM -Technologie (Langual Language Model) und es wird erwartet, dass LLM angewendet wird, um sie effizienter, personalisierter und praktischer zu gestalten. Im Vergleich zu herkömmlichen Feinabstimmungsmethoden passt Transformator² die Schlüsselkomponenten von Modellgewichten selektiv durch Singularwert-Zersetzung (SVD) und Singularwert-Feinabstimmungstechniken (SVF) an, um die Leistung in Echtzeit zu optimieren und zeitaufwändige Umschulungen zu vermeiden. Testergebnisse zeigen, dass Transformator² dem LORA -Modell in mehreren Aufgaben mit weniger Parametern überlegen ist und auch starke Fähigkeiten zur Übertragung von Wissensübertragungen zeigt.

Die Kerninnovation von Transformator² liegt in seinem einzigartigen zweistufigen dynamischen Gewichtsmechanismus. Analysiert und versteht zunächst die Anforderungen an den Eingang von Benutzern. Durch die selektive Anpassung der Schlüsselkomponenten von Modellgewichten ermöglicht Transformator² die Echtzeitoptimierung der Leistung ohne zeitaufwändige Umschulung. Dies steht in scharfem Kontrast zur herkömmlichen Feinabstimmungsmethode, bei der die Parameter nach dem Training statisch bleiben müssen, oder mithilfe von Methoden wie Anpassung mit niedriger Rang (LORA), um nur eine kleine Anzahl von Parametern zu ändern.

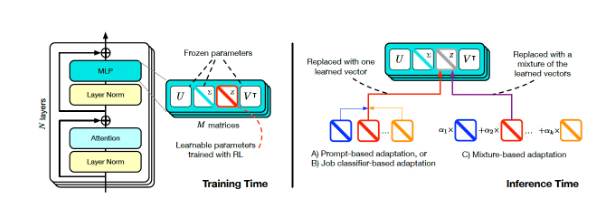

Transformator Square Training und Inferenz (Quelle: Arxiv)

Um eine dynamische Anpassung zu erreichen, übernahmen die Forscher die SVF -Methode (Singular Value Fine Tuning). Während des Trainings lernt SVF eine Reihe von Fähigkeiten, die als Z-Vektoren aus den SVD-Komponenten des Modells bezeichnet werden. Im Argumentieren bestimmt Transformator² die erforderlichen Fähigkeiten, indem sie die Eingabeaufforderungen analysieren und dann die entsprechenden Z-Vektoren konfigurieren, um eine Antwort zu erreichen, die auf jede Eingabeaufforderung zugeschnitten ist.

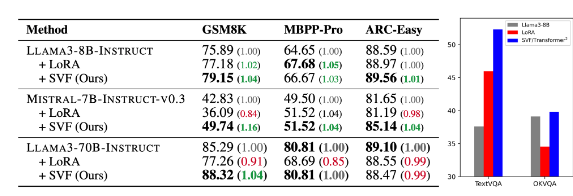

Testergebnisse zeigen, dass Transformator² dem LORA -Modell in verschiedenen Aufgaben wie Mathematik, Codierung, Argumentation und visueller Frage und Antwort überlegen ist und weniger Parameter aufweist. Bemerkenswerter ist, dass das Modell auch über die Wissensübertragungsfähigkeit verfügt, dh die von einem Modell gelernten Z-Vektoren können auf ein anderes angewendet werden, wodurch das Potenzial für eine weit verbreitete Anwendung demonstriert werden kann.

Vergleich von Transformator-Quadratmeter (SVF in Tabelle) mit dem zugrunde liegenden Modell und Lora (Quelle: Arxiv)

Sakana AI veröffentlichte Trainingscode für die Transformator² -Komponente auf ihrer Github -Seite und öffnete die Tür für andere Forscher und Entwickler.

Da Unternehmen weiterhin die Anwendung von LLM untersuchen, wird die Inferenzanpassungstechnologie allmählich zum Mainstream -Trend. Transformator² ändert zusammen mit anderen Technologien wie der Titanen von Google die Art und Weise, wie LLM verwendet wird, sodass Benutzer Modelle dynamisch an ihre spezifischen Anforderungen anpassen, ohne zurückzunehmen. Dieser technologische Fortschritt wird LLM in einer breiteren Reihe von Bereichen nützlicher und praktischer.

Forscher von Sakana AI sagten, Transformer² sei eine Brücke zwischen statischer künstlicher Intelligenz und Lebensinh intelligenz und bildet die Grundlage für effiziente, personalisierte und vollständig integrierte KI -Tools.

Die Open -Source -Veröffentlichung von Transformer² wird die Entwicklung und Anwendung der LLM -Technologie erheblich fördern und eine neue Richtung für den Aufbau effizienterer und personalisierterer künstlicher Intelligenzsysteme bieten. Seine Fähigkeit, dynamisch zu lernen und sich an neue Aufgaben anzupassen, lässt es in verschiedenen Bereichen ein großes Anwendungspotenzial haben und es ist es wert, sich auf die zukünftige Entwicklung zu freuen.