Das Allen Institute of Artificial Intelligence (AI2) hat kürzlich ein neues großes Sprachmodell Olmoe veröffentlicht, ein spärliches Hybrid-Expertenmodell (MOE) mit 7 Milliarden Parametern, aber jede Eingabemarke verwendet nur 1 Milliarde Parameter, wodurch die Anzahl der Schlussfolgerungen erheblich reduziert werden Kosten und Speicheranforderungen. Olmoe hat zwei Versionen: die universelle Version Olmoe-1b-7b und die Befehlsfeinversion Olmoe-1b-7b-Instruction, die nicht weniger als andere große Modelle in Benchmarks ausführt und sogar einige größere Modelle übertrifft. AI2 betont die vollständige Open Source von Olmoe, die im Bereich der MOE -Modelle besonders wertvoll ist und wertvolle Ressourcen für die akademische Forschung bereitstellt.

Olmoe nimmt eine Sparse Hybrid Expert (MOE) -Scharchitektur mit 7 Milliarden Parametern an, aber pro Eingabetag werden nur 1 Milliarde Parameter verwendet. Es kommt in zwei Versionen, die allgemeinere Olmoe-1b-7b und die olmoe-1b-7b-in-Struktur.

Im Gegensatz zu den meisten anderen hybriden Expertenmodellen, die geschlossen sind, betont AI2, dass Olmoe vollständig Open Source ist. Sie erwähnten in der Arbeit, dass "die meisten MOE-Modelle geschlossen sind: Obwohl einige Modellgewichte offenbar sind, gibt es äußerst begrenzte Informationen zu ihren Schulungsdaten, Code oder Rezepten."

Nathan Lambert, Forschungswissenschaftler von AI2, sagte in den sozialen Medien, dass Olmoe bei der Politikgestaltung helfen werde, was einen Ausgangspunkt für den Start des H100 -Clusters in der Wissenschaft bieten könnte. Er erwähnte auch, dass die Veröffentlichung des Olmoe -Modells Teil des Ziels von AI2 ist, Open -Source -Modelle zu entwickeln und seine Leistung mit geschlossenen Modellen vergleichbar zu machen.

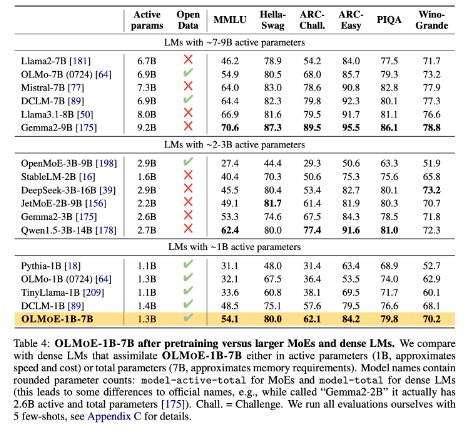

In Bezug auf das Modellgebäude beschloss AI2, 64 kleine Experten für das Geldbetrieb zu verwenden und nur acht von ihnen zur Laufzeit zu aktivieren. Experimente zeigen, dass Olmoe mit anderen Leistungsmodellen vergleichbar ist, die Inferenzkosten und Speicherspeicher erheblich reduziert. Olmoe baut vor AI2 auch auf dem Open-Source-Modell Olmo1.7-7b auf und unterstützt 4096-Tagged-Kontextfenster. Olmoe -Trainingsdaten stammen aus mehreren Quellen, einschließlich üblicher Crawl, Dolma CC, Wikipedia usw.

In der Benchmark übertrifft OLMOE-1B-7B im Vergleich zu Modellen mit ähnlichen Parametern viele vorhandene Modelle und übertrifft sogar größere Modelle wie LLAMA2-13B-CHAT und Deepseekmoe-16b.

Eines der Ziele von AI2 ist es, Forschern mit Open -Source -KI -Modellen, einschließlich hybriden Expertenarchitekturen, zu bieten. Obwohl viele Entwickler die Moe -Architektur verwenden, ist AI2 der Ansicht, dass die meisten anderen KI -Modelle weit davon entfernt sind, offen genug zu sein.

Huggingface: https://huggingface.co/Collections/ALLENAI/OLMOE-66CF678C047657A30C8CD3DA

Papiereingang: https://arxiv.org/abs/2409.02060

Schlüsselpunkte:

- Das neue Open -Source -Modell Olmoe, das von AI2 veröffentlicht wurde, ist in Bezug auf Leistung und Kosten wettbewerbsfähig.

- Olmoe nimmt eine spärliche Hybrid -Expertenarchitektur an, die die Inferenzkosten und Speicheranforderungen effektiv senken kann.

- AI2 ist bestrebt, ein vollständig Open -Source -KI -Modell bereitzustellen, das die akademische Forschung und Entwicklung fördert.

Kurz gesagt, die Open-Source-Veröffentlichung von Olmoe ist ein wesentlicher Fortschritt im Bereich großer Sprachmodelle. Der Umzug von AI2 spiegelt sein festes Engagement für die Entwicklung von Open Source AI wider und ist es wert, sich auf ähnliche Beiträge in der Zukunft zu freuen.