In den letzten Jahren sind die Schulungskosten großer Sprachmodelle hoch geblieben, was zu einem wichtigen Faktor geworden ist, der die Entwicklung von KI einschränkt. Wie man die Schulungskosten senkt und die Effizienz verbessert, ist der Schwerpunkt der Aufmerksamkeit der Branche geworden. Forscher der Harvard und der Stanford University haben einen anderen Ansatz verfolgt und mit der Modelltraininggenauigkeit begonnen, um eine kostengünstige Trainingsmethode zu untersuchen. Sie fanden heraus, dass durch die Reduzierung der Modellgenauigkeit die Berechnung in einigen Fällen effektiv reduziert und sogar die Modellleistung verbessert werden kann. Diese Studie bietet neue Ideen für die Optimierung des Sprachmodelltrainings und weist auch die Richtung für die zukünftige KI -Entwicklung hin.

Auf dem Gebiet der künstlichen Intelligenz ist die Fähigkeit, je größer die Skala ist, desto stärker. Um ein leistungsstärkeres Sprachmodell zu verfolgen, stapeln große Technologieunternehmen verrückt, Modellparameter und Schulungsdaten, aber sie stellen fest, dass die Kosten ebenfalls gestiegen sind. Gibt es keine kostengünstigen und effizienten Möglichkeit, Sprachmodelle auszubilden?

Forscher der Harvard und der Stanford University haben kürzlich ein Papier veröffentlicht, in dem sie festgestellt haben, dass die Präzision des Modelltrainings wie ein versteckter Schlüssel ist, der das "Kostenkennwort" des Sprachmodelltrainings freischaltet.

Was ist die Modellgenauigkeit? Traditionelle Deep-Learning-Modelle werden normalerweise mit 32-Bit-Gleitkomma-Zahlen (FP32) trainiert. Verwenden Sie jedoch in den letzten Jahren jedoch mit der Entwicklung von Hardware mit niedrigeren Präzisionsnumerien wie 16-Bit-Schwimmpunktzahlen (FP16) oder 8-Bit Ganzzahlen (INT8) Training sind möglich geworden.

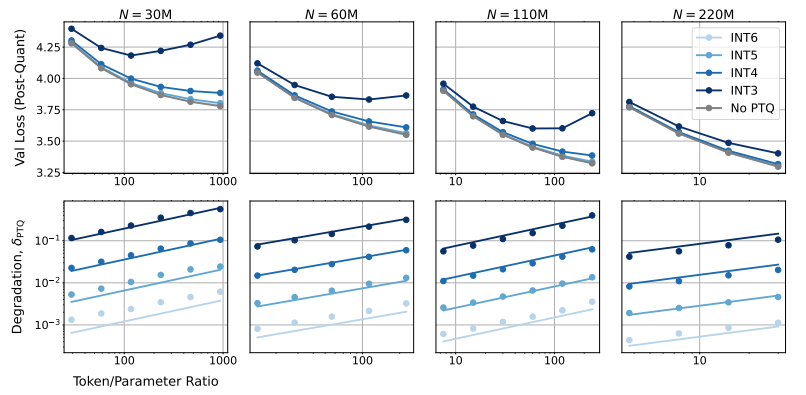

Welche Auswirkungen reduzieren die Modellgenauigkeit auf die Modellleistung genau die Frage, die dieses Papier erforschen möchte. Durch eine große Anzahl von Experimenten analysierten die Forscher die Kosten- und Leistungsänderungen des Modelltrainings und der Inferenz bei unterschiedlicher Genauigkeit und schlugen einen neuen Satz von "Präzisionswahrnehmungs" -Skalierungsregeln vor.

Sie fanden heraus, dass ein Training mit niedrigerer Präzision die "Anzahl effektiver Parameter" des Modells effektiv verringern kann, wodurch die für das Training erforderliche Berechnung verringert wird. Dies bedeutet, dass wir unter demselben Rechenbudget größere Modelle schulen können oder im gleichen Maßstab eine niedrigere Genauigkeit verwenden können, um viele Rechenressourcen zu sparen.

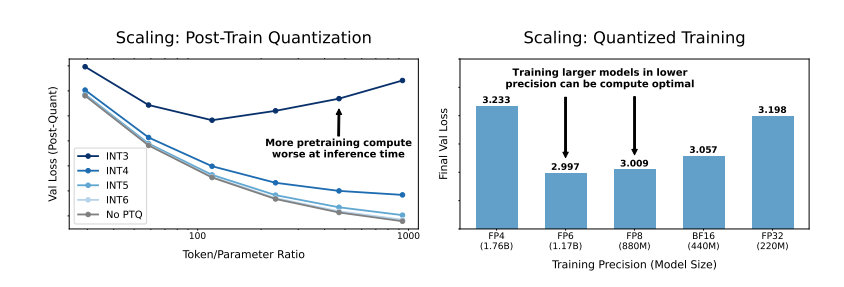

Noch überraschender, dass die Forscher in einigen Fällen auch die Leistung des Modells für diejenigen, die eine "Quantisierung nach der Ausbildung benötigen", in einigen Fällen auch die Leistung des Modells verbessern können, wenn das Modell mit geringerer Genauigkeit während des Trainings verwendet wird, Phase, das Modell ist robuster für die Verringerung der Quantisierungsgenauigkeit, wodurch eine bessere Leistung in der Inferenzphase zeigt.

Welche Präzision sollten wir das Modell ausbilden?

Traditionelles 16-Bit-Präzisionstraining ist möglicherweise nicht die beste Wahl. Ihre Untersuchungen zeigen, dass die Genauigkeit von 7-8-Bit möglicherweise eine kostengünstigere Option darstellt.

Es ist kein kluger Schritt, eine ultra-niedrige Precision (wie 4-Bit) zu absolvieren. Da bei extrem geringer Genauigkeit die Anzahl der effektiven Parameter des Modells stark sinkt, müssen wir die Modellgröße erheblich erhöhen, was zu höheren Rechenkosten führen wird.

Die optimale Trainingsgenauigkeit kann für Modelle unterschiedlicher Größen variieren. Für Modelle, die viel "Übertraining" erfordern, wie die Lama-3- und Gemma-2-Serie, ist das Training mit höherer Genauigkeit möglicherweise kostengünstiger.

Diese Studie bietet uns eine völlig neue Perspektive, um das Sprachmodelltraining zu verstehen und zu optimieren. Es zeigt uns, dass die Auswahl der Genauigkeit nicht statisch ist, sondern auf der Grundlage der spezifischen Modellgröße, des Trainingsdatenvolumens und der Anwendungsszenarien abgeschrieben werden muss.

Natürlich hat diese Studie auch einige Einschränkungen. Zum Beispiel ist das von ihnen verwendete Modell relativ klein und die experimentellen Ergebnisse sind möglicherweise nicht direkt auf größere Modelle verallgemeinert. Darüber hinaus konzentrierten sie sich nur auf die Verlustfunktion des Modells und bewerteten die Leistung des Modells bei nachgeschalteten Aufgaben nicht.

Trotzdem ist diese Studie von großer Bedeutung. Es zeigt die komplexe Beziehung zwischen Modellgenauigkeit und Modellleistung und Schulungskosten und bietet uns wertvolle Erkenntnisse, um in Zukunft stärkere und wirtschaftlichere Sprachmodelle zu entwerfen und auszubilden.

Papier: https://arxiv.org/pdf/2411.04330

Kurz gesagt, diese Studie bietet neue Ideen und Methoden zur Reduzierung der Schulungskosten großer Sprachmodelle und einen wichtigen Referenzwert für die zukünftige Entwicklung des Feldes für künstliche Intelligenz. Obwohl es einige Einschränkungen in der Forschung gibt, haben die vorgeschlagene Skalierungsregel "Präzisionswahrnehmung" und die eingehende Diskussion der Beziehung zwischen Modellgenauigkeit und Kosten und Leistung eine wichtige theoretische und praktische Leit von Bedeutung.