Das LLM -Modell des Großsprachenmodells (LLM) verfügt über Unzulänglichkeiten in den Daten zur Verarbeitungstabelle, und das Forschungsteam des Institute of Computing Innovation der Universität Zhejiang hat das TableGPT2 -Modell für diesen Zweck entwickelt. Dieses Modell ermöglicht eine effiziente Integration und Verarbeitung von tabellarischen Daten und bringt neue Möglichkeiten für Business Intelligence (BI) und andere datengesteuerte Anwendungen. Die Kerninnovation von TableGPT2 liegt in seinem eindeutigen Tabellencodierer, mit dem die Informationen und Zellinhaltsinformationen der Tabelle effektiv erfasst und die Fähigkeit des Modells, Fuzzy -Abfragen, fehlende Spaltennamen und unregelmäßige Tabellen zu verarbeiten, verbessern können. Durch groß angelegte Vorausbildung und Feinabstimmung sowie kontinuierliche Vorausbildung (CPT) und beaufsichtigte Feinabstimmung (SFT) zeigt TableGPT2 starke Codierungs- und Argumentationsfähigkeiten, die komplexe BI-Aufgaben erledigen können.

Der Aufstieg großer Sprachmodelle (LLM) hat die Verwendung künstlicher Intelligenz revolutioniert, haben jedoch offensichtliche Mängel bei der Verarbeitung tabellarischer Daten. Das Forschungsteam des Instituts für Computing Innovation der Universität Zhejiang hat ein neues Modell namens TableGPT2 gestartet, das Daten direkt und effizient integrieren und die Tischdaten integrieren kann und sich für Business Intelligence (BI) und andere datengesteuerte Anwendungen öffnet.

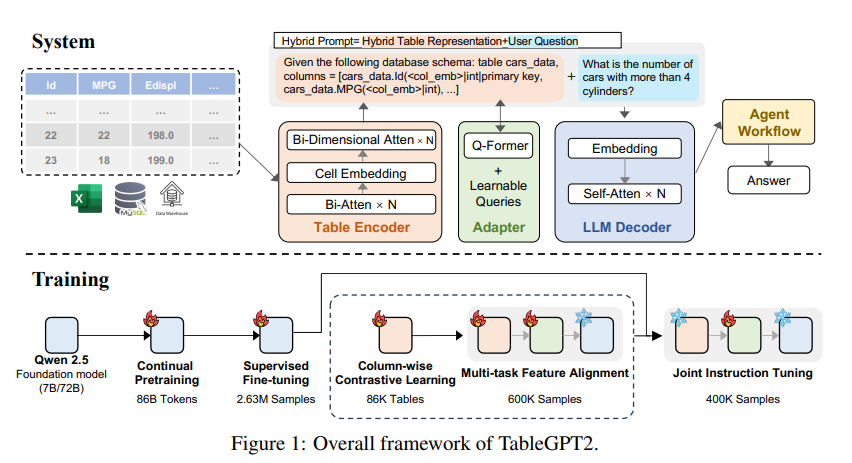

Die Kerninnovation von TableGPT2 ist der eindeutige Tabellencodierer, der speziell zur Erfassung der Struktur- und Zellinhaltsinformationen von Tabellen entwickelt wurde, wodurch die Fähigkeit des Modells, Fuzzy-Abfragen, fehlende Spaltennamen und unregelmäßige Tabellen in realen Anwendungen zu verbessern. TabelleGPT2 basiert auf der QWEN2.5-Architektur und wurde in großem Maßstab vor der Ausbildung und der Feinabstimmung unterzogen. Dies umfasst mehr als 593.800 Tabellen und 2,36 Millionen hochwertige Abfragen-Tisch-Output-Tupeln, was eine beispiellose Skala von Tabellenbezogen ist Daten in früheren Studien.

Um die Codierungs- und Inferenzfähigkeiten von TableGPT2 zu verbessern, führten die Forscher kontinuierliche Voraussetzungen (CPT) durch, wobei 80% der Daten sorgfältig mit dem Code kommentiert wurden, um sicherzustellen, dass sie über starke Codierungsfunktionen verfügen. Darüber hinaus sammelten sie eine große Menge an Argumentationsdaten und Lehrbüchern, die domänenspezifisches Wissen enthielten, um die Argumentationsfähigkeit des Modells zu verbessern. Die endgültigen CPT -Daten enthalten 86 Milliarden streng gefilterte Wortsymbole, die die erforderlichen Codierungs- und Argumentationsfunktionen für TableGPT2 für komplexe BI -Aufgaben und andere verwandte Aufgaben bieten.

Um die Einschränkungen von TableGPT2 bei der Anpassung an bestimmte BI -Aufgaben und -szenarien anzugehen, führten die Forscher eine beaufsichtigte Feinabstimmung (SFT) durch. Sie konstruierten einen Datensatz, der eine Vielzahl kritischer und realistischer Szenarien umfasste, darunter mehrere Gespräche, komplexe Argumentation, Werkzeugnutzung und hochgeschäftsorientierte Abfragen. Dieser Datensatz kombiniert manuelle Annotation und fachmännische automatische Annotationsprozess, um die Datenqualität und Relevanz zu gewährleisten. Der SFT-Prozess verwendet insgesamt 2,36 Millionen Stichproben, um das Modell weiter zu verfeinern, um die spezifischen Bedürfnisse von BI und anderen tischbezogenen Umgebungen zu erfüllen.

TableGPT2 führte auch innovativ einen semantischen Tabellencodierer ein, der die gesamte Tabelle als Eingabe nimmt, um einen kompakten Satz von Einbettungsvektoren für jede Spalte zu generieren. Diese Architektur ist für die eindeutigen Eigenschaften der tabellarischen Daten angepasst und erfasst die Beziehung zwischen Zeilen und Spalten effektiv durch einen Aufmerksamkeitsmechanismus mit zwei Wegen und einen hierarchischen Merkmalsextraktionsprozess. Darüber hinaus wird eine säulenförmige Kontrastlernmethode verwendet, um das Modell zu fördern, um aussagekräftige, strukturbewusste tabellarische semantische Darstellungen zu lernen.

Um TableGPT2 nahtlos in Datenanalyse-Tools auf Unternehmensebene zu integrieren, haben die Forscher auch ein Runtime-Framework der Agent Workflow-Laufzeit entwickelt. Das Framework enthält drei Kernkomponenten: Laufzeit -Eingabeaufforderung, Sicherheitscode Sandbox und Proxy Evaluierungsmodul, das gemeinsam die Funktionen und Zuverlässigkeit des Proxy verbessert. Der Workflow unterstützt komplexe Datenanalyseaufgaben durch modulare Schritte (Eingabenormalisierung, Proxyausführung und Toolaufrufe), die zusammenarbeiten, um die Leistung des Proxy zu verwalten und zu überwachen. Durch die Integration von Such-Verbesserung der Generation (RAG) für effizientes Kontextabruf und Code-Sandbox zur sicheren Ausführung stellt das Framework sicher, dass TableGPT2 genaue, kontextsensitive Erkenntnisse in reale Probleme bietet.

Die Forscher führten umfangreiche Bewertungen von TableGPT2 in einer Vielzahl von weit verbreiteten Tabellen und allgemeinen Benchmarks durch. 720% Die durchschnittliche Leistung des 100 -Millionen -Parametermodells ist um 49,32% gestiegen, während die starke allgemeine Leistung beibehalten wird. Für eine faire Bewertung verglichen sie nur TableGPT2 mit Open -Source -Benchmark -neutralen Modellen wie Qwen und Deepseek, um eine ausgewogene, vielseitige Leistung des Modells für eine Vielzahl von Aufgaben zu gewährleisten, ohne einen einzelnen Benchmark -Test zu übertreffen. Sie haben auch einen neuen Benchmark, Realtabbench, eingeführt und teilweise veröffentlicht, in dem sich unkonventionelle Tabellen, anonyme Felder und komplexe Abfragen hervorheben, die eher mit realen Szenarien übereinstimmen.

Obwohl TableGPT2 in Experimenten eine modernste Leistung erzielt hat, gibt es Herausforderungen beim Einsatz von LLM in BI-Umgebungen in realer Welt. Die Forscher wiesen darauf hin, dass zukünftige Forschungsrichtungen: umfassen:

Domänenspezifische Codierung: Ermöglicht LLM, sich schnell an unternehmensspezifische domänenspezifische Sprache (DSL) oder Pseudo-Code anzupassen, um die spezifischen Anforderungen der Infrastruktur für Unternehmensdaten besser zu erfüllen.

Multi-Agent-Design: Erforschen Sie, wie mehrere LLMs effektiv in ein einheitliches System integriert werden können, um die Komplexität der realen Anwendungen zu bewältigen.

Multifunktionale Tabellenverarbeitung: Verbessert die Fähigkeit von Modellen, unregelmäßige Tabellen zu verarbeiten, wie z. B. zusammengeführte Zellen und inkonsistente Strukturen, die üblicherweise in Excel und Seiten zu finden sind, um tabellarische Daten in verschiedenen Formen in der realen Welt besser zu verarbeiten.

Der Start von TableGPT2 ist ein erheblicher Fortschritt bei LLM in der Verarbeitung von Tabellendaten und bringt neue Möglichkeiten für Business Intelligence und andere datengesteuerte Anwendungen ein. Ich glaube, dass TabelleGPT2 im Bereich der Datenanalyse in Zukunft eine zunehmend wichtige Rolle im Bereich der Datenanalyse spielen wird.

Papieradresse: https://arxiv.org/pdf/2411.02059v1

Insgesamt hat TableGPT2 bemerkenswerte Ergebnisse in der Verarbeitung von Tabellendaten erzielt, wobei seine innovativen Architektur- und Trainingsmethoden sich in mehreren Benchmarks abheben. Zukünftige Forschungsanweisungen werden sich weiterhin auf die Anpassungsfähigkeit und Praktikabilität von Modellen konzentrieren, um den Bedürfnissen realer Business Intelligence-Anwendungen besser gerecht zu werden.