Peking Zhipu Huazhang Technology Co., Ltd., hat das Open -Source -Modell von Cogvideox V1.5 auf den Markt gebracht, das im Bereich der Videogenerierung erhebliche Durchbrüche erzielt hat. Nach ihrer Veröffentlichung Anfang August ist die Cogvideox-Serie mit ihren führenden Technologien und Entwicklern-freundlichen Funktionen schnell zum Schwerpunkt der Branche geworden. Dieses Update hat viele Verbesserungen gebracht, einschließlich der Unterstützung einer längeren und höher definitiven Videogenerierung sowie einer signifikanten Verbesserung des Qualitäts- und semantischen Verständnisses des Bildgenerierungsvideos, wodurch Benutzer ein besseres Erlebnis der AI-Videogenerierung bieten. Beachten Sie, dass die neue Version die Qingying -Plattform und das CogSound Sound Effect -Modell integriert und das Ökosystem der Videogenerierung weiter verbessert.

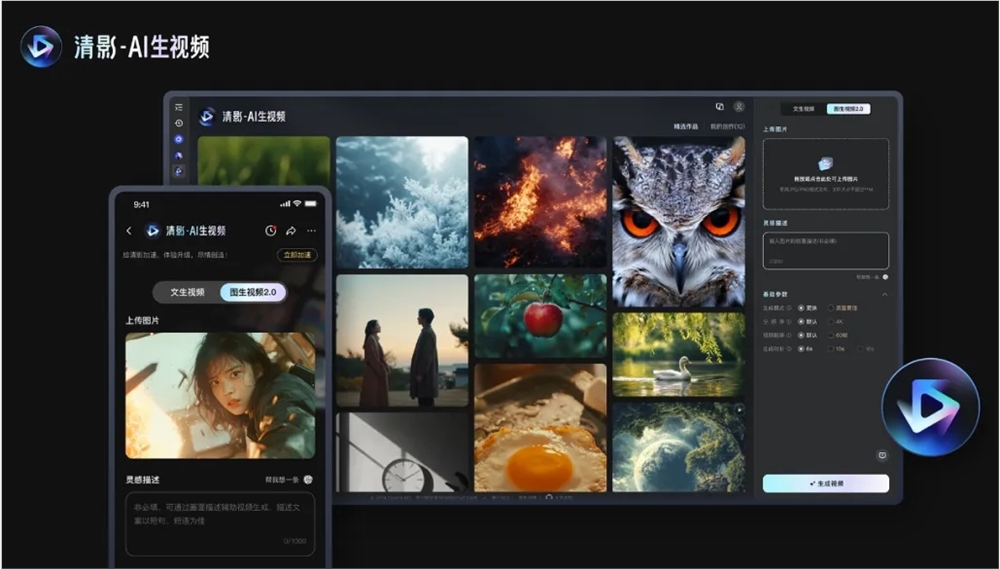

Der Inhalt dieser Open Source enthält zwei Modelle: Cogvideox V1.5-5b und Cogvideox V1.5-5B-I2V. Die neue Version wird auch gleichzeitig auf der Qingying-Plattform auf den Markt gebracht und mit dem neu gestarteten CogSound Sound Sound Effect-Modell kombiniert, um die Unterstützung von Qualitätsverbesserungen, Support-Definition-Auflösung und variable Proportionen zu bieten, um sich an verschiedene Wiedergabeszenarien anzupassen, Multi-Channel Ausgabe und KI -Videos mit Soundeffekten.

Auf technischer Ebene filt COGVIDEOX V1.5 Videodaten, denen dynamische Konnektivität durch ein automatisiertes Filtergerüst fehlt, und verwendet ein End-to-End-Videoverständnismodell, COGVLM2-Kapion, um genaue Beschreibungen des Textinhalts zu generieren, um das Textverständnis und die Einhaltung der Anweisungen zu verbessern und die Einhaltung der Anweisungen zu erhalten Fähigkeiten. Darüber hinaus nimmt die neue Version einen effizienten dreidimensionalen Variationsautoencoder (3D VAE) an, um das Problem der Inhaltskohärenz zu lösen und unabhängig von und Experten-Normalisierungstechnologie optimiert die Nutzung von Zeitschrittinformationen im Diffusionsmodell.

In Bezug auf das Training baut Cogvideox V1.5 ein effizientes Diffusionsmodelltraining -Framework auf und erreicht ein schnelles Training langer Videosequenzen durch eine Vielzahl von parallelen Computer- und Zeitoptimierungstechniken. Das Unternehmen sagte, dass es die Effektivität des Skalierungsgesetzes im Bereich der Videogenerierung überprüft hat und plant, in Zukunft die Datenvolumen und die Modellskala zu erweitern, innovative Modellarchitekturen effizienter zu erforschen und Textinformationen besser zu integrieren und Text- und Videoinhalte besser zu integrieren.

Code: https://github.com/thudm/cogvideo

Modell: https://huggingface.co/thudm/cogvideox1.5-5b-sat

Die Open Source of Cogvideox V1.5 bietet einen neuen Impuls für die Entwicklung der Videogenerierungstechnologie und bietet Entwicklern leistungsfähigere Tools. Zhipu Huazhangs kontinuierliche technologische Innovation und Open -Source -Geist sind der Anerkennung wert, und die zukünftigen Anwendungsaussichten dieses Modells sind es wert, sich darauf zu freuen. Ich freue mich auf innovativere Anwendungen, die auf Cogvideox V1.5 basieren.