Fish Audio hat sein neues Sprachverarbeitungsmodell Fish Agent V0.13b veröffentlicht, ein beeindruckendes Modell zu Sprach-Sprache, das Sprache effizient und genau erzeugen und verarbeitet und gut in der Simulation und Klone verschiedener Klänge ist. Das Modell wird auf der Basis von QWEN-2.5-3B-Instruktur vorgebunden und verwendet einen massiven Datensatz mit 200 Milliarden Sprach- und Text-Token. Seine Innovation liegt in der Einführung einer "semantischen tokenfreien" Architektur, die die Sprache direkt auf der Klangebene verarbeitet und so die Geschwindigkeit und Effizienz verbessert und "Instant" -sprachklone und Text-zu-Sprache-Konvertierung realisiert, die nur 200 Millisekunden dauert. Das Modell unterstützt mehrere Sprachen und ist Open Source, wodurch die Entwicklung der AI -Sprachtechnologie neue Möglichkeiten bringt.

Kürzlich veröffentlichte FISH Audio das neue Sprachverarbeitungsmodell FISH AGENT V0.13B. Dies bedeutet, dass wir uns einem natürlichen und reaktionsschnellen KI -Sprachassistenten einen Schritt näher kommen.

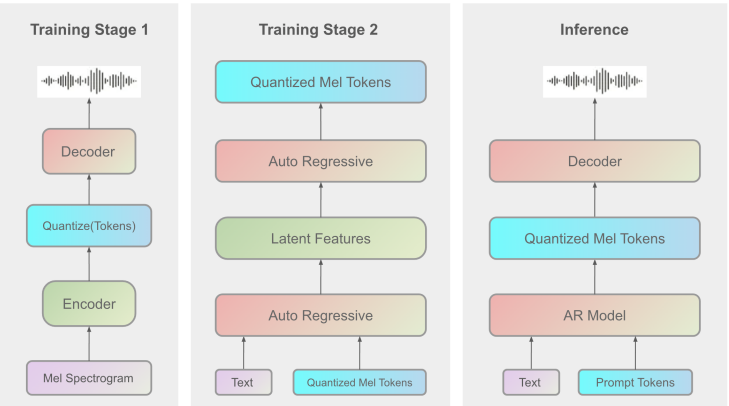

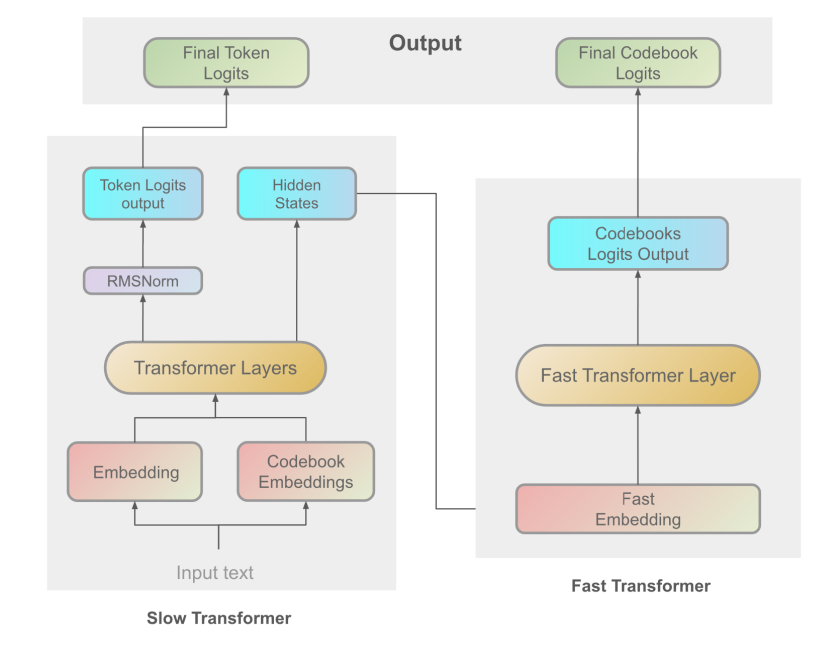

Das FISH-Agent V0.13b-Modell wird auf der Grundlage von QWEN-2.5-3B-Instruktur vorgebunden und verwendet einen massiven Datensatz, der 200 Milliarden Sprach- und Text-Token enthält. Im Gegensatz zu herkömmlichen Modellen, bei denen die Sprache zuerst in komplexe semantische Codierung umgewandelt werden muss, nimmt FISH Agent V0.13b eine Architektur namens "semantisches Token" an, um die Sprache direkt auf der Schallebene zu verarbeiten und zu generieren. Diese direkte Verarbeitung vereinfacht nicht nur die Modellstruktur, sondern verbessert auch die Reaktionsgeschwindigkeit und Effizienz des Modells.

Dank dieser innovativen Architektur kann FISH Agent V0.13b schnell und natürlich eine qualitativ hochwertige Stimme erzeugen und das "Instant" -sprachkloning und die Konvertierung von Text-zu-Sprache mit Text-to-Audio-Konvertierungszeit (TTFA) in nur 200 Millisekunden ermöglichen . Diese Funktion macht es ideal für Anwendungsszenarien, die eine Echtzeit-Sprachgenerierung erfordern, z. B. Sprachassistenten, automatischer Kundendienst und andere Szenarien, für die schnelles Sprachfeedback erforderlich ist.

Das FISH -Agent V0.13B Modell unterstützt mehrere Sprachen, darunter Englisch, Chinesisch, Deutsch, Japanisch, Französisch, Spanisch, Koreanisch und Arabisch, und verwendet etwa 700.000 Stunden mehrsprachiger Audiodaten für das Training. Dies bedeutet, dass es mehrere Sprachen und Kontexte bewältigen kann und der realen Person natürlicher und engere Aussprache erzeugt.

Zusätzlich zur Erzeugung von Voice-to-Speech-Konvertierung und zur Rekontumfunktionen von Text-zu-Sprache verfügt FISH Agent V0.13b auch über die folgenden Schlüsselfunktionen:

Sprachkloning von Zero-Probe: Sprachklonen können ohne Training erreicht werden.

Vereinfachte 3B -Parameter: Verwenden Sie 3 Milliarden Parameter für eine einfache Entwicklung.

Unterstützt Text- und Audioeingabe: Flexible Methode mit mehreren Eingängen.

Derzeit hat FISH Audio das FISH -Agent V0.13b -Modell offen und bietet eine vorläufige Demo -Version für die Benutzererfahrung. Die Veröffentlichung dieses Modells wird die Entwicklung der AI -Sprachtechnologie weiter fördern und mehr Möglichkeiten für Anwendungen wie Sprachassistenten und virtuelle Personen einbringen.

Github: https://github.com/fishaudio/fish-speech

FISH Agent Demo: https://huggingface.co/spaces/fishaudio/fish-agent

Modell herunterladen: https://huggingface.co/fishaudio/fish-agent-v0.1-3b

Technischer Bericht: https://arxiv.org/abs/2411.01156

Die Open -Source -Veröffentlichung des FISH -Agenten V0.13b -Modells wird neue Durchbrüche in die Forschung und Anwendung des AI -Sprachfeldes bringen, und es lohnt sich, sich auf seine Rolle bei der zukünftigen Entwicklung der Sprachtechnologie zu freuen. Ich hoffe, dass mehr Entwickler teilnehmen und gemeinsam die Weiterentwicklung der AI -Sprachtechnologie fördern können.