Das Shanghai AI Lab Team hat die Quelle der Lama-Version des O1-Projekts eröffnet, ein Open-Source-Replikatprojekt für das OpenAI-Olympiad-Problemlösungswerkzeug O1. Das Projekt verwendet fortschrittliche Technologien wie Monte Carlo Tree Search und Verstärkungslernen, um bemerkenswerte Ergebnisse bei der Beantwortung mathematischer olympiade Fragen zu erzielen, und seine Leistung übertrifft sogar die einer kommerziellen Closed-Source-Lösungen. Die Open Source des Projekts bietet Entwicklern wertvolle Lernressourcen und Forschungsstiftungen und fördert auch die Weiterentwicklung der Anwendung künstlicher Intelligenz im Bereich der Mathematik. Dieses Projekt umfasst vorgebildete Datensätze, vorgebildete Modelle und Schulungscodes für Verstärkungslernen usw. und verwendet eine Vielzahl von Optimierungstechnologien, darunter LORA und PPO, um die Fähigkeit des Modells im mathematischen Denken zu verbessern.

Kürzlich hat das Shanghai AI Lab Team die Lama-Version des O1-Projekts veröffentlicht, mit dem OpenAIs Olympiade-Problemlösungswerkzeug O1 nachgebildet werden soll. Das Projekt verwendet eine Vielzahl fortschrittlicher Technologien, darunter Monte Carlo Tree Search, Self-Play-Verstärkungslernen, PPO und Alphago Zero's Dual-Strategie-Paradigma, das von der Entwicklergemeinschaft weit verbreitete Aufmerksamkeit auf sich gezogen hat.

Lange vor der Veröffentlichung der O1 -Serie von Openai begann das Shanghai AI Lab -Team, die Verwendung der Monte -Carlo -Baumsuche zur Verbesserung der mathematischen Fähigkeit großer Modelle zu untersuchen. Nach der Veröffentlichung von O1 hat das Team den Algorithmus weiter verbessert, konzentrierte sich auf das Mathematik -Olympiade -Problem und entwickelte ihn als Open -Source -Version des OpenAI -Strawberry -Projekts.

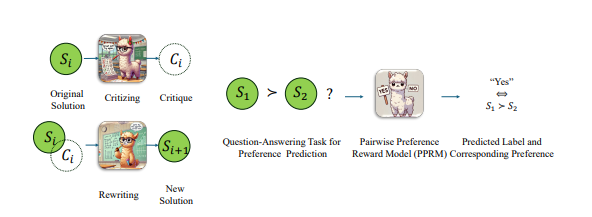

Um die Leistung des Lama -Modells in mathematischen olympiaden Problemen zu verbessern, verfolgte das Team eine gepaarte Optimierungsstrategie, dh nicht direkt die absolute Punktzahl der Antwort, sondern vergleichen die relativen Vor- und Nachteile der beiden Antworten. Mit diesem Ansatz haben sie bei den schwierigsten Aime2024 -Benchmarks erhebliche Fortschritte erzielt. Unter den 30 Testfragen wurde das optimierte Modell korrekt durchgeführt 8, während das ursprüngliche Lama-3,1-8b-Instrukturmodell korrekt durchgeführt wurde 2. Diese Leistung übertrifft neben O1-Präview und O1-Mini andere kommerzielle Closed-Source-Lösungen.

Ende Oktober kündigte das Team erhebliche Fortschritte bei der Replikation von OpenAI O1 an, basierend auf der Alphago Zero -Architektur, sodass das Modell erfolgreich durch die Interaktion mit dem Suchbaum während des Lernprozesses ohne manuelle Annotation erweitert wird. In weniger als einer Woche wurde das Projekt eröffnet.

Derzeit umfasst der Open-Source-Inhalt der Lama-Version O1: vorgebildete Datensätze, vorgebildete Modelle und Trainingscode für Verstärkung. Unter ihnen enthält der Datensatz "OpenLongCot-Prächter" mehr als 100.000 Langkettenkettendaten. Jede Daten enthält einen vollständigen mathematischen Problem-Argumentationsprozess, einschließlich Denkinhalte, Bewertungsergebnisse, Problembeschreibung, Grafikkoordinaten, Berechnungsprozess, Schlussfolgerung und anderen Vollständige Inferenzverbindungen sowie Kritik und Überprüfung jedes Inferenzschritts geben Bewertung und Leitlinien für den Inferenzprozess an. Nachdem das Modell vor dem Training in diesem Datensatz fortgesetzt wurde, kann er lange Gedankenkettenprozesse wie O1 lesen und ausgeben.

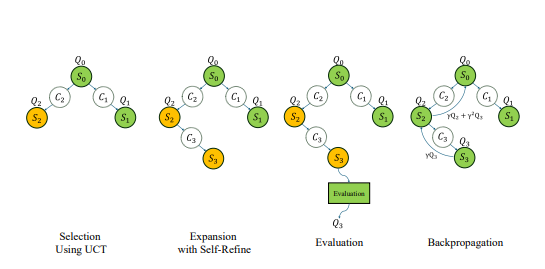

Obwohl das Projekt LLAMA-O1 genannt wird, basiert das derzeit vom Beamten vorgelegte vorgebildete Modell auf Googles GEMMA2. Basierend auf dem vorgeborenen Modell können Entwickler weiterhin das Training für Verstärkungslernen durchführen. Der Trainingsprozess umfasst: Verwendung von Monte-Carlo-Baum-Suche nach Selbstgebiet, um Erfahrungen in einer Prioritätserfahrung zu speichern. Einige Schlüsseltechnologien werden auch im Trainingscode verwendet, einschließlich der Verwendung von LORA zur effizienten Parameterfeineinstellung, der Verwendung von PPO-Algorithmus als Strategieoptimierungsmethode, der Implementierung des GAE-Algorithmus zur Berechnung von vorteilhaften Funktionen und der Verwendung der Wiedergabe von Priority Experience zur Verbesserung der Trainingseffizienz.

Es ist erwähnenswert, dass der Lama-O1-Code unter dem Github-Account namens SimpleBerry veröffentlicht wurde. Aus anderen SimpleBerry-bezogenen Konten und offiziellen Website-Informationen ist nur ersichtlich, dass seine Natur ein Forschungslabor ist, aber es werden keine weiteren Informationen zur Forschungsrichtung offengelegt.

Zusätzlich zu Lama-O1 stammt ein weiteres öffentlich fortgeschrittenes O1-Replik-Projekt O1-Journey aus dem Team der Shanghai Jiaotong University. Das Team veröffentlichte Anfang Oktober seinen ersten Fortschrittsbericht und führte das innovative Paradigma Learning und das erste Modell ein, um die Suche und das Lernen erfolgreich in mathematisches Denken zu integrieren. Das O1-Journey-Kernentwicklungsteam besteht hauptsächlich aus Junior- und Senior-Studenten an der Shanghai Jiaotong University sowie Doktoranden im ersten Jahr aus dem Gair-Labor (General Artificial Intelligence Research Laboratory). an der Shanghai Jiaotong University.

Papieradresse: https://arxiv.org/pdf/2410.02884

https://arxiv.org/pdf/2406.07394

Die Open Source der Lama-Version O1-Projekt ist wichtige Fortschritte im Bereich der Problemlösung der KI-Mathematik und bietet auch eine solide Grundlage für weitere Forschung und Anwendung. Wir freuen uns auf innovativere Errungenschaften, die in Zukunft auf diesem Projekt basieren.