US -amerikanische Startup Nützliche Sensoren hat ein Open -Source -Spracherkennungsmodell namens Moonshine veröffentlicht, das darauf abzielt, die Effizienz der Audio -Datenverarbeitung zu verbessern. Im Vergleich zum Flüstern von OpenAI ist Moonshine in den Rechenressourcen wirtschaftlicher und hat die Verarbeitungsgeschwindigkeit um das Fünf-Mal erhöht, insbesondere für ressourcenbezogene Hardware und Echtzeitanwendungen. Die flexible Architektur und die dynamische Anpassung der Verarbeitungszeit entsprechend der Audiolänge machen es hervorragend bei der Verarbeitung kurzer Audioclips und reduzieren die Verarbeitungsaufwand effektiv. Moonshine liefert zwei Versionen, winzig und Basis, mit Parametern von 27,1 Millionen bzw. 61,5 Millionen, die beide besser sind als die Leistung ähnlicher Modelle in der Ressourcenauslastung.

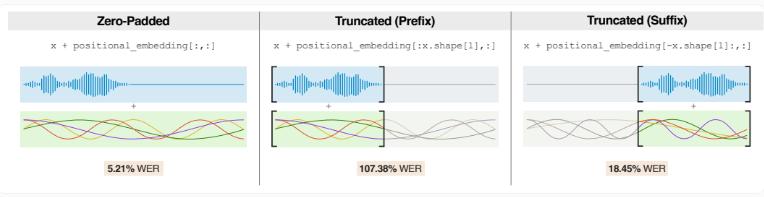

Im Gegensatz zu Whisper, der Audio in feste 30-Sekunden-Clips unterteilt, passt Moonshine die Verarbeitungszeit entsprechend der tatsächlichen Audiolänge an. Dies macht es gut, wenn Sie kürzere Audioclips abwickeln, wodurch der Verarbeitungsaufwand aufgrund von Nullpolsterung verringert wird.

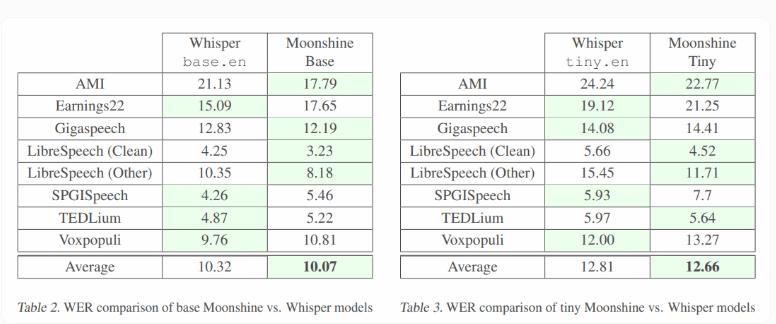

Moonshine hat zwei Versionen: Die kleine winzige Version hat ein Parametervolumen von 27,1 Millionen und die große Basisversion hat ein Parametervolumen von 61,5 Millionen. Im Gegensatz dazu sind die ähnlichen Modellparameter von OpenAI größer, wobei Whisper Tiny 37,8 Millionen und Basis beträgt.

Testergebnisse zeigen, dass das winzige Modell von Moonshine in Bezug auf Genauigkeit mit Flüstern vergleichbar ist und weniger Rechenressourcen verbraucht. Beide Versionen von Moonshine sind für verschiedene Audiopegel und Hintergrundrauschen niedriger als das Flüsterfehlerrate (WOR -Fehlerrate) und zeigen eine starke Leistung.

Das Forschungsteam wies darauf hin, dass Moonshine bei der Verarbeitung extrem kurzer Audio -Chips (weniger als eine Sekunde) noch Verbesserung hat. Diese kurzen Audios machen einen kleinen Teil der Schulungsdaten aus, und die zunehmende Schulung solcher Audioclips kann die Leistung des Modells verbessern.

Darüber hinaus öffnen die Offline -Funktionen von Moonshine neue Anwendungsszenarien, und Anwendungen, die aufgrund von Hardware -Einschränkungen zuvor nicht verfügbar waren, sind jetzt möglich. Im Gegensatz zu Whisper, der einen höheren Stromverbrauch erfordert, eignet sich Moonshine zum Laufen auf Smartphones und kleinen Geräten wie Raspberry Pi. Nützliche Sensoren verwenden Moonshine, um seinen englisch-spanischen Übersetzer Torre zu entwickeln.

Der Code von Moonshine wurde auf GitHub veröffentlicht, und Benutzer müssen beachten, dass AI -Transkriptionssysteme wie Whisper Fehler aufnehmen können. Einige Studien haben gezeigt, dass Whisper eine 1,4% ige Chance von falschen Informationen hat, wenn Inhalte, insbesondere für Menschen mit Sprachbarrieren, mit höheren Fehlerraten generiert werden.

Projekteingang: https://github.com/usefulsensors/moonshine

Schlüsselpunkte:

Moonshine ist ein Open -Source -Spracherkennungsmodell, das fünfmal schneller verarbeitet als das Flüstern von Openai.

Dieses Modell kann die Verarbeitungszeit entsprechend der Audiolänge anpassen, insbesondere für kurze Audioclips.

Moonshine unterstützt den Offline -Betrieb und eignet sich für die Verwendung mit begrenzten Ressourcen.

Kurz gesagt, Moonshine bietet neue Möglichkeiten zur Spracherkennungstechnologie mit effizienter Verarbeitungsgeschwindigkeit, flexibler Architektur und geringer Nachfrage nach Ressourcen, insbesondere in ressourcenbezogenen Geräten und in Echtzeit-Anwendungsszenarien. Die Open -Source -Funktionen ermöglichen den Entwicklern auch, sich zu verbessern und zu bewerben. Sie sind es wert, aufmerksam zu machen und darauf zu freuen.