Das Umarmungsgesicht hat ein neues kompaktes Sprachmodell, Smollm2, auf den Markt gebracht, was ein aufregender Durchbruch ist. Smollm2 verfügt über drei verschiedene Versionen der Parametergröße, die selbst auf ressourcenbeschränkten Geräten eine leistungsstarke Leistung bieten, was für Edge Computing und mobile Geräteanwendungen von großer Bedeutung ist. Es zeichnet sich in mehreren Benchmarks aus und übertrifft ähnliche Modelle und zeigt seine Vorteile in Bezug auf wissenschaftliches Denken und Aufgaben des gesunden Menschenverstandes. Die Open Source- und Apache 2.0 -Lizenz von Smollm2 erleichtert auch den Zugriff und die Bewerbung.

Umarmung Face hat heute Smollm2 veröffentlicht, eine Reihe neuer kompakter Sprachmodelle, die eine beeindruckende Leistung erzielen und gleichzeitig viel weniger Rechenressourcen als große Modelle erfordern. Das neue Modell wird unter der Apache 2.0 -Lizenz veröffentlicht und wird in drei Größen erhältlich - 135 m, 360 m und 1,7B -Parameter - geeignet für die Bereitstellung für Smartphones und andere Kantengeräte mit begrenzter Verarbeitungsleistung und -speicher.

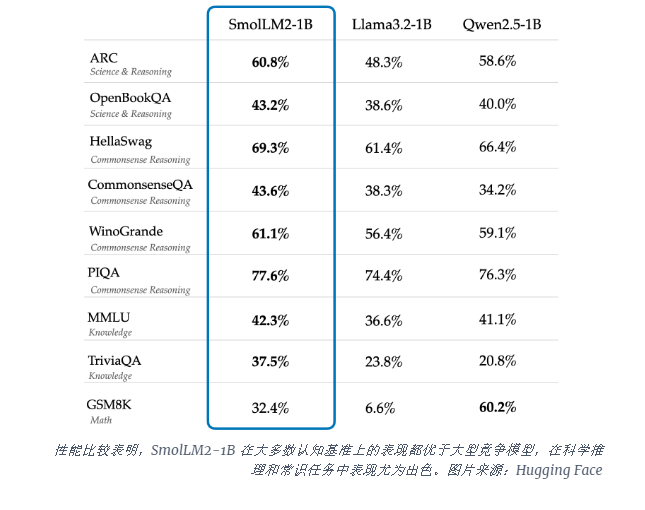

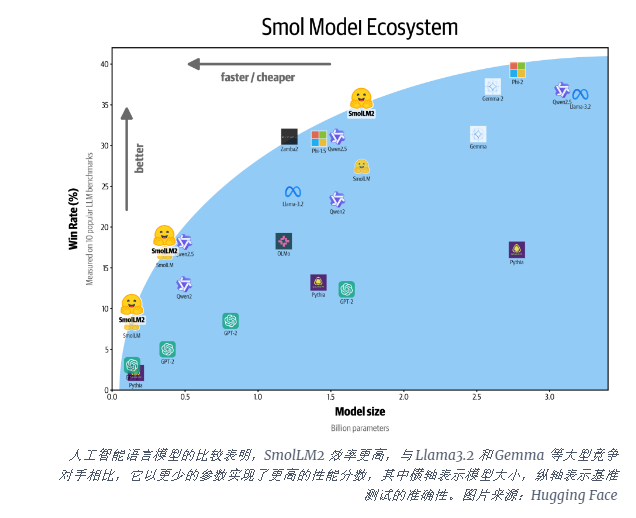

Das Smollm2-1b-Modell übertrifft das Meta-Lama1b-Modell in mehreren wichtigen Benchmarks, insbesondere in wissenschaftlichen Argumentation und im gesunden Menschenverstand. Dieses Modell übertrifft große konkurrierende Modelle an den meisten kognitiven Benchmarks, wobei eine vielfältige Kombination von Datensätzen wie Fineweb-EDU und spezialisierte mathematische und codierende Datensätze verwendet wird.

Der Start von Smollm2 erfolgt in einem kritischen Moment, in dem die KI -Industrie Schwierigkeiten hat, mit dem Computer umzugehen, um große Sprachmodelle (LLMs) auszuführen. Während Unternehmen wie OpenAI und Anthropic die Grenzen der Modellgröße weiter überschreiten, wird die Notwendigkeit einer effizienten, leichten KI zunehmend anerkannt, die lokal auf Geräten laufen kann.

Smollm2 bietet einen anderen Ansatz, um leistungsstarke KI -Funktionen direkt auf persönliche Geräte zu bringen, was auf die Zukunft hinweist, in der mehr Benutzer und Unternehmen erweiterte KI -Tools verwenden können, nicht nur auf Tech -Riesen mit riesigen Rechenzentren. Diese Modelle unterstützen eine Reihe von Anwendungen, einschließlich Texten, Zusammenfassung und Funktionsaufrufen, die für die Bereitstellung in Szenarien geeignet sind, in denen Datenschutz, Latenz oder Verbindungsbeschränkungen Cloud-basierte KI-Lösungen unpraktisch machen.

Während diese kleineren Modelle noch Einschränkungen aufweisen, stellen sie einen Teil eines breiten Trends in effizienteren KI -Modellen dar. Die Veröffentlichung von Smollm2 zeigt, dass die Zukunft der künstlichen Intelligenz möglicherweise nicht nur zu größeren Modellen gehört, sondern zu effizienteren Architekturen, die eine leistungsstarke Leistung mit weniger Ressourcen bieten können.

Die Entstehung von Smollm2 hat neue Möglichkeiten für leichte KI -Anwendungen eröffnet, was darauf hinweist, dass die KI -Technologie in verschiedenen Geräten und Szenarien weiter verwendet wird, um den Benutzern ein bequemeres und effizienteres Erlebnis zu bieten. Die Open Source -Funktionen haben auch die Weiterentwicklung und Innovation der KI -Community gefördert. In Zukunft wird erwartet, dass wir effizientere und kompaktere KI -Modelle auftreten, was die Populalisierung und Weiterentwicklung von AI -Technologien fördert.