Die Forschungsteams von Meta Fair, UC Berkeley und New York University haben an der Entwicklung einer neuen Technologie namens Thinking Preference Optimization (TPO) zusammengearbeitet, um die Einhaltung der Unterricht und die Reaktionsqualität in großen Sprachmodellen (LLM) erheblich zu verbessern. Im Gegensatz zu herkömmlichen LLMs, die direkt Antworten geben, ermöglicht die TPO -Technologie Modelle, vor der Antwort intern zu denken und nachzudenken, wodurch genauere und kohärentere Antworten generiert werden. Diese Innovation leitet das Modell, um seinen Denkprozess zu optimieren, ohne dem Benutzer die Zwischenschritte zu zeigen, und verbessert letztendlich die Qualität der Reaktionen durch eine verbesserte Methode für Kettendenken (COT).

Der Kern der TPO -Technologie ist die verbesserte Methode für Kettendenken (COT). Dieser Ansatz ermutigt Modelle, während des Trainings „zu denken und zu antworten“ und ihnen zu helfen, einen organisierteren inneren Denken zu erstellen, bevor sie die endgültige Antwort geben. Traditionelle COT -Cues können manchmal zu einer verringerten Genauigkeit führen und sind aufgrund des Mangels an klaren Denkschritten ziemlich schwierig zu trainieren. Und TPO überwindet diese Herausforderungen erfolgreich, indem es Modellen ermöglicht, ihren Denkprozess zu optimieren und zu vereinfachen, ohne dass sie den Benutzern intermediate Schritte aussetzen können.

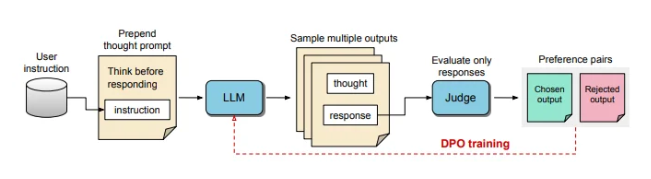

Während des TPO -Trainingsprozesses fordern Sie zunächst das große Sprachmodell auf, mehrere Ideen zu generieren, und sortieren Sie dann die endgültige Antwort. Diese Ausgänge werden dann von einem "Judger" -Modell bewertet, um die am besten darstellenden und schlechtesten Antworten auszuwählen. Diese Evaluierungsergebnisse werden als "Auswahl" und "Ablehnen" -Paare für die direkte Präferenzoptimierung (DPO) verwendet, um die Antwortqualität des Modells kontinuierlich zu verbessern.

Durch die Anpassung der Schulungsanforderungen ermutigt TPO das Modell, vor der Beantwortung intern nachzudenken. Dieser Prozess leitet das Modell, um seine Antworten zu optimieren, um es klarer und relevanter zu machen. Letztendlich erfolgt die Bewertung durch ein LLM-basiertes Urteilsmodell, das nur die endgültige Antwort bewertet, wodurch das Modell die Qualität der Antworten unabhängig von den verborgenen Denkschritten verbessert. TPO verwendet auch eine direkte Präferenzoptimierung, um bevorzugte und Ablehnungsantworten zu erstellen, die verborgenes Denken enthalten, und nach mehreren Trainingsrunden den internen Prozess des Modells weiter verfeinern.

In Benchmarks für AlpaCaeval und Arena-Hard übertraf die TPO-Methode die traditionelle Reaktionsgrundlinie und war besser als das Lama-3-8B-Instrukturmodell von "Denktipps". Das iterative Training dieser Methode optimiert die Funktionen der Denkmalgenerierung und übertrifft letztendlich mehrere Basismodelle. Es ist erwähnenswert, dass TPO nicht nur für Logik und mathematische Aufgaben geeignet ist, sondern auch in kreativen Bereichen wie Marketing und Gesundheitsanweisungen große Anstrengungen unternimmt, um Aufgaben zu befolgen.

KI und Robotics -Experte Karan Verma teilten seine Ansichten über das Konzept des "Denkens LLM" auf der sozialen Plattform X und sagten, er sei sehr aufgeregt darüber und freute sich auf das Potenzial dieser Innovation in medizinischen Anwendungen, die mehr Patienten bringen können .

Dieser strukturierte interne Denkenprozess ermöglicht es dem Modell, komplexe Anweisungen effektiver zu verarbeiten und seine Anwendung in Bereichen weiter zu erweitern, die ein multi-Ebenen-Denken und ein akribisches Verständnis erfordern, ohne dass Menschen bestimmte Denkdaten bereitstellen müssen. Diese Studie zeigt, dass TPO das Potenzial hat, Großsprachenmodelle flexibler und effizienter in verschiedenen Kontexten zu gestalten, die für Bereiche geeignet sind, in denen hohe Anforderungen für die Flexibilität und Tiefe der Reaktionsgenerierung vorhanden sind.

Die Durchbrüche in der TPO -Technologie haben großer Sprachmodelle eine stärkere Inferenz und das Verständnis der Fähigkeiten erbracht und neue Möglichkeiten für ihre Anwendung in verschiedenen Bereichen eröffnet, insbesondere in Aufgaben, die komplexe Denkprozesse erfordern.