Das Meta Fair Lab hat kürzlich eine bahnbrechende multimodale Fingerspitzen -Taktil -Wahrnehmungstechnologie namens "Sparsh" veröffentlicht, die das Feld der Robotermanipulation vollständig revolutionieren wird. Das SPARSH-Modell verwendet das selbstüberwachende Lernen, um mehr als 460.000 taktile Bilder vorzubeugen und allgemeine taktile Darstellungen ohne manuelle Kennzeichnung von Daten zu lernen und die taktile Wahrnehmungsfähigkeit des Roboters zu erkennen, die dem Menschen ähnlich ist. Es ist mit einer Vielzahl von visuellen haptischen Sensoren kompatibel und bietet bei mehreren Aufgaben wie der Kraftschätzung und der Erkennung von Schiebungen gut, insbesondere wenn die Daten begrenzt sind. Die Leistung überschreitet die der herkömmlichen Modelle bei weitem.

Das SPARSH-Modell nimmt selbst überprüftes Lernen an, wobei mehr als 460.000 taktile Bilder für die Vorausbildung verwendet werden, und lernt allgemeine taktile Darstellungen ohne manuelle Kennzeichnung von Daten.

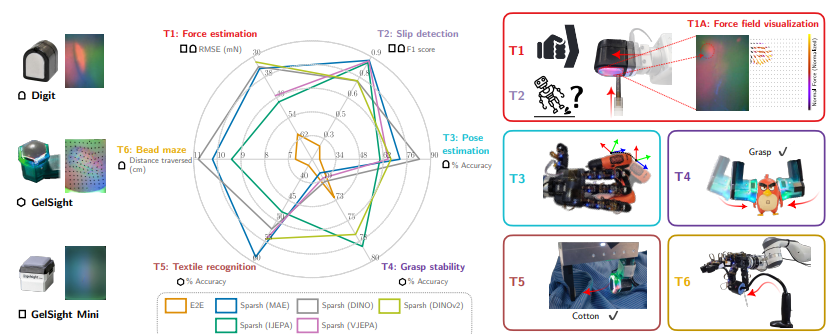

Das Modell kann eine Vielzahl von Arten von visuellen haptischen Sensoren, einschließlich Ziffern, Gelsight2017 und Gelsight Mini, unterstützen und die Roboterleistung bei taktilen Wahrnehmungsaufgaben wie Kraftschätzung, Gleitnachweis, Pose -Schätzung, Gabin -Stabilitätsvorhersage und Identifizierung von Stoffwaren erheblich verbessert. usw. Die Forscher konstruierten auch eine standardisierte Benchmarking -Plattform namens Tacbench, um die Leistung verschiedener haptischer Sensoren und Modelle für verschiedene Aufgaben zu bewerten.

Testergebnisse zeigen, dass das SPARSH-Modell bei allen sechs Aufgaben in Tacbench gut abschneidet, insbesondere wenn das Datenvolumen begrenzt ist und seine Leistung weit über die herkömmlichen aufgabenspezifischen und sensorspezifischen Modelle hinausgeht. Beispielsweise kann das Sparsh -Modell in Kraftschätzung und Schiebererkennungsaufgaben zufriedenstellende Ergebnisse erzielen, auch wenn nur 1% der Annotationsdaten verwendet werden. Dies bedeutet, dass Sparsh Robotern helfen kann, die physikalischen Eigenschaften von Objekten besser zu verstehen und raffiniertere Manipulationen durchzuführen.

Die Veröffentlichung des Sparsh -Modells markiert einen großen Durchbruch im Bereich der haptischen Wahrnehmung von AI. In Zukunft wird erwartet, dass Sparsh mit der Akkumulation von mehr Daten und einer weiteren Optimierung von Modellen die Art und Weise, wie Roboter mit der physischen Welt interagieren, vollständig verändert und die Anwendung von Robotik in einem breiteren Bereich von Feldern fördert.

Papieradresse:

https://scontent-sjc3-1.xx.fbcdn.net/v/t39.2365-6/464969941_1107633400780143_7479102347328147009_N.pdf?nc_nc_cat=103 ProgrammCat=103&cat=103&cat=103&cat=103&cat=103&cat=103&cat=103&cat=103&cat=103&cat=103&cat=103&cat=103 pro _nc_ohc = y8ui1hew3bqq7knvgfe-epu & _nc_zt = 14 & _nc_ht = scontent-sjc3-1. xx & _nc_gid = aeafsuzziasvwpfmqseozqu & oh = 00_ayamqxgq0atcysdxzwb0zt8bgskogymj13c9f3ytvtkmsg & oe = 672Deee4

Die Entstehung der Sparsh -Technologie zeigt, dass die robotere haptische Wahrnehmungstechnologie einen neuen Meilenstein erreicht hat. Sein Potenzial für raffinierte Manipulation und Human-Computer-Interaktion ist enorm, und seine zukünftigen Anwendungsaussichten sind es wert, sich darauf zu freuen.