Die neuesten Prozessoren von AMDs neuesten Strix Point -APU -Serien -Prozessoren zeigen erhebliche Vorteile in AI Big Language Model (LLM) und übertreffen die Intel Lunar Lake -Serie. Die für mobile Plattformen konzipierte Prozessorie ist so konzipiert, dass sie eine höhere Leistung und eine geringere Latenz bietet, um die wachsende Nachfrage nach KI -Workloads zu befriedigen. AMD betont die herausragende Leistung von Ryzen -KI -Prozessoren bei der Behandlung von LLM -Aufgaben und startet LM Studio -Tools, um die Verwendung von großsprachigen Modellen und niedrigeren Benutzerschwellen zu vereinfachen.

Kürzlich hat AMD seine neueste Strix Point APU -Serie veröffentlicht und die herausragende Leistung dieser Serie in AI Big Language Model (LLM) -Anwendungen (LLM) hervorgehoben, die weit über den Lunar Lake -Serie -Prozessoren von Intel liegt weit über. Angesichts der zunehmenden Nachfrage nach KI -Arbeitsbelastungen wird der Wettbewerb um Hardware immer heftiger. Um mit dem Markt fertig zu werden, hat AMD KI -Prozessoren auf den Markt gebracht, die für mobile Plattformen entwickelt wurden und für eine höhere Leistung und niedrigere Latenz ausgelegt sind.

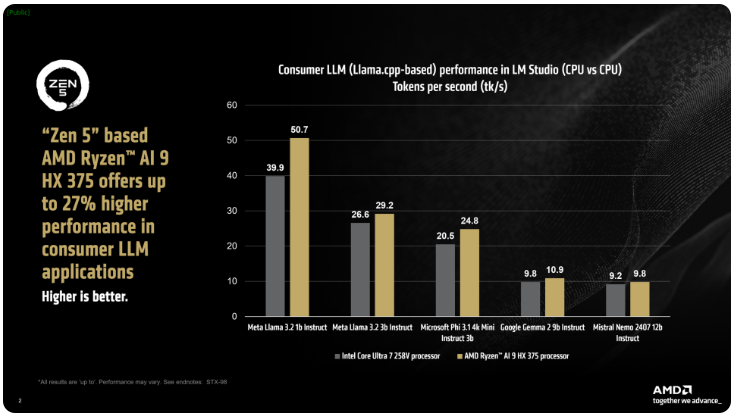

AMD sagte, dass die Ryzen AI300 -Prozessoren der IX Point -Serie die Anzahl der pro Sekunde verarbeiteten Token bei der Verarbeitung von AI -LLM -Aufgaben erheblich erhöhen können, und der Ryzen AI9375 hat eine Leistungsverbesserung von 27% im Vergleich zu Intels Core Ultra258V. Während der Kern-Ultra7V nicht das schnellste Modell in der L-Lake-Familie ist, liegt der Kern- und Fadenzahl in der Nähe der höheren Mondseeverarbeiter und zeigt die Wettbewerbsfähigkeit von AMD-Produkten in diesem Gebiet.

Das LM Studio-Tool von AMD ist eine konsumentenorientierte Anwendung, die auf dem Lama.CPP-Rahmen basiert, mit dem die Verwendung großer Sprachmodelle vereinfacht werden sollen. Dieses Framework optimiert die Leistung von x86CPUs, und obwohl keine GPU LLM benötigt, kann die Verwendung von GPUs die Verarbeitungsgeschwindigkeiten weiter beschleunigen. Laut Tests können der Ryzen AI9HX375 die 35 -mal niedrigere Latenz im Modell von Meta Lama3.21b erreichen und 50,7 -Token pro Sekunde verarbeiten.

Nicht nur das, die Strix Point -APU ist auch mit einer leistungsstarken Radeon -integrierten Grafikkarte basierend auf rDNA3.5 ausgestattet, die Aufgaben durch die Ulkan -API in die IGPU ablastet und die Leistung von LLM weiter verbessert. Mit der VGM -Technologie (Change Graphics Memory) kann der Ryzen AI300 -Prozessor die Speicherallokation optimieren, die Energieeffizienz verbessern und letztendlich eine Leistungsverbesserung von bis zu 60%erzielen.

Bei Vergleichstests verwendete AMD die gleichen Einstellungen auf der Intel AI -Playground -Plattform und stellte fest, dass der Ryzen AI9HX375 auf Microsoft Phi3.1 zu 87% schneller war Trotzdem werden die Ergebnisse im Vergleich zum Flaggschiff -Kern Ultra9288V im Lunar Lake Range noch interessanter sein. Derzeit konzentriert sich AMD darauf, die Verwendung von großsprachigen Modellen über LM Studio populärer zu gestalten, um mehr technische Benutzer zu erleichtern, um loszulegen.

Schlüsselpunkte:

AMD Strix Point APUs verbessert die Leistung um 27% gegenüber dem Intel Lunar Lake in AI -LLM -Anwendungen.

Der Ryzen AI9HX375 führt im Modell von Meta llama3.2 eine 3,5 -fache Latenz durch.

Das LM Studio-Tool ist so konzipiert, dass Großsprachmodelle für nicht-technische Benutzer einfacher und geeignet sind.

Kurz gesagt, die starke Leistung der AMD Strix Point-APU-Serie im Bereich KI-LLM-Anwendungen und die benutzerfreundlichen LM-Studio-Tools zeigen das aktive Layout und Wettbewerbsfähigkeit von AMD auf dem KI-Hardwaremarkt und bringen den Verbrauchern ein bequemeres Layout und Wettbewerbsfähigkeit. und effiziente KI -Erfahrung.