Training und Optimierung großer Sprachmodelle (LLMs) sind wichtige Herausforderungen im Bereich künstlicher Intelligenz. Effiziente Trainingsmethoden und Modellausgaben, die den menschlichen Werten entsprechen, sind entscheidend. Verstärkungslernen und menschliches Feedback (RLHF) sind eine Mainstream -LLM -Trainingsmethode. Zu diesem Zweck eröffnete das Bigbao Big Model -Team von Bytedance das RLHF -Framework namens Hybridflow, um diese Probleme zu lösen und neue Möglichkeiten für das LLM -Training zu bieten. Durch innovatives Design verbessert dieses Rahmen die Effizienz und Flexibilität des LLM -Trainings.

Große Modelle (LLM) wie GPT und Lama haben eine Revolution auf dem Gebiet der künstlichen Intelligenz ausgelöst, aber wie man diese riesigen Modelle effizient trainiert und sie im Einklang mit den menschlichen Werten zu machen, bleibt ein schwieriges Problem.

Das Verstärkungslernen und das menschliche Feedback (RLHF) wurden in den letzten Jahren häufig als wichtige LLM -Trainingsmethode eingesetzt, aber das traditionelle RLHF -Rahmen hat Einschränkungen bei Flexibilität, Effizienz und Skalierbarkeit.

Um diese Probleme zu lösen, Bytedance Doubao Big Model Team Open Source Der RLHF -Framework namens Hybridflow, der neue Möglichkeiten für das LLM -Training bringt.

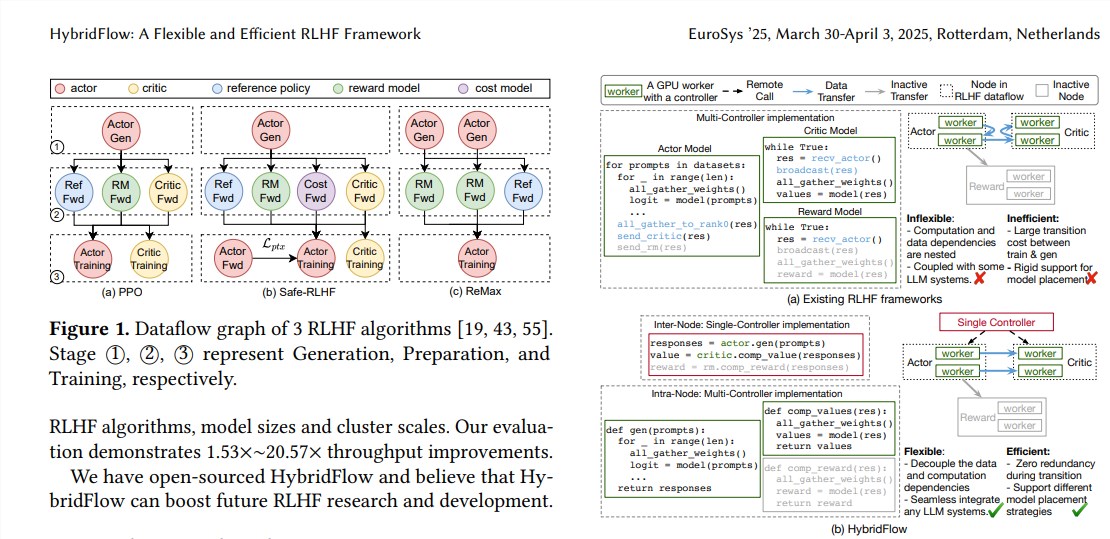

RLHF besteht normalerweise aus drei Stufen:

Er generiert das Schauspielermodell auf der Grundlage der Eingabeaufforderungen.

Schließlich werden diese Evaluierungsergebnisse verwendet, um das Schauspielermodell zu trainieren, um Text zu generieren, der eher den menschlichen Vorlieben entspricht. Herkömmliche RLHF -Frameworks verwenden normalerweise einen einzelnen Controller, um den gesamten Datenstrom zu verwalten. Dies ist jedoch für LLMs ineffizient, für die verteiltes Computing erforderlich ist.

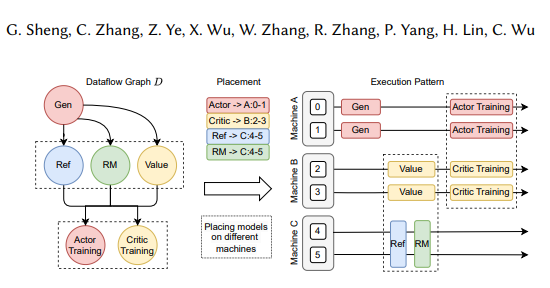

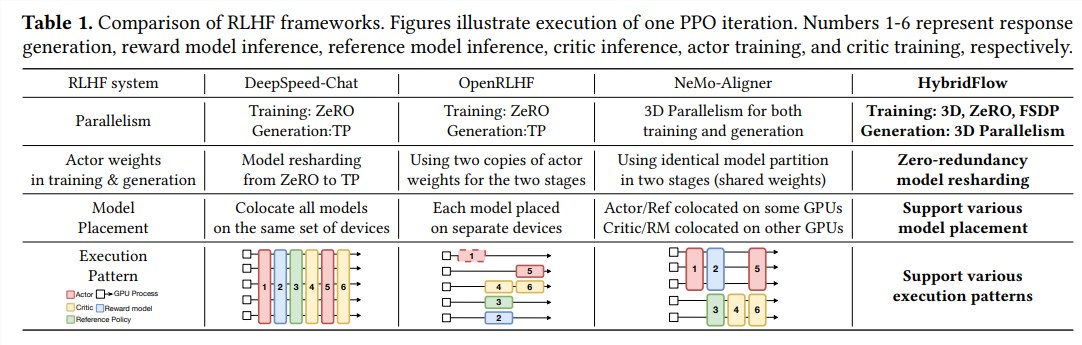

Das Hybridflow-Framework kombiniert innovativ einzelne und multi-kontrollierende Modi und entkoppelt komplexe Computer- und Datenabhängigkeiten durch hierarchisches API-Design, um eine flexible Darstellung und eine effiziente Ausführung von RLHF-Datenströmen zu ermöglichen.

Die Vorteile von Hybridflow spiegeln sich hauptsächlich in den folgenden drei Aspekten wider:

Flexible Unterstützung für eine Vielzahl von RLHF-Algorithmen und -Modellen: Hybridflow bietet eine modulare API, bei der Benutzer verschiedene RLHF-Algorithmen wie PPO, Remax und Safe-RLHF problemlos implementieren und erweitern können.

Effiziente Modellgewichtsreorganisation: Die 3D-Hybridenengine-Komponente unterstützt Akteurmodelle, um Modellgewichte während der Trainings- und Erzeugungsstadien effizient neu zu organisieren, wodurch die Redundanz und Kommunikationsaufwand der Speicher minimiert wird.

Automatisierte Modellbereitstellung und Parallelrichtlinie Auswahl: Automatische Zuordnungskomponenten können Modelle automatisch auf verschiedenen Geräten basierend auf Modelllast und Datenabhängigkeiten kartieren und die beste parallele Richtlinie auswählen, wodurch der Modellbereitstellungsprozess vereinfacht und die Schulungseffizienz verbessert wird.

Experimentelle Ergebnisse zeigen, dass der Durchsatz von Hybridflow bei der Ausführung verschiedener RLHF -Algorithmen bis zu 20,57 signifikant zunimmt. Die Open Source von Hybridflow wird leistungsstarke Tools für die RLHF -Forschung und -entwicklung bieten, um die Entwicklung der LLM -Technologie in Zukunft zu fördern.

Papieradresse: https://arxiv.org/pdf/2409.19256

Die Open Source des Hybridflow -Frameworks bietet eine effektive Möglichkeit, den LLM -Trainingsprozess zu verbessern. Wir freuen uns auf Hybridflow, eine größere Rolle in der zukünftigen LLM -Forschung zu spielen.